論文まとめ:Sentence Simplification via Large Language Models

Posted On 2023-04-13

- 論文:Sentence Simplification via Large Language Models

- 著者:Yutao Feng, Jipeng Qiang, Yun Li, Yunhao Yuan, Yi Zhu

- URL:https://arxiv.org/abs/2302.11957

- コード:https://github.com/BrettFyt/SS_Via_LLMs

目次

ざっくりいうと

- LLM(ChatGPT、GPT3.5)を使った文章平易化の研究

- 「分かりづらい文章を平易な文章に直して。文章の意味は変えないで」という指示を入れて平易化を行い、Few-shotに拡張可能

- LLMベースの手法が既存のSoTAを上回る

お気持ち

- ニューラルネットベースでの文章平易化の手法はいろいろ考案されているが、課題も多い

- Previous SoTA:Martinら(2022)は、約10億のCCNET(Wenzek et al., 2020)の文章から文章間の類似度を測定するために文埋め込みモデリングを採用し、その後、新しい並列SSコーパスを構築

- LLMベースでの文章平易化のパフォーマンスは検証されていない

- ChatGPTやGPT3.5でのシンプルなプロンプトで、Previous SoTAを超えたよ

手法・結果

手法

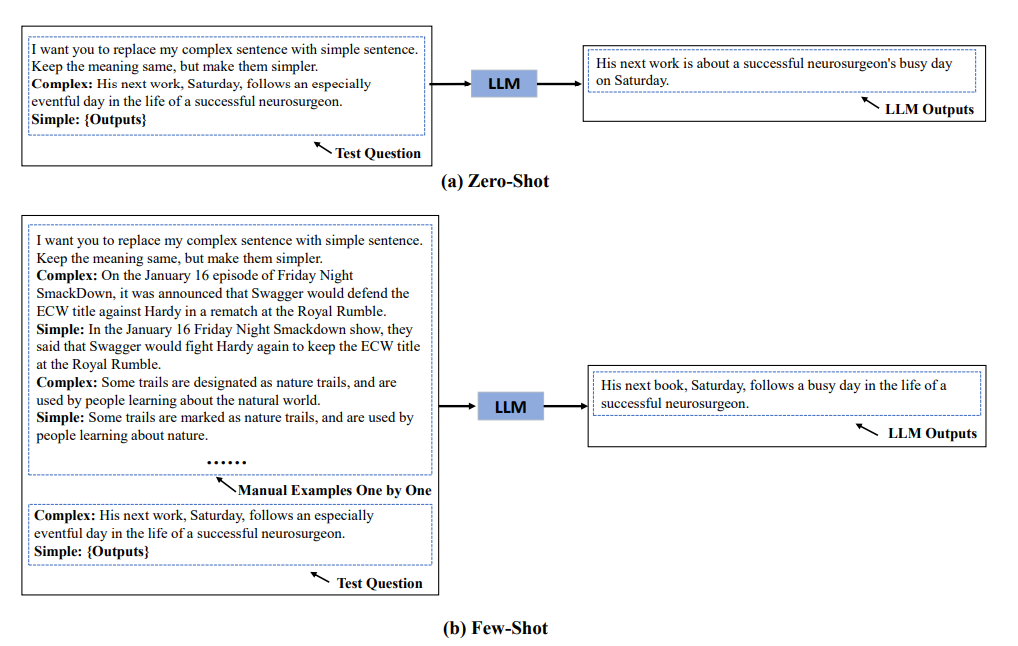

- 平易化したい文章をLLMに入れて、「意味は変えずに平易化してね」とやるだけ

- Few-shotへの拡張も可能

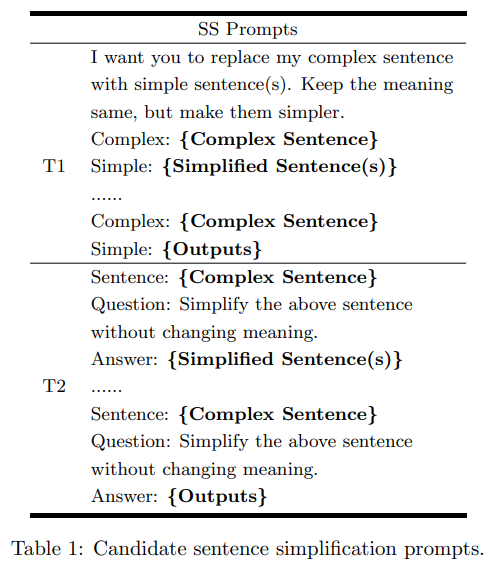

説明を前に置くべきかQuestionにおくべきか

- T1とT2という2つのプロンプトを考えた

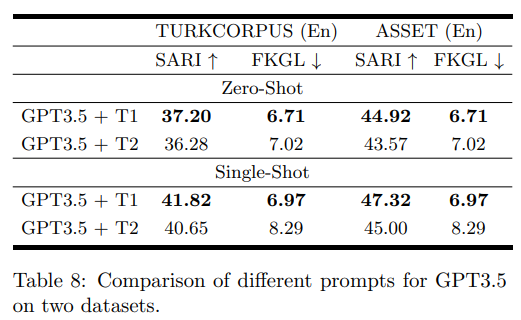

- 評価データセットは

- EN:TURKCORPUS(WikiLarge Testset)

- MultiLanguage:ASSET

- T1のほうが良かった

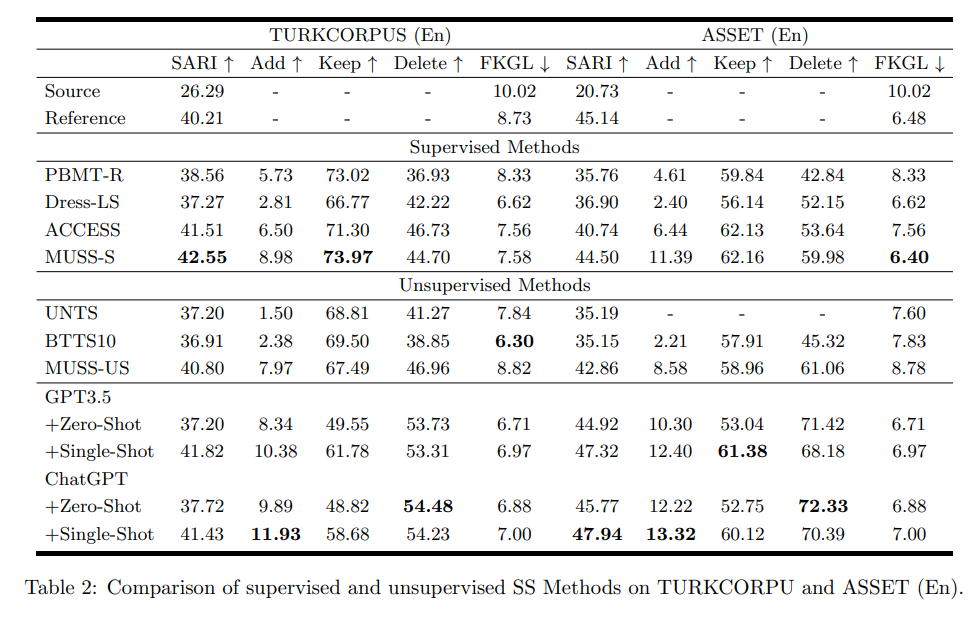

定量評価

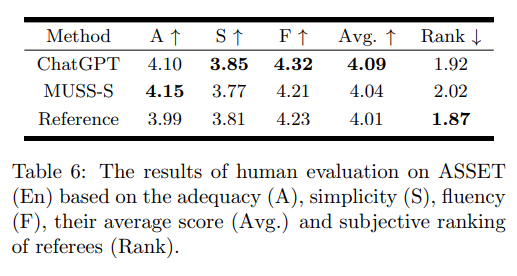

人間の評価

ChatGPTが既存の手法よりもわずかに良かった

所感

- 普通に使えそう

- 読むのが非常に楽な論文なので、時間ないときにおすすめ

- 論文としていいかは……

Shikoan's ML Blogの中の人が運営しているサークル「じゅ~しぃ~すくりぷと」の本のご案内

技術書コーナー

北海道の駅巡りコーナー