Arxiv RAGから見る最近のLLM(2024/8)

Arxivの検索APIを使い自動的にサーベイを行うArxiv RAGを最近のLLMで調べてみました。Gemini 1.5が非常に健闘し、またClaude 3.5 Sonnetも面白い健闘をしていました。逆に、GPT-4oはこの手の長文タスクだとかなり力不足で、他のモデルと比べるとやや見劣りする結果となりました。

目次

概要

以下の記事でやったArxivからの論文自動サーベイを最近のLLMで適用し、どのモデルがいいかを考えたい

Arxiv RAGによる論文サーベイの自動生成

https://blog.shikoan.com/arxiv_rag/

以下の記事で単純な論文要約タスクを比較したところ、Gemini 1.5系がかなり健闘していた。

論文要約性能で見る最近のLLM(2024/7)

https://blog.shikoan.com/paper-summary-llm/

タスクの違いは以下の通り

- 論文要約タスク

- 1本の論文を丸々与えて、テンプレート質問を回答させるタスク

- 論文サーベイタスク

- ある質問に対し(例:「物体検出のトレンドを教えて」)、ArxivのクエリワードをLLMで生成し、Arxivの検索APIを叩いてクエリの結果を取得し(タイトルとアブストラクトが取得できる)、それをベースにサーベイ回答させる(例:「物体検出のトレンドは2つあり、◯◯という手法を採用したのはA, B, Cという論文で…、☓☓という手法を採用したのは……」)RAGタスク

Arxiv RAGの概要

以下のパイプライン。詳細は前回の記事を参照

- Arxiv検索ワード生成

- Inputは質問文で、Outputは3種類の検索ワード

- 今回は

gpt-4-turboのJSONモードを使用 gpt-4oでは余計な検索ワードが入り(例:「lora trends 2023

」のような2023)、検索結果が大きく減ってしまう現象が見られた。GPT-4-Turboを使ったところ改善された

Retrievalはチューニングの余地はあるが、今回は対象外

- Arxivの検索APIを叩く

- タイトルとアブストラクトがAPIから得られる

- 検索ワード3種類適用し、結果をすべて統合

- 投稿日時が新しい順にソート

- 40件以上検索結果が得られたときは、2年以上前の論文を落とす

- タイトル+アブストラクトのEmbeddingを取得

text-embedding-3-largeを1024次元で使用

- EmbeddingでTSP(巡回セールスマン問題)を解き、それに沿ってソート

- 詳細は前回の記事を参照。これがあると生成結果に対するRecallが急に上がる

- 直感的な解釈としては、TSPによって似たような論文が近くにくるようになるため、まとめるというタスクの難易度が下がり、LLMがコンテクストを損なわずに生成しやすい

- アブストラクトの要約

- トークン数対策でアブストラクトに要約をかける。これは

gpt-4o-miniを使用

- トークン数対策でアブストラクトに要約をかける。これは

- RAGを実行

- Inputは最初の質問文+TSPでソートされたコンテクスト

- 今回ここのモデルを変える

- LangChainを使わずにOpenAIを使ってプロンプトをカスタマイズして実装している。プロンプトは非公開

試すモデル

今回比較するのは、RAGの部分のモデルの変更。具体的には以下のモデル

- claude-3-5-sonnet-20240620

- claude-3-haiku-20240307

- claude-3-opus-20240229

- claude-3-sonnet-20240229

- gemini-1.5-flash

- gemini-1.5-pro

- gpt-4o-2024-05-13

- gpt-4o-2024-08-06

- gpt-4o-mini-2024-07-18

Geminiは、Gemini-1.5-Pro-Exp-0801も試すべきだが、現在のリージョンで使えなかったので割愛

質問

以下の10個の質問で試す

| qid | 質問 |

|---|---|

| 0 | 画像生成のLoRA周りの技術トレンドを網羅的に知りたいです |

| 1 | 動画生成の研究についてサーベイしてください |

| 2 | 人物トラッキングの研究について教えて |

| 3 | LoRAとVLMを融合して画像生成のクォリティを上げる研究はありますか? |

| 4 | NeRFの進化の研究について教えて |

| 5 | Gaussian Splattingの最先端はどうなっている? |

| 6 | 画像系の基盤モデルはどんなのが出ている? |

| 7 | LLMの量子化について研究を教えて |

| 8 | Mambaモデルについてまとめて |

| 9 | RAGの評価指標について網羅的に教えて |

評価指標

生成結果に対して、「ユニークな論文の名称・略称がいくつあるか教えて下さい」とLLMに聞いて、生成結果内に含まれる論文の数を数える。

これをコンテクストの母数で割ると、実質的にはRecallとなり、サーベイだとコンテクストの結果をなるべく落とさずに生成できたほうがいいので、Recallは高いほうがよく、定量評価可能。

def run_evaluation(target_file):

with open(target_file, "r", encoding="utf-8") as f:

contents = f.read()

client = openai.OpenAI(timeout=180, max_retries=5)

response = client.chat.completions.create(

model="gpt-4o",

messages=[

{"role": "system", "content": "ユーザーの投稿に、ユニークな論文の名称・略称がいくつあるか数えてください。リストアップした上で数えて"},

{"role": "user", "content": contents},

],

temperature=0.0,

max_tokens=4096)

count_content = response.choices[0].message.content

response = client.chat.completions.create(

model="gpt-4o",

messages=[

{"role": "system", "content": "ユーザーの投稿に、ユニークな論文の名称・略称がいくつあるか数えてください。答えはJSONで、countをキーとして数値で教えて"},

{"role": "user", "content": count_content},

],

temperature=0.0,

response_format={ "type": "json_object" },

max_tokens=512)

count = json.loads(response.choices[0].message.content)["count"]

return count

詳細な設定

- 検索ワードの生成結果にランダム性があるので、10個の質問に対し、クエリを各5回実行(50個のクエリ)

- 生成にもランダム性があるため、各同一クエリに対し、1個のLLMが3回実行(150回)

結果

| llm | Mean Recall |

|---|---|

| claude-3-5-sonnet-20240620 | 0.300315 |

| claude-3-haiku-20240307 | 0.236468 |

| claude-3-opus-20240229 | 0.410184 |

| claude-3-sonnet-20240229 | 0.337893 |

| gemini-1.5-flash | 0.428788 |

| gemini-1.5-pro | 0.396497 |

| gpt-4o-2024-05-13 | 0.258163 |

| gpt-4o-2024-08-06 | 0.217658 |

| gpt-4o-mini-2024-07-18 | 0.221461 |

- Gemini1.5が特に強い結果になった

- Claude3 Opusは1個のケースで、Recall1.767という外れ値(コンテクストにない略称をLLMの知識で補っている)があり、これをRecall1として計算すると実質的なRecallは0.334だった。Claude3のOpusでもGemini1.5には勝っていない。

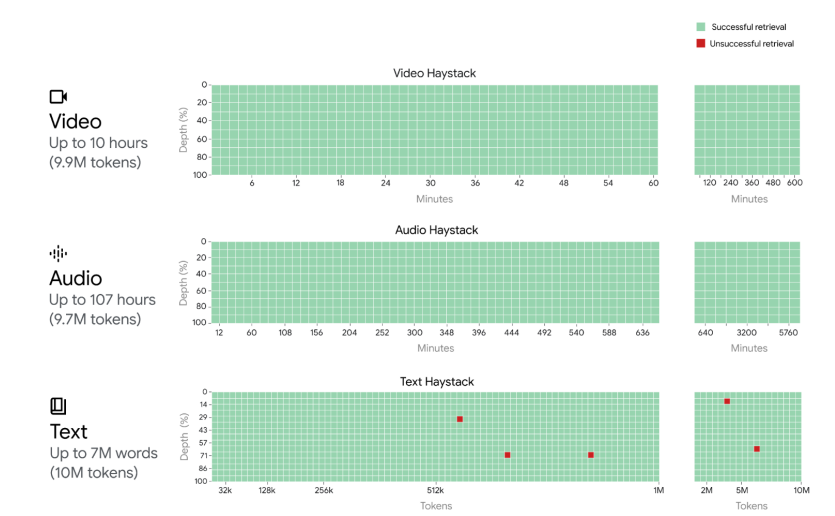

Needle-in-a-haystackとの関係

この手の「長文コンテクストを取りこぼさずにまとめる」(よってRecallが上がる)という特性は、Needle-in-a-haystackである程度測れる。Gemini 1.5のTechnical Reportで書かれていた図です。

詳細結果

Recallについて、「mean±sd」で表記

| qid | 0 | 1 | 2 | 3 | 4 | 5 |

|---|---|---|---|---|---|---|

| claude-3-5-sonnet-20240620 | 0.488 ± 0.08 | 0.195 ± 0.052 | 0.184 ± 0.026 | 1.0 ± 0.0 | 0.274 ± 0.176 | 0.287 ± 0.121 |

| claude-3-haiku-20240307 | 0.396 ± 0.116 | 0.133 ± 0.104 | 0.054 ± 0.056 | 1.0 ± 0.0 | 0.304 ± 0.202 | 0.227 ± 0.125 |

| claude-3-opus-20240229 | 0.441 ± 0.191 | 0.337 ± 0.287 | 0.19 ± 0.044 | 1.767 ± 1.178 | 0.431 ± 0.237 | 0.279 ± 0.126 |

| claude-3-sonnet-20240229 | 0.658 ± 0.194 | 0.348 ± 0.173 | 0.294 ± 0.088 | 1.0 ± 0.0 | 0.324 ± 0.203 | 0.243 ± 0.105 |

| gemini-1.5-flash | 0.484 ± 0.31 | 0.391 ± 0.347 | 0.261 ± 0.293 | 1.1 ± 0.761 | 0.457 ± 0.291 | 0.366 ± 0.309 |

| gemini-1.5-pro | 0.684 ± 0.192 | 0.359 ± 0.29 | 0.302 ± 0.309 | 0.967 ± 0.129 | 0.643 ± 0.29 | 0.213 ± 0.086 |

| gpt-4o-2024-05-13 | 0.271 ± 0.022 | 0.176 ± 0.071 | 0.133 ± 0.025 | 1.0 ± 0.0 | 0.288 ± 0.257 | 0.168 ± 0.062 |

| gpt-4o-2024-08-06 | 0.226 ± 0.037 | 0.128 ± 0.044 | 0.105 ± 0.018 | 1.033 ± 0.129 | 0.188 ± 0.143 | 0.131 ± 0.051 |

| gpt-4o-mini-2024-07-18 | 0.242 ± 0.023 | 0.151 ± 0.057 | 0.089 ± 0.031 | 1.067 ± 0.258 | 0.192 ± 0.157 | 0.128 ± 0.049 |

| Mean Context | 46 | 65.6 | 61 | 2 | 64 | 77.2 |

| qid | 6 | 7 | 8 | 9 | Mean Recall |

|---|---|---|---|---|---|

| claude-3-5-sonnet-20240620 | 0.07 ± 0.015 | 0.131 ± 0.019 | 0.122 ± 0.066 | 0.253 ± 0.063 | 0.300 |

| claude-3-haiku-20240307 | 0.053 ± 0.026 | 0.055 ± 0.068 | 0.023 ± 0.02 | 0.121 ± 0.059 | 0.236 |

| claude-3-opus-20240229 | 0.059 ± 0.023 | 0.193 ± 0.083 | 0.171 ± 0.131 | 0.235 ± 0.092 | 0.410 |

| claude-3-sonnet-20240229 | 0.063 ± 0.02 | 0.171 ± 0.074 | 0.118 ± 0.092 | 0.16 ± 0.044 | 0.338 |

| gemini-1.5-flash | 0.341 ± 0.183 | 0.295 ± 0.334 | 0.41 ± 0.47 | 0.183 ± 0.244 | 0.429 |

| gemini-1.5-pro | 0.134 ± 0.052 | 0.179 ± 0.175 | 0.155 ± 0.241 | 0.33 ± 0.249 | 0.396 |

| gpt-4o-2024-05-13 | 0.075 ± 0.015 | 0.086 ± 0.018 | 0.075 ± 0.021 | 0.31 ± 0.235 | 0.258 |

| gpt-4o-2024-08-06 | 0.058 ± 0.009 | 0.073 ± 0.016 | 0.065 ± 0.018 | 0.169 ± 0.037 | 0.218 |

| gpt-4o-mini-2024-07-18 | 0.05 ± 0.008 | 0.066 ± 0.018 | 0.074 ± 0.038 | 0.156 ± 0.032 | 0.221 |

| Mean Context | 158.4 | 135.8 | 120.8 | 52.2 |

- qid=6~8のように、特に長コンテクストのケースでGemini1.5の優位性が際立っている

Gemini 1.5 FlashとGemini 1.5 Proの比較

定量的にはあまり差が少ないが、定性的にどの程度生成結果に差が出るのか比較したい。

LLMによる比較

LLMにGemini 1.5 Flashと1.5 Proの生成結果をA/Bテストで評価させる。

評価モデル(縦軸)は、GPT-4o, GPT-4-Turbo、Claude 3.5 Sonnetとした。生成モデル(横軸)が良いと評価された数を比較している。

結果は以下の通りで、GPT系はほぼ互角か若干Flashのほうが好み(何回か試したところブレがあり互角の結果もあった)、Claude 3.5はProのほうを好んでいる。Claudeは以前から長文生成が得意な傾向があったので、Claude 3.5クラスのモデルになるとFlashとProの差を見切れているといえるだろう。

| 評価モデル | Gemini 1.5 Flash | Gemini 1.5 Pro |

|---|---|---|

| GPT-4o | 86 | 64 |

| GPT-4-Turbo | 83 | 67 |

| Claude 3.5 Sonnet | 89 | 61 |

import glob

import random

import json

import openai

import os

import concurrent.futures

from collections import Counter

from tqdm import tqdm

import anthropic

SYSTEM_PROMPT = """以下の質問について、ユーザーから与えられるA, Bのどちらの回答が、より質問に対して適切な回答か教えて下さい。答えはJSON形式で、answerをキーとし、「A, B」のいずれかで答えてください。

答えだけJSONで教えてください。理由は不要です。

質問:{question}"""

USER_PROMPT = """# 回答A

{answer_a}

# 回答B

{answer_b}

"""

def make_user_prompt(file_key):

model_a = random.choice(["gemini-1.5-pro", "gemini-1.5-flash"])

if model_a == "gemini-1.5-pro":

model_b = "gemini-1.5-flash"

else:

model_b = "gemini-1.5-pro"

with open(f"output/{model_a}/{file_key}", "r", encoding="utf-8") as f:

answer_a = f.read()

with open(f"output/{model_b}/{file_key}", "r", encoding="utf-8") as f:

answer_b = f.read()

user_prompt = USER_PROMPT.format(answer_a=answer_a, answer_b=answer_b)

return user_prompt, model_a, model_b

def run_judge_gpt(question, file_key, llm_model="gpt-4o"):

system_prompt = SYSTEM_PROMPT.format(question=question)

user_prompt, model_a, model_b = make_user_prompt(file_key)

client = openai.OpenAI(timeout=180, max_retries=5)

response = client.chat.completions.create(

model=llm_model,

messages=[

{"role": "system", "content": system_prompt},

{"role": "user", "content": user_prompt},

],

temperature=0.0,

response_format={ "type": "json_object" },

max_tokens=512)

judge = json.loads(response.choices[0].message.content)["answer"]

if judge == "A":

judge_model = model_a

elif judge == "B":

judge_model = model_b

else:

raise ValueError("Invalid judge: " + judge)

return judge_model

def run_judge_claude(question, file_key, llm_model="claude-3-5-sonnet-20240620"):

system_prompt = SYSTEM_PROMPT.format(question=question)

user_prompt, model_a, model_b = make_user_prompt(file_key)

client = anthropic.Client()

response = client.messages.create(

model=llm_model,

system=system_prompt,

messages=[

{"role": "user", "content": user_prompt},

{"role": "assistant", "content": "{"},

],

temperature=0.0,

max_tokens=512)

print("{" + response.content[0].text.strip())

judge = json.loads("{" + response.content[0].text.strip())["answer"]

if judge == "A":

judge_model = model_a

elif judge == "B":

judge_model = model_b

定性評価

3パターンぐらいピックアップして評価

画像生成のLoRA周りの技術トレンドを網羅的に知りたいです

※q0_1_t2

Gemini 1.5 Flash

## 画像生成におけるLoRA技術のトレンド

近年、画像生成モデルにおいて、LoRA (Low-Rank Adaptation) は、モデルの効率的な微調整とパーソナライズを実現する重要な技術として注目されています。本稿では、LoRA周りの技術トレンドを網羅的に解説します。

### LoRAの利点と課題

LoRAは、大規模な事前学習済みモデルを特定のタスクやデータセットに適応させるためのパラメータ効率的な手法です。従来の微調整方法と比較して、LoRAは以下のような利点があります。

* **パラメータ数の削減:** LoRAは、元のモデルのほとんどのパラメータを固定し、少量の低ランクアダプタパラメータのみを学習するため、メモリ消費量と計算コストを大幅に削減できます。

* **高速な微調整:** LoRAは、従来の微調整方法よりもはるかに少ないパラメータを学習するため、微調整プロセスを高速化できます。

* **汎用性:** LoRAは、さまざまな画像生成モデル(Stable Diffusion、DALL-Eなど)に適用できます。

一方で、LoRAには以下のような課題も存在します。

* **複数のLoRAの組み合わせ:** 複数のLoRAを組み合わせる際に、各LoRAの概念が混ざり合ったり、特定の概念が消失したりする問題が発生することがあります。

* **概念の保持:** 特定の概念(人物、動物など)を保持しながら、画像を生成することは困難です。

* **スタイルの制御:** 生成された画像のスタイルを正確に制御することは難しい場合があります。

### LoRAの技術トレンド

これらの課題を克服するために、研究者はさまざまなLoRA関連技術を開発しています。

**1. 複数のLoRAの組み合わせ**

* **ZipLoRA (2023)**: 異なる被写体とスタイルに対して別々に学習されたLoRAを効果的にマージすることで、任意の被写体を任意のスタイルで生成することを可能にする手法です。 [ZipLoRA: Any Subject in Any Style by Effectively Merging LoRAs](http://arxiv.org/abs/2311.13600v1)

* **MoLE (2024)**: 階層的な制御と柔軟なブランチ選択を用いて、複数のLoRAモデルを効果的に融合する手法です。 [Mixture of LoRA Experts](http://arxiv.org/abs/2404.13628v1)

* **CLoRA (2024)**: 複数のLoRAモデルの潜在表現を融合し、各概念の特徴を正確に反映した合成画像を生成する手法です。 [CLoRA: A Contrastive Approach to Compose Multiple LoRA Models](http://arxiv.org/abs/2403.19776v1)

**2. 概念の保持**

* **LoRA-Composer (2024)**: 概念注入制約、クロスアテンションメカニズム、概念分離制約などを導入することで、複数の概念を保持した画像を生成する手法です。 [LoRA-Composer: Leveraging Low-Rank Adaptation for Multi-Concept Customization in Training-Free Diffusion Models](http://arxiv.org/abs/2403.11627v2)

* **OMG (2024)**: 2段階のサンプリングアプローチを用いて、オクルージョンを管理し、複数の概念を統合することで、パーソナライズされた画像を生成する手法です。 [OMG: Occlusion-friendly Personalized Multi-concept Generation in Diffusion Models](http://arxiv.org/abs/2403.10983v2)

**3. スタイルの制御**

* **StyleInject (2024)**: 入力特性に基づいて視覚特徴の分散を調整する複数の並列低ランクパラメータ行列を導入することで、動的なスタイル適応を実現する手法です。 [StyleInject: Parameter Efficient Tuning of Text-to-Image Diffusion Models](http://arxiv.org/abs/2401.13942v2)

* **TriLoRA (2024)**: 特異値分解 (SVD) とLoRAを組み合わせることで、微調整の効率と出力品質を向上させ、過剰適合のリスクを軽減し、生成された画像の安定性を向上させる手法です。 [TriLoRA: Integrating SVD for Advanced Style Personalization in Text-to-Image Generation](http://arxiv.org/abs/2405.11236v2)

**4. LoRAの効率化**

* **DiffuseKronA (2024)**: クロンネッカー積ベースの適応モジュールを導入することで、従来の手法と比較して学習可能なパラメータ数を最大99.947%削減し、画像合成品質を向上させる手法です。 [DiffuseKronA: A Parameter Efficient Fine-tuning Method for Personalized Diffusion Models](http://arxiv.org/abs/2402.17412v2)

* **SHiRA (2024)**: ベースモデルのウェイトのわずか1-2%のみを調整することで、推論オーバーヘッドを排除し、アダプタ間の迅速な切り替えを可能にする手法です。 [Sparse High Rank Adapters](http://arxiv.org/abs/2406.13175v1)

* **CaraServe (2024)**: CPUアシストアプローチとランク認識スケジューリングアルゴリズムを用いて、複数のLoRAアダプタを効率的に提供するシステムです。 [CaraServe: CPU-Assisted and Rank-Aware LoRA Serving for Generative LLM Inference](http://arxiv.org/abs/2401.11240v1)

**5. LoRAの応用**

* **MuseumMaker (2024)**: スタイル蒸留損失モジュールを導入することで、新しいスタイルを学習しながら、過去のスタイルを保持する手法です。 [MuseumMaker: Continual Style Customization without Catastrophic Forgetting](http://arxiv.org/abs/2404.16612v2)

* **ProcessPainter (2024)**: テキストプロンプトから詳細なステップバイステップのペイントプロセスを生成する手法です。 [ProcessPainter: Learn Painting Process from Sequence Data](http://arxiv.org/abs/2406.06062v2)

* **DreamVTON (2024)**: 2D画像のみを使用して、3D仮想試着 (VTON) をカスタマイズする手法です。 [DreamVTON: Customizing 3D Virtual Try-on with Personalized Diffusion Models](http://arxiv.org/abs/2407.16511v1)

### まとめ

LoRAは、画像生成モデルの効率的な微調整とパーソナライズを実現する重要な技術です。研究者は、複数のLoRAの組み合わせ、概念の保持、スタイルの制御、LoRAの効率化、LoRAの応用など、さまざまな課題を克服するための技術を開発しています。これらの技術は、画像生成モデルの性能を向上させ、より創造的で多様な画像を生成することを可能にするでしょう。

Gemini 1.5 Pro

## 画像生成におけるLoRA周辺技術のトレンド

LoRA(Low-Rank Adaptation)は、大規模なテキスト-画像生成モデルのファインチューニングにおいて、計算コストとメモリ使用量を削減する効果的な手法として注目されています。本稿では、提供された論文に基づいて、画像生成におけるLoRA周辺技術のトレンドを以下のカテゴリに分けて解説します。

### 1. LoRAの効率化と高性能化

* **軽量化・高速化:**

* **DiffuseKronA** [DK] は、Kronecker積を用いることでLoRAのパラメータ数を従来手法と比較して最大99.947%削減し、画像の品質とハイパーパラメータ間の一貫性を向上させています。[DK](http://arxiv.org/abs/2402.17412v2)

* **LCM-LoRA** [LL] は、Latent Consistency Models (LCMs) とLoRA蒸留を組み合わせることで、学習時間を短縮しつつ高品質な画像生成を実現しています。[LL](http://arxiv.org/abs/2311.05556v1)

* **SwiftDiffusion** [SD] は、LoRAの読み込みとパッチ適用に伴うオーバーヘッドを最小限に抑えながら、並列計算と複数GPUへのタスク分散によってサービングの高速化を実現しています。[SD](http://arxiv.org/abs/2407.02031v1)

* **高品質化:**

* **DiffLoRA** [DL] は、拡散モデルをハイパーネットワークとして使用し、参照画像からパーソナライズされたLoRA重みを生成することで、追加学習なしにリアルタイムのパーソナライゼーションを実現しています。[DL](http://arxiv.org/abs/2408.06740v1)

* **StyleInject** [SI] は、入力画像の特徴に応じて視覚特徴量の分散を調整する複数の並列低ランクパラメータ行列を導入することで、意味的一貫性とユーザーの好みに合った画像生成を実現しています。[SI](http://arxiv.org/abs/2401.13942v2)

* **TriLoRA** [TL] は、特異値分解 (SVD) をLoRAフレームワークに統合することで、ファインチューニングの効率と出力品質を向上させ、オーバーフィッティングのリスクを効果的に低減しています。[TL](http://arxiv.org/abs/2405.11236v2)

### 2. LoRAの適用範囲の拡大

* **多様なスタイル・概念の表現:**

* **ZipLoRA** [ZL] は、複数のLoRAを効果的にマージすることで、任意の被写体を任意のスタイルで生成することを可能にし、従来手法の課題であった被写体またはスタイルのいずれか一方の忠実度が犠牲になる問題を克服しています。[ZL](http://arxiv.org/abs/2311.13600v1)

* **StyleAdapter** [SA] は、テキストプロンプトとスタイル参照を独立して処理する2パス クロスアテンションモジュールと3つの分離戦略を採用することで、事前に学習していないスタイルでも、プロンプトの内容を正確に反映した高品質な画像を生成できます。[SA](http://arxiv.org/abs/2309.01770v1)

* **LoRA-Composer** [LC] は、複数のLoRAを概念の注入と分離の制約を用いて統合することで、複数の概念の可視性と識別性を高め、概念の混同と消失の問題に対処しています。[LC](http://arxiv.org/abs/2403.11627v2)

* **制御性の向上:**

* **TextHarmony** [TH] は、Slide-LoRAを用いることで、単一のモデル内でモダリティ固有とモダリティ非依存のエキスパートを組み合わせ、より cohérent な生成プロセスを実現し、視覚テキストの理解と生成の両方のタスクにおいて大幅な改善を示しています。[TH](http://arxiv.org/abs/2407.16364v1)

* **Lateralization LoRA** [LL2] は、線形適応と畳み込み適応を組み合わせることで、テキストと画像のモダリティを個別に調整することを可能にし、複雑なインターリーブタスクのパフォーマンスを大幅に向上させています。[LL2](http://arxiv.org/abs/2407.03604v1)

* **ControlNeXt** [CN] は、重い追加ブランチの必要性を減らすことでアーキテクチャを簡素化し、計算コストを削減しながら、CrossNormalization (CN) によって学習の速度と安定性を向上させています。[CN](http://arxiv.org/abs/2408.06070v2)

* **3D生成への応用:**

* **Boosting3D** [B3D] は、オブジェクトレベルのLoRAを導入し、Neural Radiance Field (NeRF) と共に学習することで、生成されるオブジェクトの幾何学的構造を反復的に改善し、単一画像からの3Dオブジェクト生成において、従来手法を上回る高忠実度を実現しています。[B3D](http://arxiv.org/abs/2311.13617v1)

* **DreamVTON** [DV] は、パーソナライズされた拡散モデルを活用し、衣服や個人特性に基づいて3D人体モデルの生成を強化することで、高価な3Dデータセットを使用せずに、画像データのみを用いた3Dバーチャルトライオンを実現しています。[DV](http://arxiv.org/abs/2407.16511v1)

### 3. LoRAの新たな活用法

* **データセット生成:**

* **DataDream** [DD] は、少数の実際の画像を使用してテキスト-画像拡散モデルのLoRA重みをファインチューニングし、合成データセットを生成することで、少数ショット学習シナリオにおいて、従来手法を上回る有効性を示しています。[DD](http://arxiv.org/abs/2407.10910v2)

* **知識の発見:**

* **Intrinsic LoRA** [IL] は、拡散モデル、GAN、自己回帰モデルなどの様々な生成モデルから、法線、深度、アルベド、シェーディングなどのシーンの真相を抽出するためにLoRAを用いることで、従来の教師あり学習に匹敵する精度を達成しています。[IL](http://arxiv.org/abs/2311.17137v2)

* **医療画像合成:**

* **SeLoRA** [SL] は、学習中に潜在拡散モデル (LDM) の異なる層にわたってランクを動的に調整する自己拡張型低ランク適応モジュールを導入することで、医療データのファインチューニングにおける効率を維持しながら、合成品質を向上させています。[SL](http://arxiv.org/abs/2408.07196v1)

### 4. LoRAの課題と今後の展望

* **複数アダプターの効率的な統合:**

* **Sparse High Rank Adapters (SHiRA)** [SH] は、ベースモデルの重みの1〜2%のみを調整することで、複数アダプター使用時の推論レイテンシと概念損失の課題に対処し、効率的なアダプターの融合を実現しています。[SH](http://arxiv.org/abs/2406.13175v1)

* **CaraServe** [CS] は、CPU支援アプローチとランク認識スケジューリングアルゴリズムによって、複数LoRAアダプターのGPUへの読み込みに伴うコールドスタートによるレイテンシを軽減し、サービスレベル目標達成率を最大99%まで向上させています。[CS](http://arxiv.org/abs/2401.11240v1)

* **MoLE** [MoLE] は、階層的制御と柔軟なブランチ選択を利用することで、LoRAフュージョンのパフォーマンスを向上させるだけでなく、効果的な統合に必要な適応性を維持しています。[MoLE](http://arxiv.org/abs/2404.13628v1)

* **Mixture-of-Subspaces LoRA (MoSLoRA)** [MSL] は、LoRAの重みを2つの部分空間に分解し、それらを混合することで、従来のLoRAのパフォーマンスを向上させ、常識推論やテキスト-画像生成などの様々なタスクで、標準的なLoRAよりも優れたパフォーマンスを発揮します。[MSL](http://arxiv.org/abs/2406.11909v2)

* **バイアスの軽減:**

* **Bias-Aware Low-Rank Adaptation (BA-LoRA)** [BAL] は、事前学習データからのバイアスの継承問題を軽減するために、一貫性、多様性、特異値分解の3つの正則化戦略を採用し、LoRAなどの既存手法よりも効果的にバイアスを削減し、より信頼性の高い出力を実現しています。[BAL](http://arxiv.org/abs/2408.04556v1)

* **制御可能なパラメータ生成:**

* **COND P-DIFF** [CPD] は、オートエンコーダを用いて効率的な潜在表現を作成し、条件付き潜在拡散モデルを用いて特定のタスク条件に基づいてモデルパラメータを合成することで、従来の最適化手法とは異なるパラメータ分布を示し、汎化能力の向上を示唆しています。[CPD](http://arxiv.org/abs/2408.01415v1)

これらの研究は、LoRAが画像生成における効率的かつ効果的なファインチューニング手法として、今後も進化し続けることを示唆しています。特に、複数アダプターの効率的な統合、バイアスの軽減、制御可能なパラメータ生成といった課題への取り組みは、LoRAの適用範囲をさらに拡大し、より高品質で多様な画像生成を可能にすることが期待されます。

→Proのほうが体系的に書いている。体系化しようとして落ちる部分はあるので、網羅性はFlashのほうがいいかもしれない

NeRFの進化の研究について教えて

※q4_0_t2

Gemini 1.5 Flash

## NeRFの進化の研究

NeRF(Neural Radiance Field)は、近年注目を集めている3Dシーン表現技術です。様々な研究がなされ、その性能は飛躍的に向上しています。以下に、NeRFの進化の研究について、論文を参考に詳しく解説します。

### 従来のNeRFの課題と克服

従来のNeRFは、高画質の3Dシーンを生成できる一方で、いくつかの課題がありました。

* **計算コストの高さ:** 従来のNeRFは、高画質の画像を生成するために、多くの計算リソースを必要としていました。そのため、リアルタイムでのレンダリングや、リソースの限られたデバイスでの利用が困難でした。

* **学習データの量:** 従来のNeRFは、高画質の3Dシーンを生成するために、多くの学習データ(複数視点からの画像)を必要としていました。そのため、学習データの収集が困難なシーンや、データ量の少ないシーンでは、十分な性能を発揮することができませんでした。

* **編集の難しさ:** 従来のNeRFは、生成された3Dシーンを編集することが困難でした。そのため、生成されたシーンを自由に編集したり、新たなオブジェクトを追加したりすることができませんでした。

これらの課題を克服するために、様々な研究が行われています。

### 計算コストの低減

* **Potamoi (Potamoi: Accelerating Neural Rendering via a Unified Streaming Architecture)** [http://arxiv.org/abs/2408.06608v1](http://arxiv.org/abs/2408.06608v1) は、リソースの限られたデバイスでもリアルタイムでのNeRFレンダリングを実現するために、アルゴリズムとアーキテクチャを統合した設計を採用しています。SpaRWと呼ばれるプラグアンドプレイアルゴリズムにより、フレームあたりの計算負荷を削減し、統一されたストリーミングパイプラインによりメモリアクセスを最適化することで、DRAMアクセスを最小限に抑え、SRAMバンクの競合を排除しています。その結果、ベースラインと比較して53.1倍の高速化と67.7倍のエネルギー削減を実現し、高い画質を維持しています。

* **MIMO-NeRF (MIMO-NeRF: Fast Neural Rendering with Multi-input Multi-output Neural Radiance Fields)** [http://arxiv.org/abs/2310.01821v1](http://arxiv.org/abs/2310.01821v1) は、マルチ入力マルチ出力(MIMO)ニューラルラジアンフィールドを用いて、ノベルビュー合成におけるニューラルレンダリングの速度を向上させる手法です。従来のNeRFは、単一入力単一出力(SISO)の多層パーセプトロン(MLP)に依存しており、3D座標とビュー方向を個別に処理するため、レンダリング時間が長くなっていました。MIMO-NeRFは、入力グループを処理するMIMO MLPを採用することで、必要なMLP数を大幅に削減しています。しかし、これにより、入力の変動に基づいて色と体積密度の出力に曖昧さが生じます。この課題に対処するために、著者らは、複数の再構築されたMLPを使用してMIMO MLPを正規化する自己教師あり学習方法を提案し、事前学習なしで性能を向上させています。実験結果では、MIMO-NeRFはレンダリング速度と品質のバランスが良く、既存の高速NeRF技術と統合できることが示されています。

* **Nerfstudio (Nerfstudio: A Modular Framework for Neural Radiance Field Development)** [http://arxiv.org/abs/2302.04264v4](http://arxiv.org/abs/2302.04264v4) は、NeRFの開発と展開を促進するためのモジュール型フレームワークです。NeRFベースの方法の実装における複雑さと非効率性を解決し、研究と実用的なアプリケーションを促進します。Nerfstudioは、ユーザーがさまざまなコンポーネントを簡単に統合し、データをリアルタイムで視覚化し、さまざまな形式で結果をエクスポートできるプラグアンドプレイアーキテクチャを提供します。さらに、このフレームワークは、最近の分野の進歩を活用して、速度と品質のバランスを最適化するNerfactoという方法を導入しています。このプロジェクトはオープンソースであり、コミュニティの協力とさらなるイノベーションを促進しています。

* **VQ-NeRF (VQ-NeRF: Vector Quantization Enhances Implicit Neural Representations)** [http://arxiv.org/abs/2310.14487v1](http://arxiv.org/abs/2310.14487v1) は、ニューラルラジアンフィールド(NeRF)のサンプル空間を低解像度まで削減し、事前学習済みの変分オートエンコーダー(VAE)デコーダーを使用して復元することで、レンダリング時間を効果的に短縮するベクトル量子化を用いた手法です。高圧縮時に微細なテクスチャの詳細を維持するという課題に対処するために、著者らは、圧縮された解像度と元の解像度の両方でNeRFモデルを最適化するマルチスケールサンプリングスキームを導入しています。さらに、セマンティックロス関数を統合することで、3D再構築の幾何学的精度とセマンティック整合性を向上させています。さまざまなデータセットでの実験結果から、VQ-NeRFはレンダリング品質と効率のバランスが優れていることが示されています。

* **CodecNeRF (CodecNeRF: Toward Fast Encoding and Decoding, Compact, and High-quality Novel-view Synthesis)** [http://arxiv.org/abs/2404.04913v2](http://arxiv.org/abs/2404.04913v2) は、3DメディアアプリケーションのためのNeRFを改善するための新しいアプローチです。この研究では、NeRFのエンコードとデコードの速度が遅く、モデルサイズが大きく、高品質のレンダリングが必要とされるため、日常的なメディア形式でのNeRFの普及が妨げられているという問題に対処しています。CodecNeRFは、単一のフォワードパスでNeRF表現を生成できる新しいエンコーダー-デコーダーアーキテクチャを導入しています。さらに、これらの表現を新しいインスタンスに適応させるためのパラメータ効率の高いファインチューニング方法を採用することで、ShapeNetやObjaverseなどの一般的な3Dデータセットで、150倍以上の圧縮率と20倍のエンコード時間の短縮を実現し、画像品質を維持または向上させています。

### 学習データ量の削減

* **FewShotNeRF (FewShotNeRF: Meta-Learning-based Novel View Synthesis for Rapid Scene-Specific Adaptation)** [http://arxiv.org/abs/2408.04803v1](http://arxiv.org/abs/2408.04803v1) は、限られたマルチビュー画像を使用して現実世界のオブジェクトのノベルビューを生成するという問題に取り組んでいます。これは、3Dシーン再構築における大きな課題です。著者らは、メタ学習を用いてNeRFの最適な初期化を実現し、特定のシーンへの迅速な適応を可能にする新しい手法を提案しています。オブジェクトカテゴリ全体で共有されるジオメトリとテクスチャをキャプチャすることに重点を置くことで、この手法はNeRFの学習効率を高め、高度な位置エンコーディングを使用してフィッティングプロセスを高速化します。このアプローチは、Common Objects in 3Dデータセットでの広範な評価によって検証されており、高品質のノベルビューを生成する際の有効性が実証されています。

* **SinNeRF (SinNeRF: Training Neural Radiance Fields on Complex Scenes from a Single Image)** [http://arxiv.org/abs/2204.00928v2](http://arxiv.org/abs/2204.00928v2) は、従来のNeRF手法では、高密度なマルチビューデータが必要とされるため、単一の2D画像から現実的な3D表現を生成するという課題に取り組んでいます。著者らは、ジオメトリとセマンティック擬似ラベルを統合してトレーニングプロセスを強化する半教師あり学習アプローチを採用するSinNeRFと呼ばれる新しいフレームワークを提案しています。これにより、SinNeRFは、マルチビューデータセットで事前トレーニングを行うことなく、複雑なシーンのフォトリアルなノベルビューを合成することに成功しています。その結果、SinNeRFは既存のNeRF手法を大幅に凌駕し、3Dシーン再構築における幅広いアプリケーションの可能性を示しています。

### 編集機能の向上

* **BluNF (Blueprint Neural Field)** [http://arxiv.org/abs/2309.03933v1](http://arxiv.org/abs/2309.03933v1) は、シーン合成におけるNeRFの編集機能を強化するために設計された新しい手法です。この研究では、NeRFの編集に必要とされる面倒な手動アノテーションが、従来の2Dツールでは3D空間を正確に表現できないため、さらに複雑になっているという問題に対処しています。BluNFは、事前にセマンティック情報と深度情報を組み込んだユーザーフレンドリーな2Dブループリントを作成することで、この問題に対処しています。この手法により、ユーザーは、シンプルなクリックアンドチェンジインターフェースを通じて、マスク、外観の変更、オブジェクトの削除など、さまざまな編集を実行できます。この革新は、視覚コンテンツの作成を合理化し、この分野におけるさらなる進歩を促すことを目指しています。

* **IReNe (IReNe: Instant Recoloring of Neural Radiance Fields)** [http://arxiv.org/abs/2405.19876v2](http://arxiv.org/abs/2405.19876v2) は、NeRFのインスタントリカラーリングのための新しい手法であり、3Dシーン再構築における編集速度の遅さ、オブジェクト境界の不正確さ、マルチビューの一貫性という課題に対処しています。IReNeは、事前学習済みのNeRFモデルとユーザーが編集した単一の画像を使用することで、モデルのパラメータをほぼリアルタイムで更新できるため、迅速な色の調整を可能にします。この手法は、境界制御を強化するための学習可能なセグメンテーションモジュールを組み込み、拡散外観を担当するニューロンを自動的に分類することで、効率を大幅に向上させています。新しいデータセットでの検証により、IReNeは、既存の手法と比較して、大幅な速度向上(5倍から500倍)と視覚品質の向上を実現していることが示されています。

* **DATENeRF (DATENeRF: Depth-Aware Text-based Editing of NeRFs)** [http://arxiv.org/abs/2404.04526v2](http://arxiv.org/abs/2404.04526v2) は、テキストプロンプトを使用してNeRFを編集するという課題に取り組んでいます。これは、シーンの複数のビュー間で一貫性を維持する必要があるため、複雑な作業です。著者らは、NeRFシーンのジオメトリを基盤として2D編集を統合する新しい手法を提案しています。彼らは、変更の一貫性を確保するための深度条件付きControlNetと、深度情報を使用してさまざまな画像にわたって編集を効果的に分散させるインペインティング技術を導入しています。その結果、このアプローチは、既存の手法と比較して、より一貫性があり現実的な編集をもたらし、テキスト駆動型NeRFシーン編集の全体的な品質を向上させています。

* **ED-NeRF (ED-NeRF: Efficient Text-Guided Editing of 3D Scene with Latent Space NeRF)** [http://arxiv.org/abs/2310.02712v2](http://arxiv.org/abs/2310.02712v2) は、潜在空間NeRF(ニューラルラジアンフィールド)を使用して3Dシーンを効率的にテキストガイド編集するための新しい手法です。この研究では、既存のNeRF編集技術におけるトレーニング速度の遅さと不十分な損失関数により、テキストの説明に基づいて3Dオブジェクトを効果的に操作することができないという問題に対処しています。ED-NeRFは、独自の調整レイヤーを通じて、現実世界のシーンを潜在拡散モデルの潜在空間に埋め込むことで、これらの制限を克服し、より高速で効果的な編集機能を実現しています。さらに、著者らは、従来の手法と比較して編集性能を向上させる、デルタデノイジングスコア(DDS)蒸留損失と呼ばれる改善された損失関数を導入しています。実験結果から、ED-NeRFは、現在の最先端の3D編集モデルと比較して、優れた編集速度と出力品質を実現していることが示されています。

* **SKED (SKED: Sketch-guided Text-based 3D Editing)** [http://arxiv.org/abs/2303.10735v4](http://arxiv.org/abs/2303.10735v4) は、テキストツー3Dパイプラインにおけるローカルコンテンツ操作の課題に対処する、インタラクティブな3D編集のための新しいアプローチです。従来の手法は、テキストインターフェースに依存しており、ユーザーにとって面倒な場合があります。SKEDは、ユーザーが異なるビューからわずか2つのスケッチを提供して既存のNeRF(ニューラルラジアンフィールド)を変更できるようにすることで、ユーザーコントロールを強化しています。この手法は、元のモデルの密度とラジアンを維持しながら、スケッチと編集が一致するように、革新的な損失関数を採用しています。著者らは、さまざまな定性的および定量的実験を通じて、このアプローチを検証し、直感的な3D形状編集を促進する際の有効性を示しています。

* **NeRFFaceEditing (NeRFFaceEditing: Disentangled Face Editing in Neural Radiance Fields)** [http://arxiv.org/abs/2211.07968v1](http://arxiv.org/abs/2211.07968v1) は、ニューラルラジアンフィールドによって生成された3D認識顔画像において、顔のジオメトリと外観を独立して編集するという課題に対処しています。従来の手法は、多くの場合、再トレーニングが必要であり、生成技術の進歩に追いつくことができません。これらの制限を克服するために、著者らは、高品質と高速な推論を維持しながら、ジオメトリと外観を分離するために、トリプレーン表現を使用する新しいアプローチを提案しています。彼らの手法は、ジオメトリ編集のための3D連続セマンティックマスクを組み込み、ジオメトリと外観に別々のデコーダーを採用しています。これにより、セマンティックマスクを使用して顔の特徴を正確に制御できます。その結果、NeRFFaceEditingは、既存の手法と比較して、顔の特徴を操作する能力を大幅に向上させています。

### その他の進化

* **Animate124 (Animate124: Animating One Image to 4D Dynamic Scene)** [http://arxiv.org/abs/2311.14603v2](http://arxiv.org/abs/2311.14603v2) は、単一の静止画像を4Dの動的なシーンにアニメーション化する課題に取り組んでいます。これは、これまであまり研究されていませんでした。著者らは、3つの段階で最適化された動的なNeRFモデルを使用する新しい手法を提案しています。最初に、参照画像を使用して、2Dおよび3D拡散事前情報をガイドにした静的モデルが作成されます。次に、ビデオ拡散モデルが被写体の動きをキャプチャします。しかし、生成された3Dビデオは、テキストプロンプトと画像の間に矛盾があるため、オブジェクトが参照画像とずれるセマンティックドリフトが発生することがよくあります。この問題を軽減するために、最終段階では、パーソナライズされた拡散事前情報が組み込まれています。その結果、既存の手法と比較して大幅な改善が見られ、画像から4Dへの生成のためのこの先駆的なフレームワークの有効性が強調されています。

* **Sync-NeRF (Sync-NeRF: Generalizing Dynamic NeRFs to Unsynchronized Videos)** [http://arxiv.org/abs/2310.13356v4](http://arxiv.org/abs/2310.13356v4) は、ニューラルラジアンフィールド(NeRF)を使用して、非同期マルチビュービデオから動的なシーンを再構築するという課題に対処しています。従来のNeRF手法は、これらの設定ではうまく機能しません。なぜなら、これらの手法は各フレームに単一の潜在埋め込みを使用しており、画像は異なる時間にキャプチャされる可能性があるという事実を考慮していないからです。この制限を克服するために、著者らは各ビデオに時間オフセットを導入し、これらのオフセットをNeRFモデルと共同で最適化することを提案しています。このアプローチは、さまざまなベースライン手法の再構築品質を向上させるだけでなく、ビデオを自動的に同期させるため、手動調整の必要性を排除します。Sync-NeRFの有効性は、確立されたデータセットでの実験によって検証されており、性能の大幅な改善が示されています。

* **Entity-NeRF (Entity-NeRF: Detecting and Removing Moving Entities in Urban Scenes)** [http://arxiv.org/abs/2403.16141v1](http://arxiv.org/abs/2403.16141v1) は、都市シーンにおける移動するエンティティを検出および削除するという課題に対処するために設計された新しい手法です。これは、静的な背景を正確に再構築するために不可欠です。従来のNeRFは、さまざまな移動オブジェクトが存在するため、都市のダイナミクスの複雑さに苦労しています。Entity-NeRFは、知識ベースと統計的な戦略を組み合わせ、エンティティごとの統計とセグメンテーション技術を使用して、移動オブジェクトを効果的に分類および排除します。著者らは、このアプローチを評価するために、専門的な都市シーンデータセットを作成し、Entity-NeRFが、移動オブジェクトの削除と背景の再構築の定量的および定性的評価の両方で、既存の手法を大幅に凌駕していることを示しています。

* **HFNeRF (HFNeRF: Learning Human Biomechanic Features with Neural Radiance Fields)** [http://arxiv.org/abs/2404.06152v1](http://arxiv.org/abs/2404.06152v1) は、人間のバイオメカニカル機能、特に既存の手法では見過ごされがちである骨格や関節情報などの構造的側面を生成するために、NeRFを強化する新しいアプローチです。この研究では、現在のNeRF技術が人間の被験者に適用された場合、汎化性が欠如しており、拡張現実(AR)や仮想現実(VR)などのアプリケーションにおける有用性が阻害されているという問題に対処しています。HFNeRFは、事前学習済みの画像エンコーダーを使用して、ニューラルレンダリングを通じてこれらのバイオメカニカル機能を3Dで学習し、最終的に2D特徴マップを生成します。この手法は完全に微分可能であり、色、ジオメトリ、人間の骨格データの同時学習を可能にします。予備的な結果から、HFNeRFは、重要なバイオメカニカル属性を持つ現実的な仮想アバターを作成する可能性があることが示されています。

* **TD-NeRF (TD-NeRF: Novel Truncated Depth Prior for Joint Camera Pose and Neural Radiance Field Optimization)** [http://arxiv.org/abs/2405.07027v1](http://arxiv.org/abs/2405.07027v1) は、3D再構築とSLAMタスクにおけるNeRFのカメラポーズ推定の精度という課題に対処する新しい手法です。従来のアプローチは、単眼深度事前情報の制限に苦労しており、ノイズのためにその可能性を十分に活用できていません。TD-NeRFは、深度ベースのレイサンプリングに切断された正規分布を導入することで、この問題を改善し、収束とポーズ精度を向上させています。さらに、深度ジオメトリを洗練するための粗いものから細かいものへのトレーニング戦略を採用し、深度ノイズを軽減するための堅牢なフレーム間ポイント制約を導入しています。実験結果から、TD-NeRFは既存の手法を凌駕し、より優れたカメラポーズ最適化と深度精度を実現していることが示されています。

* **Fast Global Localization on Neural Radiance Field** [http://arxiv.org/abs/2406.12202v1](http://arxiv.org/abs/2406.12202v1) は、2D画像から高品質の3Dシーン再構築に使用されるNeRFにおけるグローバルローカリゼーションの課題に対処しています。既存の手法であるLoc-NeRFは、モンテカルロローカリゼーションとNeRFを組み合わせたものですが、レイレンダリングプロセスが遅いため、実用的な用途が制限されています。この問題を克服するために、著者らは、ローカリゼーションの効率と精度を向上させるための粗いものから細かいものへの戦略を採用するFast Loc-NeRFを提案しています。この手法は、さまざまな解像度でレンダリングされたピクセルを観察された画像に一致させることで、パーティクル更新プロセスを高速化し、正確なローカリゼーションを確保しています。さらに、パーティクルの不確実性を評価することで、ローカリゼーションの信頼性を向上させるためのパーティクルリジェクションウェイトメカニズムを導入しています。Fast Loc-NeRFは、複数のベンチマークで最先端の性能を実現し、グローバルローカリゼーションタスクにおける有効性を示しています。

* **Camera Relocalization in Shadow-free Neural Radiance Fields** [http://arxiv.org/abs/2405.14824v1](http://arxiv.org/abs/2405.14824v1) は、コンピュータビジョンにおけるカメラの再ローカリゼーションの課題、特に照明の変化や影がシーンの外観に影響を与える場合の課題に対処しています。ポーズ最適化のためにニューラルラジアンフィールド(NeRF)を使用する従来の手法は、これらの条件下ではうまく機能しません。この問題に対処するために、著者らは、異なる照明と影のシナリオの影響を受けた画像を正規化する2段階のパイプラインを提案し、再ローカリゼーションプロセスを強化しています。彼らは、ポーズ最適化を改善するためにハッシュエンコードされたNeRFを実装し、画像勾配のノイズを軽減するために、新しい切断された動的ローパスフィルター(TDLF)と数値勾配平均化技術を導入しています。実験結果から、彼らのアプローチは、さまざまな照明条件下で既存の手法を凌駕し、コードとデータを公開する予定です。

* **Pano-NeRF (Pano-NeRF: Synthesizing High Dynamic Range Novel Views with Geometry from Sparse Low Dynamic Range Panoramic Images)** [http://arxiv.org/abs/2312.15942v2](http://arxiv.org/abs/2312.15942v2) は、拡張現実(XR)アプリケーションに特に関連するパノラマ画像処理における一般的な問題である、疎な低ダイナミックレンジ(LDR)のパノラマ画像から高ダイナミックレンジ(HDR)画像を合成し、ジオメトリを回復するという課題に対処しています。従来のNeRFは、LDR入力を用いると、ジオメトリが制約不足になり、HDRの再構築が不十分になります。この問題を克服するために、著者らは、各ピクセルからのラジアンをシーン照明の信号と他のピクセルに対する光源の両方として扱う照度場を用いる新しいアプローチを導入しています。この手法は、観測数を増やし、照度-ラジアンの関係を利用することで、ジオメトリの回復を強化し、HDRの再構築を改善しています。実験結果から、Pano-NeRFは両方のタスクで既存の手法を凌駕し、空間的に変化する照明推定を付加的な利点として提供していることが示されています。

* **fNeRF (fNeRF: High Quality Radiance Fields from Practical Cameras)** [http://arxiv.org/abs/2406.10633v1](http://arxiv.org/abs/2406.10633v1) は、マルチビューカメラデータからNeRFを使用して高品質の3D再構築を実現するという課題に対処しています。特に、単純化されたピンホールカメラモデルを使用することによって生じる、デフォーカスぼけの問題に焦点を当てています。著者らは、現実的なカメラレンズの光学特性を組み込むためにレイキャスティングを変更する新しい手法であるfNeRFを提案しています。これにより、デフォーカスぼけが存在する場合でも、シーンの再構築品質が向上し、合成データセットと現実世界のデータセットの両方で、ピーク信号対雑音比(PSNR)が最大3dB向上しています。

* **DirectL (DirectL: Efficient Radiance Fields Rendering for 3D Light Field Displays)** [http://arxiv.org/abs/2407.14053v1](http://arxiv.org/abs/2407.14053v1) は、コンテンツ作成の複雑さのために普及が困難であった、オートステレオスコピックディスプレイ用の3Dコンテンツを作成するという課題に対処することを目的とした新しいレンダリングアプローチです。従来の手法では、高解像度で複数のビューをレンダリングする必要があり、リアルタイムでのパフォーマンスが困難でした。DirectLは、空間レイをスクリーンサブピクセルにマッピングする方法を分析し、ニューラルラジアンフィールド(NeRF)と3Dガウシアンブラッティング(3DGS)の2つの主要なタイプのラジアンフィールドに対してレンダリングプロセスを最適化することで、この問題を簡素化しています。この手法により、ライトフィールド画像を直接レンダリングすることができ、視覚品質を損なうことなく、最大40倍の高速なレンダリングを実現しています。この論文では、実験とユーザー調査を通じてDirectLの有効性を示し、ライトフィールドディスプレイの使いやすさと商業化を促進する可能性を強調しています。

* **F-3DGS (F-3DGS: Factorized Coordinates and Representations for 3D Gaussian Splatting)** [http://arxiv.org/abs/2405.17083v2](http://arxiv.org/abs/2405.17083v2) は、3Dガウシアンブラッティング(3DGS)に対する新しいアプローチであり、多数のガウシアンを使用して3Dシーンを表現することに関連する高いストレージ要件に対処することを目的としています。ニューラルラジアンフィールド(NeRF)などの既存の手法は、画像品質に優れていますが、計算コストが高いため、F-3DGSは、因子分解技術を活用して、より少ない要素でガウシアンの密集したクラスタを効率的に表現しています。これらのガウシアンの本質的な属性(色、スケール、回転など)を近似することで、F-3DGSは、画像品質を維持しながら、ストレージコストを大幅に削減しています。実験結果から、その有効性が確認されており、リソースの限られた環境やリアルタイムアプリケーションに適しています。

* **Compressing Explicit Voxel Grid Representations: fast NeRFs become also small** [http://arxiv.org/abs/2210.12782v1](http://arxiv.org/abs/2210.12782v1) は、レンダリング速度が遅いことで知られるNeRFで使用される明示的なボクセルグリッド(EVG)表現における高いメモリ使用量の課題に対処しています。著者らは、EVG-NeRFを圧縮し、パフォーマンスを維持しながらメモリフットプリントを削減するように設計された新しい手法であるRe:NeRFを導入しています。4つのよく知られたベンチマークにわたる3つの異なるEVG-NeRFアーキテクチャに対してRe:NeRFをベンチマークすることで、この研究は、出力品質を損なうことなく、NeRFモデルの効率を向上させる際の有効性と汎用性を示しています。

### まとめ

NeRFは、3Dシーン表現技術として、近年目覚ましい進歩を遂げています。計算コストの低減、学習データ量の削減、編集機能の向上など、様々な課題に対して、多くの研究が行われています。これらの研究により、NeRFは、ゲーム、VR/AR、映画など、様々な分野で活用されることが期待されています。

Gemini 1.5 Pro

## NeRFの進化の研究について

NeRF(Neural Radiance Fields)は、近年コンピュータビジョンやグラフィックスの分野で注目されている技術であり、特に新規視点合成において目覚ましい成果を上げています。しかし、NeRFは高品質なレンダリングを実現する一方で、計算コストやメモリ使用量の面で課題を抱えています。本稿では、提供された論文に基づいて、NeRFの進化に関する研究を以下のカテゴリーに分類し、それぞれについて詳しく解説します。

### 1. 高速化と軽量化

NeRFのレンダリングを高速化し、モデルサイズを軽量化する研究は、NeRFの実用化に向けて重要な課題です。

* **Potamoi: Accelerating Neural Rendering via a Unified Streaming Architecture** [Potamoi] は、リソース制約のあるデバイスでのリアルタイムレンダリングを目指し、統合ストリームアーキテクチャを提案しています。論文では、既存のNeRFアルゴリズムのボトルネックを分析し、フレームあたりの計算負荷を削減するSpaRWアルゴリズムと、メモリアクセスを最適化するストリーミングパイプライン、そしてカスタマイズされたハードウェアを組み合わせることで、大幅な高速化と省電力化を実現しています。

* **CodecNeRF: Toward Fast Encoding and Decoding, Compact, and High-quality Novel-view Synthesis** [CodecNeRF] は、エンコーダ・デコーダ構造を採用することで、NeRF表現の高速な生成と圧縮を実現しています。さらに、ファインチューニング手法を用いることで、新しいインスタンスへの効率的な適応を可能にし、従来手法と比較して大幅な圧縮率とエンコード時間の短縮を実現しています。

* **VQ-NeRF: Vector Quantization Enhances Implicit Neural Representations** [VQ-NeRF] は、ベクトル量子化を用いることで、NeRFのサンプリング空間を低解像度化し、その後、事前学習済みVAEデコーダを用いて元のサイズに復元することで、レンダリング時間のボトルネックを解消しています。また、高圧縮時における詳細なテクスチャの保持のために、マルチスケールNeRFサンプリングスキームとセマンティック損失関数を導入し、幾何学的忠実度とセマンティックな一貫性を向上させています。

* **Compressing Explicit Voxel Grid Representations: fast NeRFs become also small** [Compressing Explicit Voxel Grid Representations] は、高速なレンダリング速度を特徴とする明示的ボクセルグリッド(EVG)表現の高いメモリ使用量に着目し、Re:NeRFと呼ばれる新しい圧縮手法を提案しています。Re:NeRFは、EVG-NeRFのメモリ使用量を削減しながらも、パフォーマンスを維持することを目指しており、様々なEVG-NeRFアーキテクチャとベンチマークデータセットを用いた評価により、その有効性と汎用性が示されています。

* **F-3DGS: Factorized Coordinates and Representations for 3D Gaussian Splatting** [F-3DGS] は、NeRFの代替手法として知られる3Dガウススプラッティング(3DGS)の高いストレージ要件に対処するために、ガウス分布の表現に因子分解技術を用いることで、ストレージコストを削減しています。F-3DGSは、色、スケール、回転などの重要な属性を保持しながら、データ量を大幅に削減し、高品質なレンダリングを実現しています。

* **MIMO-NeRF: Fast Neural Rendering with Multi-input Multi-output Neural Radiance Fields** [MIMO-NeRF] は、従来のSISO MLP(Single-Input Single-Output Multilayer Perceptron)に代わり、MIMO MLP(Multi-Input Multi-Output MLP)を用いることで、グループ単位のマッピングを行い、必要なMLPの数を大幅に削減しています。さらに、入力座標に基づく色と密度の出力の曖昧さを軽減するために、事前学習済みモデルを必要としない自己教師あり学習手法を導入し、MIMO MLPを正則化しています。

* **DirectL: Efficient Radiance Fields Rendering for 3D Light Field Displays** [DirectL] は、光線空間からスクリーンサブピクセルへのマッピングを分析し、NeRFや3DGSのレンダリングを最適化することで、オートステレオスコピックディスプレイ、特にライトフィールドディスプレイ(LFD)用の3Dコンテンツ作成における課題に対処しています。DirectLは、サブピクセルの再利用により、レンダリングに必要なピクセル数を削減し、視覚的品質を損なうことなく最大40倍のレンダリング速度を実現しています。

### 2. 精度向上と表現力向上

NeRFのレンダリング精度を向上させ、より複雑なシーンを表現するための研究も盛んに行われています。

* **FewShotNeRF: Meta-Learning-based Novel View Synthesis for Rapid Scene-Specific Adaptation** [FewShotNeRF] は、メタ学習を用いてNeRFの初期化を最適化することで、限られた枚数の多視点画像からでも、高品質な新規視点画像を生成することを可能にしています。オブジェクトカテゴリ全体で共通の形状やテクスチャを捉えることに焦点を当てることで、学習プロセスを大幅に高速化し、新しいシーンにNeRFを適合させるために必要な時間を短縮しています。

* **SinNeRF: Training Neural Radiance Fields on Complex Scenes from a Single Image** [SinNeRF] は、従来のNeRFでは困難であった単一画像からの複雑なシーンの3D表現生成を実現するために、幾何学的および意味的な疑似ラベルを統合した半教師あり学習アプローチを提案しています。SinNeRFは、事前学習済みの多視点データを用いることなく、写真のようにリアルな新規視点画像を生成する性能において、既存の最先端手法を凌駕しています。

* **OV-NeRF: Open-vocabulary Neural Radiance Fields with Vision and Language Foundation Models for 3D Semantic Understanding** [OV-NeRF] は、CLIP(Contrastive Language-Image Pretraining)のノイズの多いデータから、より正確なセマンティクスを抽出するために、2つの戦略を導入しています。1つ目は、2Dマスク提案を用いて単一視点からのノイズの多いセマンティクスを洗練するRSR(Region Semantic Ranking)正則化であり、2つ目は、CLIPからの不整合な2Dセマンティクスだけに頼るのではなく、3Dで一貫性のあるセマンティクスを利用するCSE(Cross-view Self-enhancement)です。

* **HFNeRF: Learning Human Biomechanic Features with Neural Radiance Fields** [HFNeRF] は、従来のNeRFでは見落とされがちであった人間の骨格構造に着目し、事前学習済み画像エンコーダを用いることで、ニューラルレンダリングとボリュームレンダリングを通じてこれらの特徴を3Dで学習し、2D特徴マップの生成を可能にしています。HFNeRFは、色、形状、骨格データを同時に学習できるため、重要な生体力学的特徴を持つリアルなバーチャルアバターの作成に役立ちます。

* **fNeRF: High Quality Radiance Fields from Practical Cameras** [fNeRF] は、従来のNeRFで用いられてきたピンホールカメラモデルの代わりに、実際のカメラレンズの光学特性を組み込んだレイトレーシングを行うことで、焦点ボケの影響を受けたシーンの再構成精度を向上させています。fNeRFは、特に部分的なオクルージョンがあるシーンにおいて、実際のカメラの動作に近い結果を得ることができ、合成データセットと実データセットの両方において、すべてが焦点の合った画像のPSNRを大幅に向上させています。

* **Pano-NeRF: Synthesizing High Dynamic Range Novel Views with Geometry from Sparse Low Dynamic Range Panoramic Images** [Pano-NeRF] は、スパースな低ダイナミックレンジ(LDR)パノラマ画像から高ダイナミックレンジ(HDR)画像を合成する手法を提案しています。従来のNeRFは、限られたLDR入力を使用する場合、幾何学的制約が不足するため、HDR再構成が不十分になるという問題がありました。Pano-NeRFは、各ピクセルの放射輝度をシーン照明の信号と他のピクセルの光源の両方としてモデル化することで、幾何学的復元を強化し、放射輝度と放射照度の関係を利用することでHDR再構成を改善しています。

* **Rip-NeRF: Anti-aliasing Radiance Fields with Ripmap-Encoded Platonic Solids** [Rip-NeRF] は、異方性領域の正確な表現が難しいことから生じる、NeRFにおけるエイリアシングやぼかしのアーティファクト問題に対処するために、Ripmapでエンコードされたプラトン立体表現を用いた新しい手法を提案しています。この手法は、異方性領域をより適切に特徴付けるために3D空間をプラトン立体の面にマッピングするプラトン立体射影と、これらの領域のサンプリングを強化するために学習可能な特徴グリッドを事前にフィルタリングするRipmapエンコーディングの2つの主要コンポーネントで構成されています。

* **Volumetric Rendering with Baked Quadrature Fields** [Volumetric Rendering with Baked Quadrature Fields] は、非不透明なシーンをレンダリングする際に、従来のNeRFが計算量の多いボリュームレンダリングに依存しているため、推論時間が遅いという課題に対処しています。この論文では、テクスチャ付きポリゴンを用いることでレンダリング速度を向上させながら、高品質な視覚的出力を維持する新しい手法を提案しています。ボリューム効果のモデリングに必要な求積点を特定するための特殊なフィールドを導入し、マーチングキューブを用いてポリゴンメッシュを作成しています。レイトレーシング技術を統合することで、この手法は1920x1080の解像度で毎秒100フレームを超えるレンダリング速度を実現し、最新のグラフィックスハードウェアを効果的に活用しながら、非不透明なオブジェクトを正確に表現しています。

### 3. 新規応用分野への拡張

NeRFは、新規視点合成だけでなく、様々な応用分野への拡張が進められています。

* **Camera Relocalization in Shadow-free Neural Radiance Fields** [Camera Relocalization in Shadow-free Neural Radiance Fields] は、照明や影の変化の影響を受けにくいカメラ再局在化の手法を提案しています。2段階のパイプラインを用いることで、照明変化の影響を受けた画像を正規化し、NeRFによるカメラ姿勢の refinement を改善しています。また、ハッシュエンコードされたNeRFを導入することで、姿勢の最適化を改善し、ノイズの多い画像勾配の問題に対処するために、切り捨てられた動的ローパスフィルタと数値勾配平均化技術を実装しています。

* **Fast Global Localization on Neural Radiance Field** [Fast Global Localization on Neural Radiance Field] は、NeRF内でのグローバルローカリゼーションの高速化を目指し、粗から精への戦略を用いて、複数の解像度でレンダリングされたピクセルと観測画像とのマッチングを行うことで、パーティクルの更新プロセスを高速化しながらも、正確なローカリゼーションを実現しています。さらに、不確実性を評価することで信頼性の低いパーティクルを除去するパーティクルリジェクション重み付けを導入し、効率と精度の両方を向上させています。

* **FlyNeRF: NeRF-Based Aerial Mapping for High-Quality 3D Scene Reconstruction** [FlyNeRF] は、ドローンによるデータ収集とNeRFを組み合わせることで、3Dシーン再構成と航空マッピングを強化するシステムを提案しています。無人航空機(UAV)によって画像と空間座標を取得し、これらのデータを用いて初期NeRFベースの再構成を行います。さらに、画像評価ニューラルネットワークを用いてレンダリング品質を評価し、追加の画像取得に最適な位置を自律的に特定することで、再構成の品質をさらに向上させています。

* **Entity-NeRF: Detecting and Removing Moving Entities in Urban Scenes** [Entity-NeRF] は、都市環境における静的な背景の正確な再構成を目指し、エンティティ単位の統計とセグメンテーションを利用して移動するエンティティを識別および分類することで、移動するオブジェクトを効果的に除去し、静的な背景を再構成する手法を提案しています。

* **Sync-NeRF: Generalizing Dynamic NeRFs to Unsynchronized Videos** [Sync-NeRF] は、非同期なマルチビュービデオからの動的シーンの再構成を可能にするために、各ビデオに時間オフセットを導入し、NeRFモデルと共同でこれらのオフセットを最適化する手法を提案しています。このアプローチにより、様々なベースラインモデルにおいて再構成品質が向上するだけでなく、手動による介入なしにビデオを効果的に同期させることができます。

* **Animate124: Animating One Image to 4D Dynamic Scene** [Animate124] は、静止画像1枚とテキストによる動きの記述を用いて、動的な3Dビデオを生成する手法を提案しています。4Dグリッド動的NeRFモデルを用い、最初に参照画像と拡散事前分布によって静的モデルを最適化し、次にビデオ拡散モデルで被写体の動きを捉えます。さらに、テキストプロンプトと画像のずれによって発生するセマンティックドリフトを軽減するために、パーソナライズされた拡散事前分布を組み込んでいます。

* **HiFA: High-fidelity Text-to-3D Generation with Advanced Diffusion Guidance** [HiFA] は、テキストプロンプトから高品質な3D表現を生成する手法を提案しています。事前学習済みテキスト-to-image拡散モデルとNeRFを組み合わせた手法において、ホリスティックサンプリングとスムージング技術を組み合わせることで、テキスト-to-3D生成の品質を向上させています。

* **SKED: Sketch-guided Text-based 3D Editing** [SKED] は、テキストベースの3D編集にユーザーがガイドするスケッチを統合することで、より直感的な編集操作を可能にする手法を提案しています。異なる視点からの2つのスケッチのみを用いてNeRFを変更し、変更がテキストプロンプトの意図したセマンティクスと一致するようにしています。

* **ED-NeRF: Efficient Text-Guided Editing of 3D Scene with Latent Space NeRF** [ED-NeRF] は、潜在拡散モデル(LDM)の潜在空間に現実世界のシーンを埋め込むことで、編集可能なNeRFバックボーンを実現し、テキストガイドによる3Dシーンの効率的な編集を可能にしています。また、従来の手法よりも3D編集に適した損失関数であるDDS(delta denoising score)蒸留損失を導入することで、編集プロセスを高速化し、出力の品質を向上させています。

* **DATENeRF: Depth-Aware Text-based Editing of NeRFs** [DATENeRF] は、NeRFシーンのジオメトリを基礎として2D編集を統合することで、テキストプロンプトを用いたNeRF編集における一貫性を向上させています。深度条件付きControlNetを用いることで、複数の画像にわたる変更のコヒーレンスを高め、深度情報を利用したインペインティング技術を導入することで、エラーやリサンプリングの問題に対するロバスト性を向上させています。

* **BluNF: Blueprint Neural Field** [BluNF] は、NeRFの編集機能を強化するために、事前セマンティック情報と深度情報を統合した2Dブループリントを用いることで、直感的なシーン操作を可能にしています。ユーザーは、マスク、外観の変更、オブジェクトの削除などの編集を、シンプルなクリックアンドチェンジインターフェースを通じて行うことができます。

* **IReNe: Instant Recoloring of Neural Radiance Fields** [IReNe] は、事前学習済みNeRFモデルとユーザーが編集した1枚の画像を用いることで、NeRFのほぼリアルタイムな色編集を可能にする手法を提案しています。オブジェクト境界制御を強化するために学習可能なセグメンテーションモジュールを組み込んでおり、ネットワークの最後の層、特に拡散反射を担当するニューロンのみをファインチューニングすることで、高速な処理速度を実現しています。

* **NeRFFaceEditing: Disentangled Face Editing in Neural Radiance Fields** [NeRFFaceEditing] は、トライプレーン表現を用いることで、形状と外観を分離しながらも、高品質と高速な推論を維持することで、NeRFで生成された3D認識顔画像における顔の形状と外観を独立して編集することを可能にしています。形状デコーダは、顔のボリュームを生成された3Dセマンティックマスクに合わせ、外観デコーダは独立した編集を可能にします。

* **GeometrySticker: Enabling Ownership Claim of Recolorized Neural Radiance Fields** [GeometrySticker] は、NeRFのジオメトリコンポーネントにバイナリメッセージを直接埋め込むことで、色を変更しても所有権の主張が維持されるようにしています。このアプローチは、様々なNeRFアーキテクチャに適応可能であり、歪みに対してもロバストであるため、オリジナルクリエイターの著作権保護を強化します。

### 4. 評価のためのベンチマークデータセット

NeRFの性能を客観的に評価するために、高品質なベンチマークデータセットが重要です。

* **NERFBK: A High-Quality Benchmark for NERF-Based 3D Reconstruction** [NERFBK] は、NeRFベースの3D再構成アルゴリズムの評価を強化するために、高解像度画像、ビデオ、詳細なカメラパラメータを含む、屋内と屋外の両方の環境に対応した、現実的かつ合成的なマルチスケールデータセットを提供しています。

* **ScanNeRF: a Scalable Benchmark for Neural Radiance Fields** [ScanNeRF] は、NeRFとニューラルレンダリングフレームワークを評価するための包括的なベンチマークデータセットを提供しています。低コストで効率的に実オブジェクトをスキャンできるスキャンステーションを開発し、様々な条件下でのNeRF手法の性能を評価するための、学習/検証/テストの分割を含むScanNeRFデータセットを作成しています。

### 5. 開発フレームワーク

NeRFの研究開発を加速させるために、モジュール化された開発フレームワークが開発されています。

* **Nerfstudio: A Modular Framework for Neural Radiance Field Development** [Nerfstudio] は、NeRFの開発と展開を容易にするモジュール型フレームワークを提供しています。プラグアンドプレイアーキテクチャにより、研究者はNeRFメソッドを簡単に統合し、リアルタイムの可視化ツールを利用し、データのインポート/エクスポートを効率的に管理することができます。

### 6. サーベイ論文

NeRFとその応用に関する研究の現状をまとめたサーベイ論文も発表されています。

* **Neural Radiance Fields (NeRFs): A Review and Some Recent Developments** [Neural Radiance Fields (NeRFs): A Review and Some Recent Developments] は、NeRFの包括的なレビューを提供し、新規視点合成の課題、NeRFフレームワークの最近の進歩、効率と汎用性を向上させるための技術について解説しています。

* **Methods and strategies for improving the novel view synthesis quality of neural radiation field** [Methods and strategies for improving the novel view synthesis quality of neural radiation field] は、NeRF技術によって合成された画像のレンダリング品質を向上させることを目的とした、最近の方法のレビューと分類を行い、基礎となる技術原則を分析し、将来の方向性について議論しています。

* **Neural Radiance Field-based Visual Rendering: A Comprehensive Review** [Neural Radiance Field-based Visual Rendering: A Comprehensive Review] は、NeRFの包括的なレビューを提供し、NeRFのコアアーキテクチャ、最近の改善、様々な分野における実用的なアプリケーション、トレーニングに必要なデータセットと評価指標、将来の開発動向と課題について解説しています。

* **Neural Radiance Field in Autonomous Driving: A Survey** [Neural Radiance Field in Autonomous Driving: A Survey] は、自動運転(AD)におけるNeRF技術の応用に関する包括的なサーベイを提供し、NeRFの応用を認識、3D再構成、SLAM、シミュレーションの4つの主要分野に分類し、詳細な分析と将来の研究方向性について議論しています。

* **How NeRFs and 3D Gaussian Splatting are Reshaping SLAM: a Survey** [How NeRFs and 3D Gaussian Splatting are Reshaping SLAM: a Survey] は、過去20年間のSLAMの進化を概説し、NeRFと3DGSの最近の進歩がSLAMにどのような影響を与えているかに焦点を当てています。SLAM手法の歴史的背景、重要な開発、強み、限界について議論し、この分野のダイナミックな進歩と残された課題を理解するための基礎的な参考文献を提供しています。

### 7. SLAMへの応用

NeRFは、SLAM(Simultaneous Localization and Mapping)の分野でも注目されています。

* **NeSLAM: Neural Implicit Mapping and Self-Supervised Feature Tracking With Depth Completion and Denoising** [NeSLAM] は、深度補完とノイズ除去ネットワークを実装することで、深度推定とカメラトラッキングを改善し、従来の占有グリッドを符号付き距離場(SDF)表現に置き換えることで、再構成品質を向上させています。また、自己教師ありNeRFベースのトラッキングアルゴリズムを備えており、様々なデータセットを用いた実験を通じて、現実世界の屋内環境における再構成の精度とロバスト性の大幅な向上を実証しています。

* **TD-NeRF: Novel Truncated Depth Prior for Joint Camera Pose and Neural Radiance Field Optimization** [TD-NeRF] は、深度ベースのレイトレーシングに切り捨てられた正規分布を導入することで、収束速度と姿勢精度を向上させています。また、深度ジオメトリを絞り込むための粗から精へのトレーニング戦略を採用し、深度ノイズを軽減するために堅牢なフレーム間点制約を導入しています。

### まとめ

本稿では、提供された論文に基づいて、NeRFの進化に関する研究を7つのカテゴリーに分類し解説しました。NeRFは、高品質な新規視点合成を実現するだけでなく、高速化、軽量化、精度向上、表現力向上、新規応用分野への拡張など、様々な方向性で研究開発が進められています。

→言語化するのが難しいが、人間が読んで読みやすいのがPro。Flashはアブストラクトを直訳したような感じかな。

RAGの評価指標について網羅的に教えて

※q9_4_t0

Gemini 1.5 Flash

## RAGの評価指標

RAG(Retrieval-Augmented Generation)システムの評価指標は、その複雑な構造と多様なタスクへの適用可能性を反映して、近年急速に発展しています。論文では、様々な評価指標が提案されており、それぞれがRAGシステムの異なる側面を評価することを目的としています。

### 従来の評価指標の限界

従来の評価指標、例えばBLEUやROUGEは、RAGシステムの評価に適していないことが指摘されています。これは、RAGシステムが外部知識を統合するため、単に生成されたテキストの表面的な類似度を見るだけでは、システムの真の性能を評価できないからです。

### RAGシステムの評価指標

RAGシステムの評価指標は、大きく分けて以下の3つのカテゴリに分類できます。

1. **Retrieval Quality:**

- **Precision:** 検索結果における関連するドキュメントの割合。

- **Recall:** 関連するドキュメントのうち、検索結果に含まれた割合。

- **MRR (Mean Reciprocal Rank):** 検索結果における最も関連性の高いドキュメントのランキングの逆数の平均。

- **eRAG:** RAGシステムの出力と正解ラベルを比較することで、検索結果の関連性を評価する手法。

- **Jaccard Similarity:** 検索結果の集合と正解ラベルの集合の共通部分の割合。

- **Rank Similarity:** 検索結果のランキングと正解ラベルのランキングの類似度。

2. **Generation Quality:**

- **Factuality:** 生成されたテキストの事実の正確性。

- **Relevance:** 生成されたテキストが質問やタスクに関連しているかどうか。

- **Coherence:** 生成されたテキストの文法的な正しさ、論理的な整合性。

- **Fluency:** 生成されたテキストの自然さ、読みやすさ。

3. **RAGシステム全体の性能:**

- **RAGAS:** RAGシステムの性能を自動的に評価するフレームワーク。

- **InspectorRAGet:** RAGシステムの性能を詳細に分析するためのプラットフォーム。

- **RAGBench:** RAGシステムの性能を評価するためのベンチマークデータセット。

- **RAGEval:** 特定のドメインに特化したRAGシステムの評価データセットを生成するフレームワーク。

### 論文間の違い

論文によって、RAGシステムの評価指標に対するアプローチは異なります。例えば、`RAGChecker` ([http://arxiv.org/abs/2408.08067v1](http://arxiv.org/abs/2408.08067v1)) は、RAGシステムのRetrievalとGenerationの両方のコンポーネントを評価するための、より詳細な評価指標を提案しています。一方、`Auepora` ([http://arxiv.org/abs/2405.07437v2](http://arxiv.org/abs/2405.07437v2)) は、RAGシステムの評価のための統一的なフレームワークを提案し、様々なベンチマークにおけるRelevance、Accuracy、Faithfulnessなどの指標を分析しています。

### まとめ

RAGシステムの評価指標は、その複雑な構造と多様なタスクへの適用可能性を反映して、近年急速に発展しています。論文では、様々な評価指標が提案されており、それぞれがRAGシステムの異なる側面を評価することを目的としています。これらの指標を適切に組み合わせることで、RAGシステムの性能をより正確に評価することができます。

Gemini 1.5 Pro

## RAGの評価指標について

Retrieval-Augmented Generation (RAG)は、外部知識ベースから取得した情報を組み込むことで、Large Language Models (LLM) の機能を拡張します。RAGシステムの評価は、その複雑さから、従来の評価手法では不十分であり、活発な研究分野となっています。

### 評価指標の概要

RAGシステムの評価指標は、大きく分けて、検索の関連性、生成された文章の質、システム全体の性能の3つの側面から評価されます。

1. **検索の関連性**:

* 検索された文書が、実際に質問に関連しているかどうかを評価します。

* 従来の情報検索分野で用いられる指標(Precision, Recall, F1 scoreなど)に加えて、LLMの特性を考慮した指標も提案されています。

* 例えば、[Evaluating the Retrieval Component in LLM-Based Question Answering Systems](http://arxiv.org/abs/2406.06458v1) では、LLMが不適切な情報も無視できることを考慮した、RAGチャットボットのための新しいベースライン評価フレームワークを提案しています。

2. **生成された文章の質**:

* 生成された文章が、文法的に正しいか、質問への回答として適切か、事実と異なる情報を含んでいないかなどを評価します。

* BLEU、ROUGEなどの従来の自然言語処理指標に加えて、RAGシステム特有の評価指標も提案されています。

* 例えば、[RAGEval: Scenario Specific RAG Evaluation Dataset Generation Framework](http://arxiv.org/abs/2408.01262v1) では、LLMの回答における知識源を明確化するために、完全性、ハルシネーション、無関係性という3つの新しい指標を導入しています。

3. **システム全体の性能**:

* 処理速度やメモリ使用量など、システム全体の性能を評価します。

* 特に、RAGシステムは、外部知識ベースへのアクセスが必要となるため、処理速度が課題となります。

* [Accelerating Inference of Retrieval-Augmented Generation via Sparse Context Selection](http://arxiv.org/abs/2405.16178v1) では、取得した文書のエンコードを並列化し、関連性の高い文書のみに絞ってデコードすることで、計算効率を向上させるSparse RAGを提案しています。

### 評価指標の詳細

以下に、上記の3つの側面から見たRAGの評価指標について、さらに詳しく説明します。

#### 検索の関連性

* **従来の情報検索指標**:

* Precision@K: 上位K件の検索結果に含まれる関連文書の割合

* Recall@K: 全関連文書のうち、上位K件の検索結果に含まれる文書の割合

* F1 score: PrecisionとRecallの調和平均

* Mean Average Precision (MAP): 検索結果のランキングを考慮した指標

* Normalized Discounted Cumulative Gain (NDCG): 関連性の高い文書が上位にランクされているほど高くなる指標

* **LLM特有の評価指標**:

* [Evaluating the Retrieval Component in LLM-Based Question Answering Systems](http://arxiv.org/abs/2406.06458v1) で提案された、LLMが不適切な情報も無視できることを考慮したベースライン評価フレームワーク

#### 生成された文章の質

* **回答の正確性**:

* 正解率 (Accuracy): 生成された回答が正解と一致する割合

* Exact Match (EM): 生成された回答が正解と完全に一致する割合

* F1 score: 正解と生成された回答の単語の重複率を測定

* **文章の流暢さ**:

* Perplexity: 文章の予測可能性を測定する指標。低いほど流暢

* BLEU: 生成された文章と参照文との間の単語の重複率を測定

* ROUGE: 生成された文章と参照文との間の文の重複率を測定

* BERTScore: BERTを用いて、生成された文章と参照文との間の意味的な類似度を測定

* **事実の整合性**:

* [Benchmarking Large Language Models in Retrieval-Augmented Generation](http://arxiv.org/abs/2309.01431v2) で提案された、ノイズに対する頑健性、否定的な情報の拒否、情報の統合、反事実的な頑健性という4つの能力を評価するRetrieval-Augmented Generation Benchmark (RGB)

* [RAGEval: Scenario Specific RAG Evaluation Dataset Generation Framework](http://arxiv.org/abs/2408.01262v1) で提案された、完全性、ハルシネーション、無関係性という3つの指標

#### システム全体の性能

* **処理速度**:

* Latency: 質問を受け取ってから回答を生成するまでの時間

* Throughput: 単位時間あたりに処理できる質問の数

* **計算資源**:

* Memory usage: システムが使用するメモリ量

* FLOPs: モデルの計算量

### 評価指標の課題と今後の展望

RAGシステムの評価は、まだ発展途上の段階であり、いくつかの課題が残されています。

* **統一的な評価指標の欠如**:

* 多くの評価指標が提案されていますが、広く合意されたものがありません。

* [BERGEN: A Benchmarking Library for Retrieval-Augmented Generation](http://arxiv.org/abs/2407.01102v1) では、RAG実験を標準化し、再現性のある研究を促進するためのベンチマークライブラリを提案しています。

* **タスクやドメインへの依存性**:

* 評価指標は、タスクやドメインに依存して、その有効性が変化する可能性があります。

* [Evaluation of RAG Metrics for Question Answering in the Telecom Domain](http://arxiv.org/abs/2407.12873v1) では、RAGASフレームワークを批判し、通信分野のQAタスクに合わせた評価の必要性を強調しています。

* **人間の評価との相関**:

* 自動評価指標と人間の評価との相関は、必ずしも高くありません。

* [A Comparison of LLM Finetuning Methods & Evaluation Metrics with Travel Chatbot Use Case](http://arxiv.org/abs/2408.03562v1) では、人間の評価と定量的な指標がしばしば異なることを示し、モデル評価における人間の評価の重要性を強調しています。

これらの課題を解決するために、今後も、より洗練された評価指標や評価データセットが開発されていくことが期待されます。

→人間的に読んで完璧なのがGemini 1.5 Pro。網羅性はFlashのほうがいいかもしれない?

参考例:GPT-4o-2024-08-06

Retrieval-Augmented Generation (RAG)システムの評価指標について、以下に網羅的に説明します。RAGシステムは、情報検索と生成を組み合わせたものであり、その評価は複数の側面から行われます。以下に、最近の研究から得られた評価指標とその特徴をまとめます。

### 1. 評価フレームワークとベンチマーク

- **RAGChecker**: RAGCheckerは、RAGシステムの評価における課題を解決するための新しい評価フレームワークです。特に、長文の応答や信頼性のある測定を保証するための診断指標を提供します。人間の判断と強く一致することが示されています [RAGChecker](http://arxiv.org/abs/2408.08067v1)。

- **ARES**: ARESは、RAGシステムの評価を自動化するフレームワークで、コンテキストの関連性、回答の忠実性、回答の関連性に基づいて評価を行います。少数の人間注釈データを使用して予測精度を向上させることが特徴です [ARES](http://arxiv.org/abs/2311.09476v2)。

- **RAGBench**: RAGBenchは、5つの業界特化型ドメインにわたる10万の例を含む包括的なベンチマークデータセットで、RAGシステムの評価を統一的に行うことを目的としています [RAGBench](http://arxiv.org/abs/2407.11005v1)。

### 2. 評価指標

- **信頼性と忠実性**: 多くの研究がRAGシステムの信頼性(生成された情報が正確であるか)と忠実性(生成された情報が元の情報に忠実であるか)を評価することに焦点を当てています。例えば、RAGCheckerやARESはこれらの指標を重視しています。

- **コンテキストの関連性**: RAGシステムが適切な情報を検索し、それを生成に活用できているかを評価するための指標です。ARESはこの評価を自動化しています。

- **ノイズ耐性と情報統合**: RAGシステムがノイズにどれだけ耐えられるか、また複数の情報源からの情報をどれだけ効果的に統合できるかを評価します [Benchmarking Large Language Models](http://arxiv.org/abs/2309.01431v2)。

### 3. 特定の課題に対する評価

- **多言語対応**: 多言語環境でのRAGの評価は、言語間の違いや名前のスペルバリエーションを考慮する必要があります [Retrieval-augmented generation in multilingual settings](http://arxiv.org/abs/2407.01463v1)。

- **ドメイン特化型評価**: 特定のドメイン(例:医療、テレコム)におけるRAGの評価は、そのドメインに特化した知識の正確性と関連性を重視します [Evaluation of RAG Metrics for Question Answering in the Telecom Domain](http://arxiv.org/abs/2407.12873v1)。

### 4. 評価の課題と改善提案

- **評価の透明性と説明可能性**: RAGシステムの評価において、評価指標の透明性と説明可能性が重要です。RAGBenchは、説明可能で実行可能な指標を提供することを目指しています。

- **評価の自動化と効率化**: ARESやRAGAsは、評価プロセスの自動化を通じて、評価の効率化を図っています。

これらの研究は、RAGシステムの評価における多様なアプローチと指標を提供し、システムの性能をより正確に評価するための基盤を築いています。各研究は異なる側面に焦点を当てており、特定のニーズに応じた評価方法を選択することが重要です。

→ポイントはおさえているものの、引用が少なくGeminiと比べると明らかに見劣りする。多段階の体系化が弱い

Claude 3.5 Sonnet 20240620

RAG (Retrieval-Augmented Generation) システムの評価指標について、以下に網羅的にまとめます。

## 1. 従来の評価指標

RAGシステムの評価には、従来のNLP評価指標も使用されています。

- BLEU、ROUGE、BERTScore: これらの指標は生成されたテキストの品質を評価するために使用されます。[CodeRAG-Bench](http://arxiv.org/abs/2406.14497v1)や[AI-TA](http://arxiv.org/abs/2311.02775v3)などの研究で使用されています。

- 正確性 (Accuracy): 生成された回答の正確さを評価します。[FiD-Light](http://arxiv.org/abs/2209.14290v1)などの研究で使用されています。

- F1スコア: 精度と再現率のバランスを評価します。[QUB-Cirdan](http://arxiv.org/abs/2406.00041v2)の研究で使用されています。

## 2. RAG特有の評価指標

RAGシステムの特性を考慮した新しい評価指標が提案されています。

### 2.1 RAGAS フレームワーク

[RAGAS](http://arxiv.org/abs/2309.15217v1)は、RAGシステムの自動評価のための包括的なフレームワークを提供しています。主な指標は以下の通りです:

- Faithfulness (忠実性): 生成された回答が検索されたコンテキストに忠実であるかを評価します。

- Answer Relevance (回答の関連性): 生成された回答が質問に適切に答えているかを評価します。

- Context Relevance (コンテキストの関連性): 検索されたコンテキストが質問に関連しているかを評価します。

- Context Recall (コンテキストの再現率): 必要な情報がコンテキストに含まれているかを評価します。

### 2.2 TRACe 評価指標

[RAGBench](http://arxiv.org/abs/2407.11005v1)で提案されたTRACe評価指標は、以下の要素を評価します:

- Truthfulness (真実性): 生成された回答が事実に基づいているかを評価します。

- Relevance (関連性): 回答が質問に関連しているかを評価します。

- Accuracy (正確性): 回答が質問に正確に答えているかを評価します。

- Completeness (完全性): 回答が質問のすべての側面をカバーしているかを評価します。

### 2.3 その他の特殊な指標

- Hallucination Rate (幻覚率): モデルが事実に基づかない情報を生成する頻度を測定します。[NoMIRACL](http://arxiv.org/abs/2312.11361v2)の研究で使用されています。

- Error Rate (エラー率): モデルが明確に誤った情報を生成する頻度を測定します。[NoMIRACL](http://arxiv.org/abs/2312.11361v2)の研究で使用されています。

- Completeness, Hallucination, Irrelevance: [RAGEval](http://arxiv.org/abs/2408.01262v1)で提案された指標で、回答の完全性、幻覚の程度、無関係な情報の含有を評価します。

## 3. 人間による評価

多くの研究では、自動評価指標に加えて人間による評価も重要視しています。

- Helpfulness (有用性): 回答がユーザーにとって役立つかを評価します。[Evaluating the Impact of Advanced LLM Techniques](http://arxiv.org/abs/2408.04645v1)の研究で使用されています。

- Trustworthiness (信頼性): 回答が信頼できるものかを評価します。同じく上記の研究で使用されています。

- Human Assessment: 専門家による総合的な評価。[Evaluation of RAG Metrics](http://arxiv.org/abs/2407.12873v1)の研究では、テレコムドメインでの専門家評価の重要性が強調されています。

## 4. 効率性に関する指標

- Latency (遅延): 回答生成にかかる時間を測定します。[PipeRAG](http://arxiv.org/abs/2403.05676v1)の研究では、生成遅延の改善が報告されています。

- Compression Rate (圧縮率): 検索されたコンテキストの圧縮効率を評価します。[An Information Bottleneck Perspective](http://arxiv.org/abs/2406.01549v2)の研究では、2.5%の圧縮率が達成されています。

## 5. 検索品質の評価

- Mean Reciprocal Rank (MRR): 検索結果の順位付けの質を評価します。[Retrieval-Augmented Generation with Knowledge Graphs](http://arxiv.org/abs/2404.17723v2)の研究では、77.6%のMRR改善が報告されています。

- Retrieval Accuracy: 適切なドキュメントが検索されているかを評価します。

## 結論

RAGシステムの評価は複雑で多面的であり、単一の指標だけでは十分ではありません。[Generative Information Retrieval Evaluation](http://arxiv.org/abs/2404.08137v2)の研究が指摘するように、LLMを使用した評価には潜在的な循環性の問題があり、人間による評価の重要性が強調されています。また、[A Comparison of Methods for Evaluating Generative IR](http://arxiv.org/abs/2404.04044v2)の研究が示すように、評価基準の透明性を確保し、人間の判断との整合性を確認することが重要です。

これらの多様な評価指標を組み合わせることで、RAGシステムの性能を包括的に評価し、改善点を特定することが可能になります。ただし、特定のドメインや用途に応じて、最適な評価指標の組み合わせを選択することが重要です。

→意外と悪くない。Geminiが落としている場所を拾いにいっており、網羅性は少し落ちるものの、ポイントを抑えたような書き方。

結論

- Gemini 1.5くっそ強く、Claude 3.5 Sonnetも健闘

- GPTはこの手の長文変換タスクでは現状厳しい

- 運用的にはとりあえずFlashで出して、必要ならProかClaude 3.5を使うでもいいのではないか?

- Recallだけでは測れない別の要素もポイントとなりつつあり、人間的な読みやすさ、多段階の体系化、ポイントを抑えているという定量化がスーパー難しい領域に入ってきている

Shikoan's ML Blogの中の人が運営しているサークル「じゅ~しぃ~すくりぷと」の本のご案内

技術書コーナー

北海道の駅巡りコーナー