論文まとめ:BEN: Using Confidence-Guided Matting for Dichotomous Image Segmentation

- タイトル:BEN: Using Confidence-Guided Matting for Dichotomous Image Segmentation

- GitHub:https://github.com/PramaLLC/BEN/

- 論文URL:https://arxiv.org/abs/2501.06230

- HuggingFace:https://huggingface.co/PramaLLC/BEN2

- デモ:https://huggingface.co/spaces/PramaLLC/BEN2

- 著者:Maxwell Meyer, Jack Spruyt(Prama.llc)

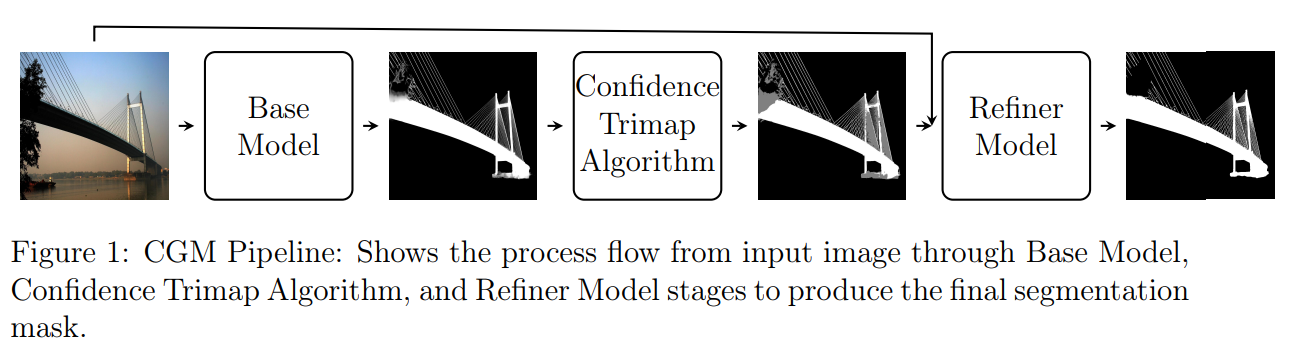

BENは、Confidenceベースでトリマップを自動生成し、不確実な領域にフォーカスすることで境界精度を高める。BaseモデルとRefinerモデルの連携により、従来手法を上回る二値画像セグメンテーション性能を達成している。

目次

論文要約 By Gemini

1. この論文において解決したい課題は何?

二値画像セグメンテーション(DIS)において、前景と背景の境界が曖昧な領域におけるセグメンテーション精度を向上させること。

2. 先行研究だとどういう点が課題だった?

Transformerベースの手法は計算コストが高く、データセットと異なるデータ分布を持つ画像において前景と背景の分類の信頼度が低下し、マッティング効果(境界のぼやけ)が生じる。また、既存のマッティング手法は手動で作成したトリマップに依存していた。

3. 先行研究と比較したとき、提案手法の独自性や貢献は何?

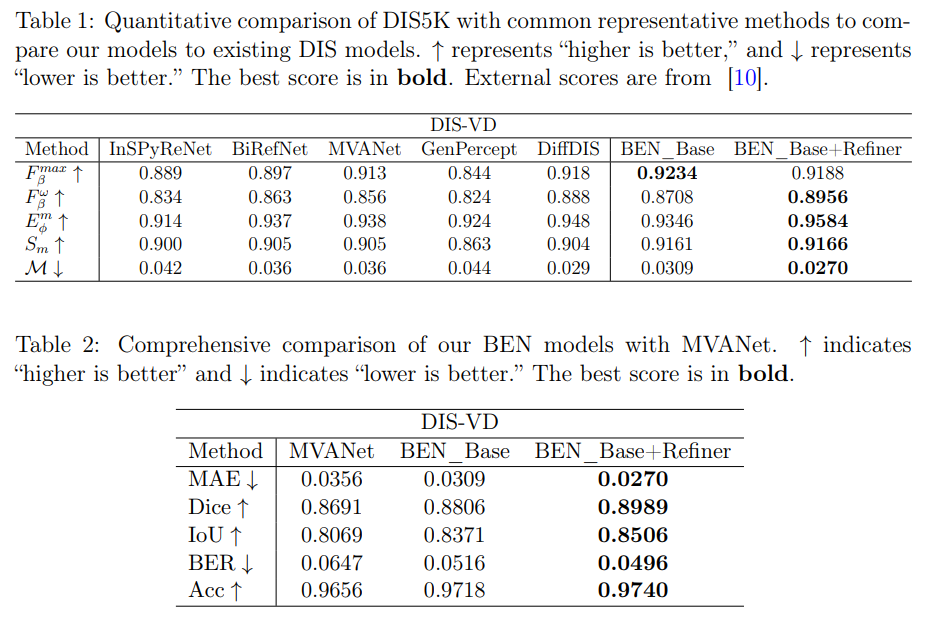

ベースモデルの予測信頼度に基づいてトリマップを動的に生成するConfidence-Guided Matting (CGM)を提案。これにより、リファイナーネットワークが不確実な領域に焦点を当ててセグメンテーション精度を向上させる。DIS5K検証データセットにおいてSOTAを達成。

4. 提案手法の手法を初心者でもわかるように詳細に説明して

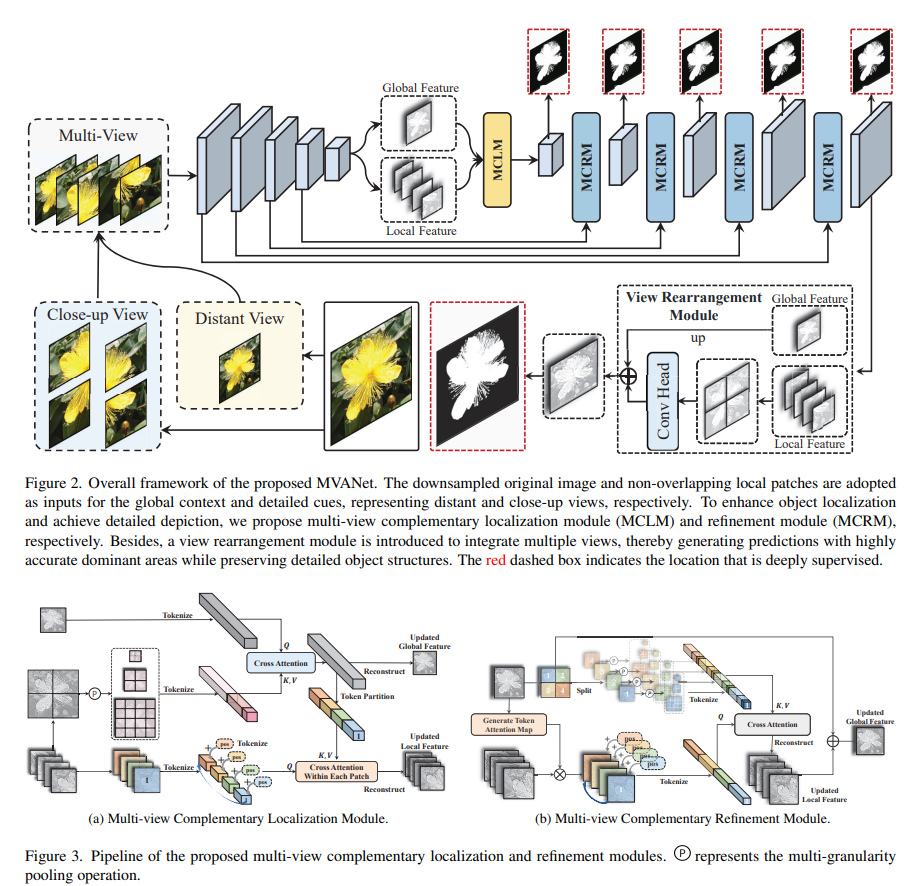

- BEN Base: MVANetをベースとしたモデルで初期セグメンテーションを行う。

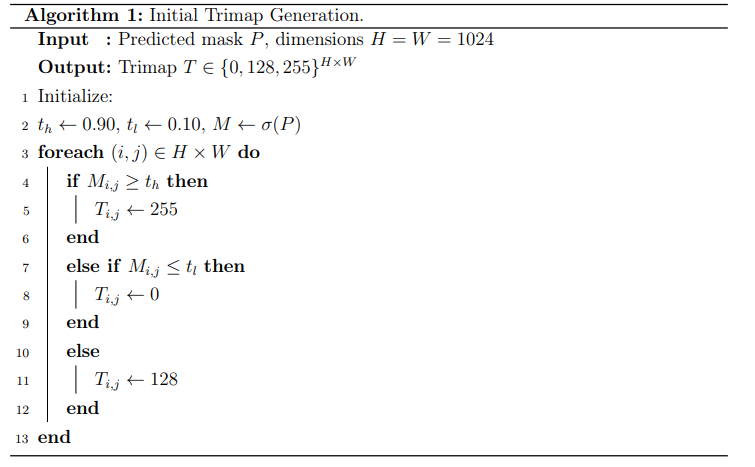

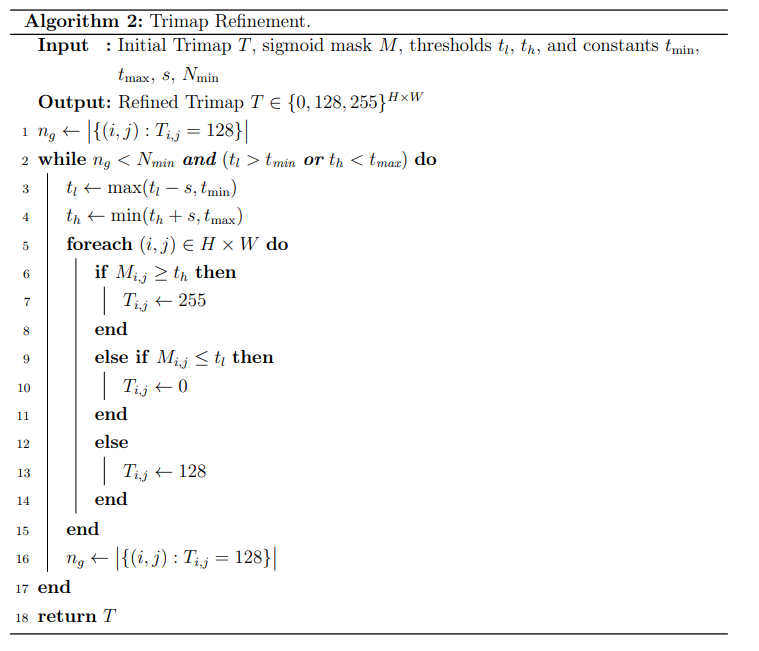

- Confidence Trimap Algorithm: BEN Baseの出力から信頼度マップを作成し、閾値処理によりトリマップを生成。信頼度の高い領域は前景/背景として確定させ、不確実な領域はグレーで表現する。 (アルゴリズム1と2、コードはこちら)

- BEN Refiner: 生成されたトリマップと入力画像を用いて、不確実な領域(グレーの領域)のセグメンテーションをRefinementする。

5. 提案手法の有効性をどのように定量・定性評価した?

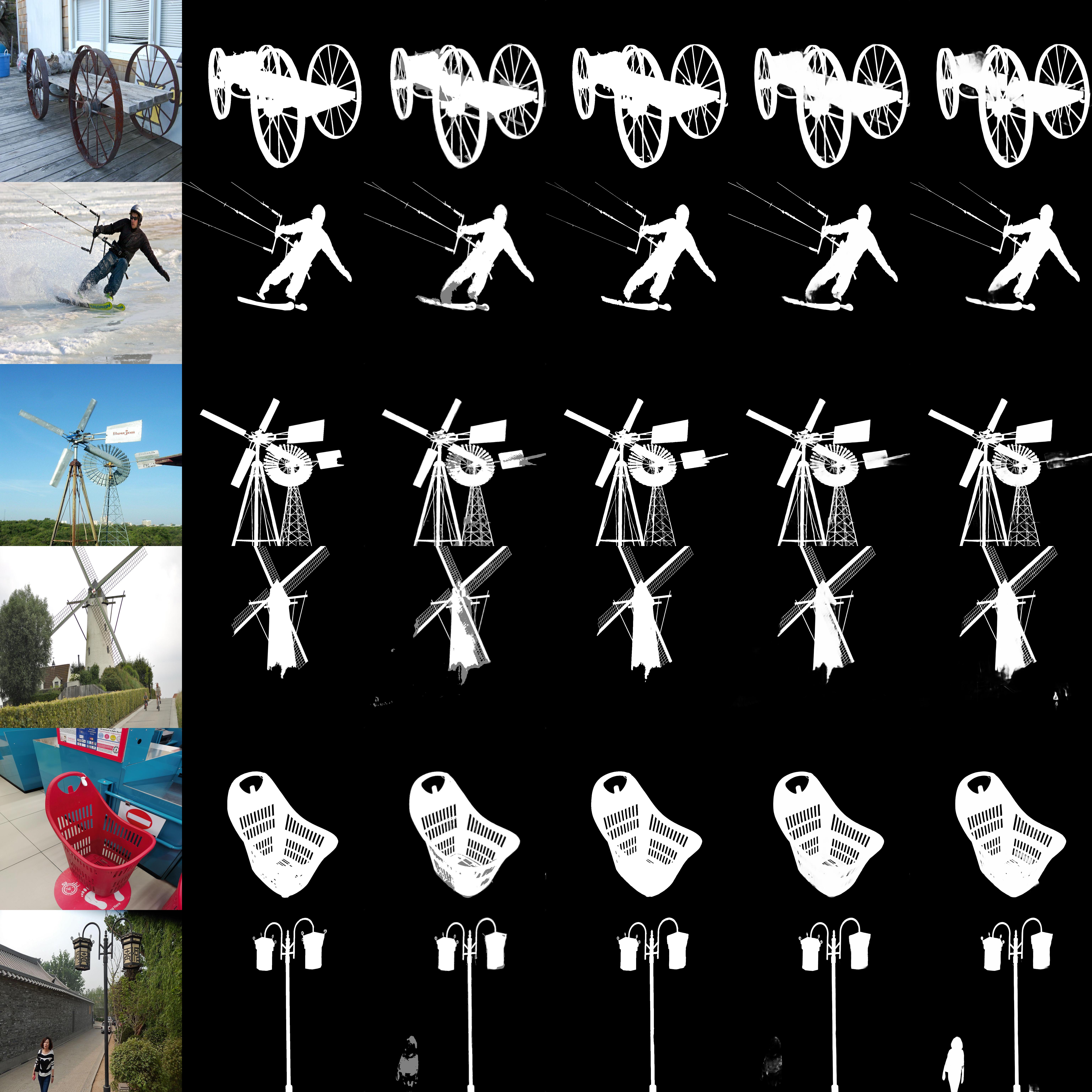

DIS5K検証データセットを用いて、Max F-measure, Weighted F-measure, Structural Similarity Measure, E-measure, MAE, Dice, IoU, BER, Accuracyといった指標で定量評価を行い、既存手法と比較。また、図2で視覚的にリファイナーによるセグメンテーション精度の向上を示した。

6. この論文における限界は?

トリマップ生成のハイパーパラメータ調整に依存する部分がある。

7. 次に読むべき論文は?

MVANet [7]、DiffDIS [10]、そしてマッティング関連の論文[13]。

補足

信頼度の低い部分は灰色で出力(Base Model)、後段でリファインさせる

提案手法(BEN:下図)のアーキテクチャーは先行研究のMVANet(Multi-view Aggregation Network)に似ているがマルチビューをやめている。Swin Transformerバックボーン+マルチビューだと重くてエッジ予測だと厳しいため。

通常、セグメンテーション(Matting)では黒(背景)、白(前景)を予測するが、提案手法で追加割れているトリマップは、黒(背景)、白(前景)、灰色(不明)の3つの領域を予測する。

提案手法のアルゴリズム

ベースモデル:かなり曖昧性を残した解釈をする。ニューラルネットの出力が0.1以下なら黒、0.9以上なら白のように明らかにわかる部分しか確定させない。それ以外は不明にしてしまう。

リファイナーに行く前にトリマップをリファインさせる。ここはルールベースアルゴリズム。各イテレーションでしきい値 t_l, t_h を定量的に上下させ、ピクセルの判定(0/128/255)を更新していく“しきい値の段階的更新”アルゴリズム。

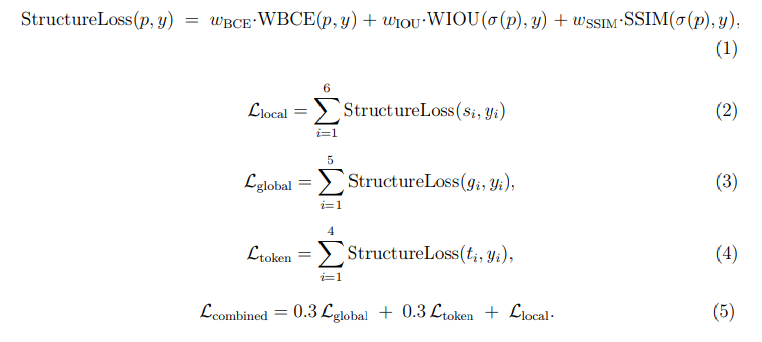

損失関数

Structure Lossを基本とする。Binary Cross Entropy(BCE)、IoU(セグメンテーションの評価指標)、SSIM(画像の構造的類似度の評価指標)の複合。さらに、それをローカル、グローバル、トークン単位で複合させる。トークン単位の損失使ってるのがTransformerらしい。

結果

モデル

- BenBaseはMITで公開。https://huggingface.co/PramaLLC/BEN2

- Refinerモデル(商用モデル)の商用利用はご連絡くださいという感じだった

- とはいったものの、RefinerモデルはBaseモデルの最善版から訓練しましただし、そこまで訓練が重くないモデルかと思われるので、やる気と時間のある人はRefinerを訓練できると思う

- APIも公開されている。https://backgrounderase.net/home

所感

- 基盤モデルが登場する前のディープ時代のコンピュータービジョンであったような渋い論文

- トリマップを学習に組み込むっていうのは、言われてみれば当たり前のようだけど、あんまりセグメンテーションでは見ないのが謎。Mattingの文脈だと検索したらまあまあ出てきたけど、学習に深く組み込んだってのが新しい部分だと思う

- 研究出しているのがスタートアップかと思われるが、ビジネス戦略との両取りがうまい

Shikoan's ML Blogの中の人が運営しているサークル「じゅ~しぃ~すくりぷと」の本のご案内

技術書コーナー

北海道の駅巡りコーナー