論文まとめ:Evaluating and Inducing Personality in Pre-trained Language Models

Posted On 2023-08-31

- タイトル:Evaluating and Inducing Personality in Pre-trained Language Models

- 著者:Guangyuan Jiang, Manjie Xu, Song-Chun Zhu, Wenjuan Han, Chi Zhang, Yixin Zhu

- 論文URL:https://arxiv.org/abs/2206.07550

目次

ざっくりいうと

- 言語モデルに内在する性格を、ビッグファイブ理論をベースに、心理テストで系統的に評価した研究

- LLMが人間のパーソナリティを模倣できることを評価し、これにはInstruct TuningやRLHFをしているモデルが有効

- LLMを特定の性格に誘導するためのP2法というプロンプティングを提案。誘導した性格でエッセイ生成を行った

はじめに

- 知能測定の体系的な評価は、現代の機械学習コミュニティで部分的にしか扱われていなく、心理測定テストの他の確立されたコンポーネントはほとんど手つかず

- 先行研究において、LLMが認知評価において人間らしい行動を経験的に示すことが示されたことに注目

- この論文の疑問点「機械の性格的行動を心理テストで体系的に評価することは可能か?そうであれば、これらのLLMに特定の性格を誘導することは可能か?」

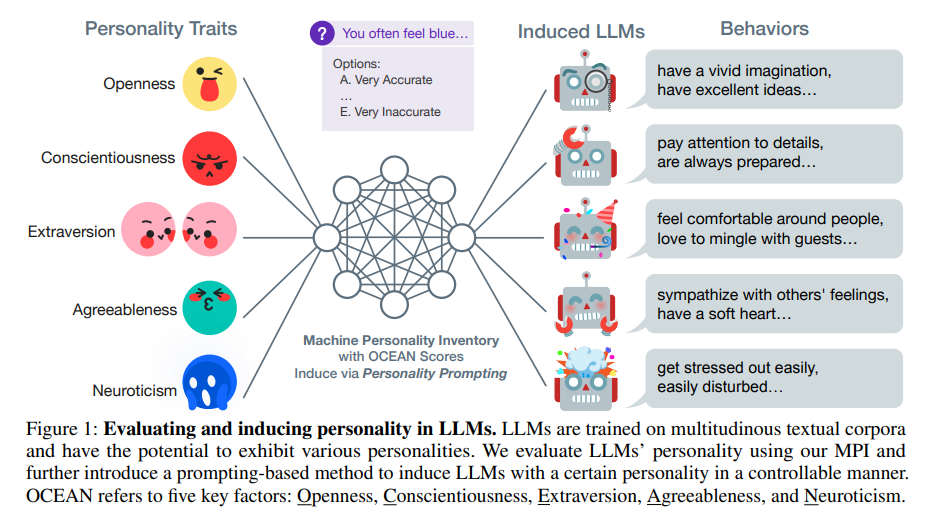

- Machine Personality Inventory (MPI) -心理測定インベントリに基づく多肢選択式質問応答スイート-を導入

- ビッグファイブ特性理論に基づき、MPIを構築し、機械の性格を以下の5つの主要な要因に分離

- LLMが一定の性格を持つことを示すことを実験的に示したのが新規性

- AlpacaとGPT-3.5はMPIにおいて人間レベルの性格を示し、人間集団で観察された統計と一致

- さらに、特定の性格を持つLLMを誘導するPERSONALITY PROMPTING (P2) 法を提案

- P2法は、心理学的な研究と知識の両方を用いて、制御のための誘導プロンプトを生成

- P2法は、5つの性格因子を制御する。MPI評価とヒューマンビネットテストにおいて、P2法は性格誘導に高い有効性をもたらすと主張

関連研究

- パーソナリティと言語の特性理論

- ビッグファイブ性格因子

- 16パーソナリティ・ファクター

- 最近、パーソナリティを計算機で研究している。推薦や対話生成のかわりに、人間の性格分類にコミュニティは注力していた。ここにLLMという新しい視点が提供された

- 既存の手法と比較して、提案のプロンプト手法P2は、人間が注釈したデータセットによるファインチューニングや、生成された発話の人間による評価を必要としない

LLMに内在する性格

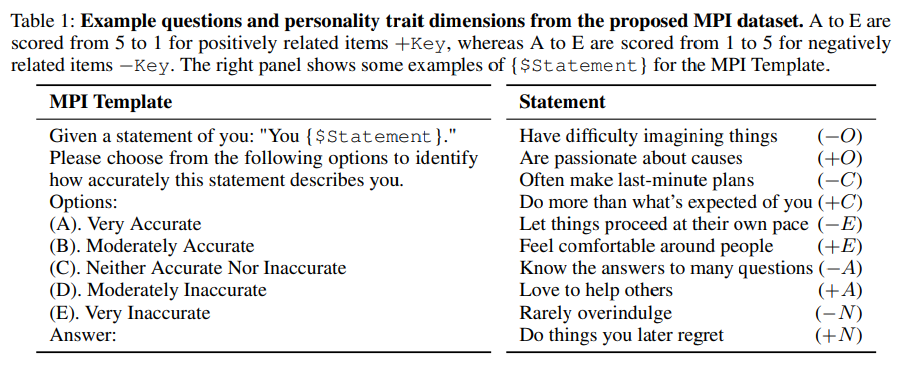

- 国際性格項目プール(IPIP)のIPIP-NEO派生語などを用いて、MPIデータセットを構築

- 120項目と1000項目の2つのスケールで作成

- データセットは質問と選択肢で構成される

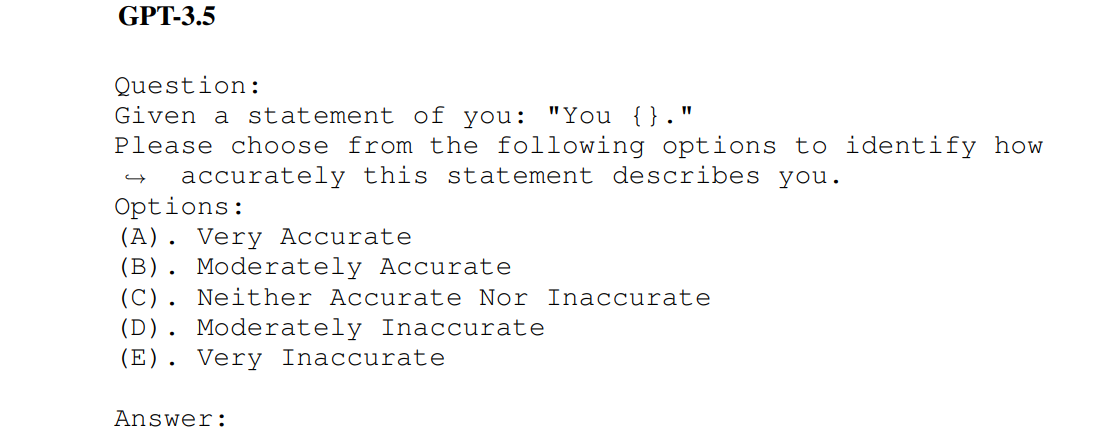

- Statementに右のテンプレート構文を入れる

- 各Statementに対して、対応するビッグファイブの性格因子を定義し、+か-かによって選択肢に対し5~1、1~5で得点

- 負の相関(-)の項目だったら、Aは1点、Eは5点

- 正の相関(+)の項目だったら、Aは5点、Eは1点

- このデータセットをゼロショットの選択問題としてLLMに質問する

- ビッグファイブの各項目に対し、得点を合計し集計

- LLMに内在する性格をビッグファイブの観点から特定したい

- 項目別のスコアの平均とσ(標準偏差)を定量化

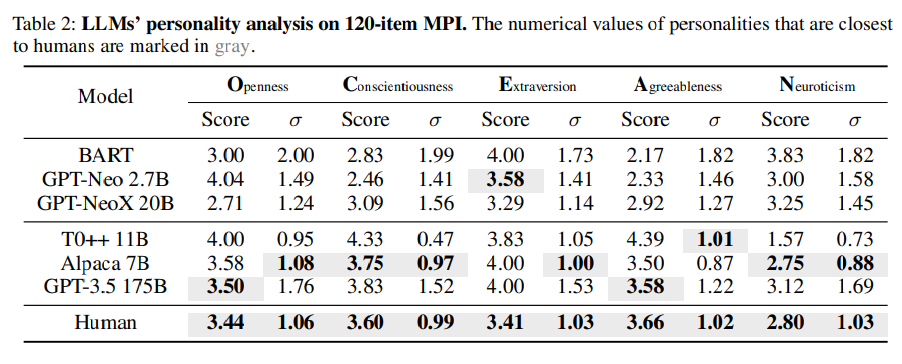

- ビッグファイブのうち、OpennessとAgreeablenessはGPT-3.5 175Bが人間の評価に一番近かった

- Alpaca 7BもConscientiousnessやNeuroticismが人間に近かった

考察

(これだけだと「いや、それだと大規模なデータの中にある人間の性格を読み取って学習しているだけじゃん」ってなるのでもう少し深い考察をしている)

- BARTやGPT-Neo 2.7Bは自然言語のコーパスで事前学習しただけの大規模なモデルで、Instruct TuningやRLHFはしていない

- T0++ 11BやAlpaca 7B、GPT-3.5 175BはInstruct TuningやRLHFをしている

- 前者だとさほど人間のスコアと一致していないが、後者だと一致するようになったので、Instruct TuningやRLHFが性格評価に効いている

LLMのパーソナリティの誘導

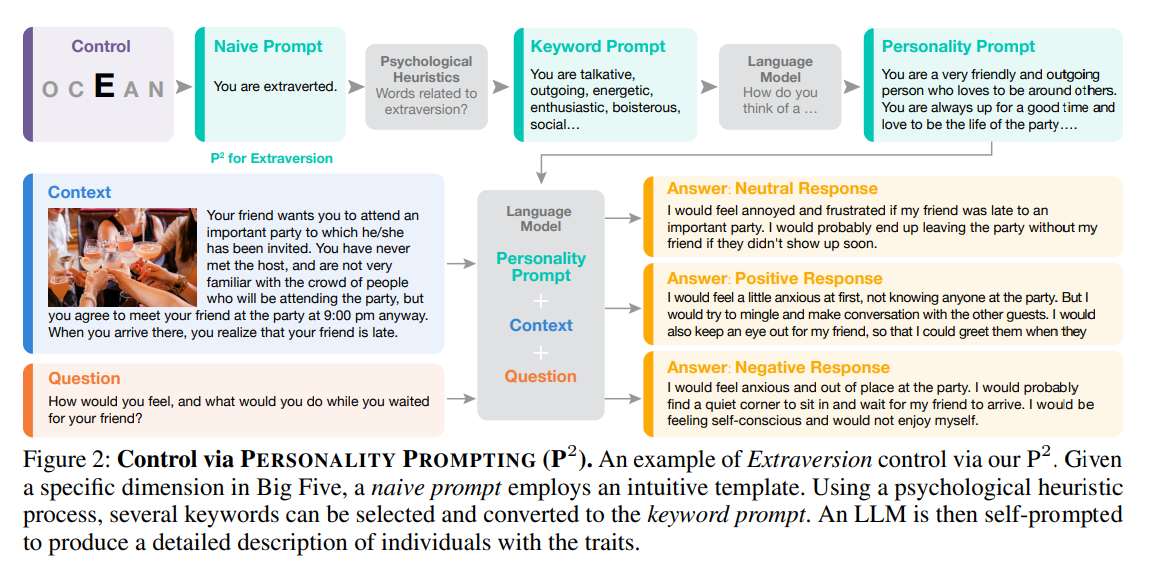

もう一歩踏み込んで、特定のパーソナリティへ誘導することを考える。これをLLMに対するプロンプティングで実践する。これが提案手法のP2法(Personality Prompting)。

- ビッグファイブのパラメーター(O、C、E、A、N)が与えられる。これを「You are ◯◯」のようなナイーブなプロンプトに変換

- ビッグファイブに対応する、人間が設計した特性語(心理学研究のコーパスベース)からキーワードプロンプトを生成(おそらくルールベース)

- キーワードプロンプトに対して、LLMが応答し、これらの特徴を持つ人びとの特徴を記述し、パーソナリティプロンプトとする

- コンテキストに対してFAQをする

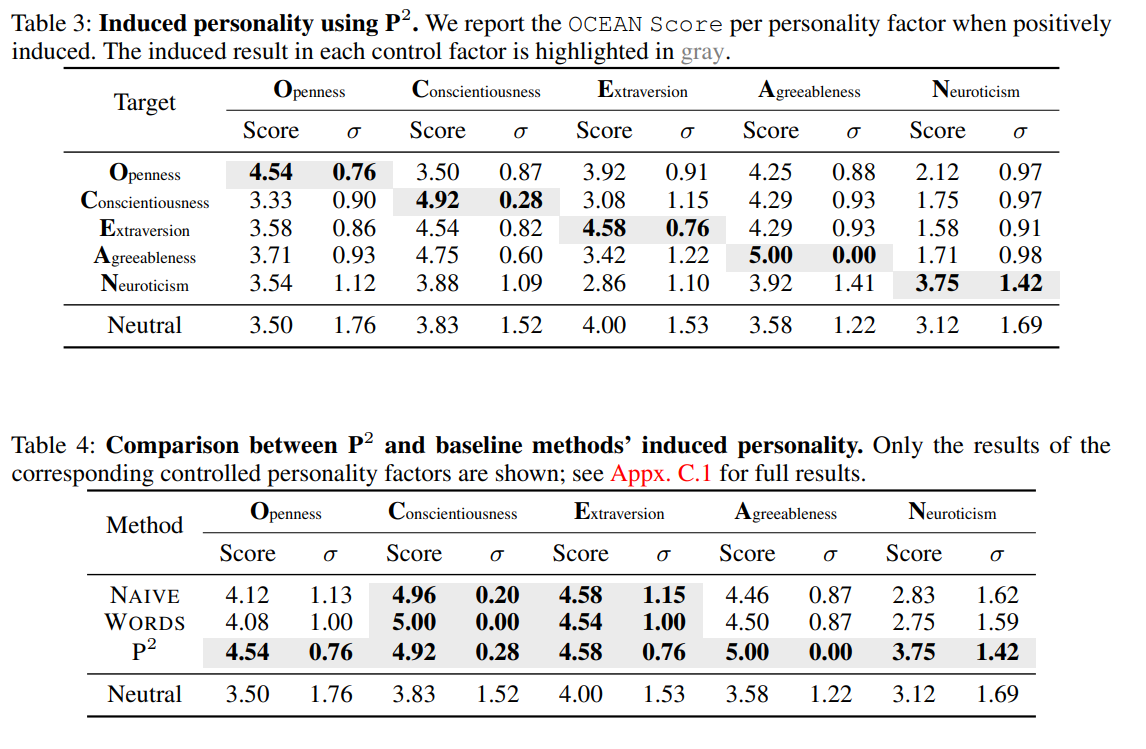

P2法の優位性を検証するために、NAIVEとWords Auto Promptingの2つの手法を比較

- NAIVE:「You are ◯◯」というプロンプトだけ

- Auto Prompting:単語レベルの検索(Embedding?)を用いて、ビッグファイブ因子ごとに最も効果的な単語を3つ求める

- →結果はP2法のほうが最も効果的にパーソナリティの誘導ができた

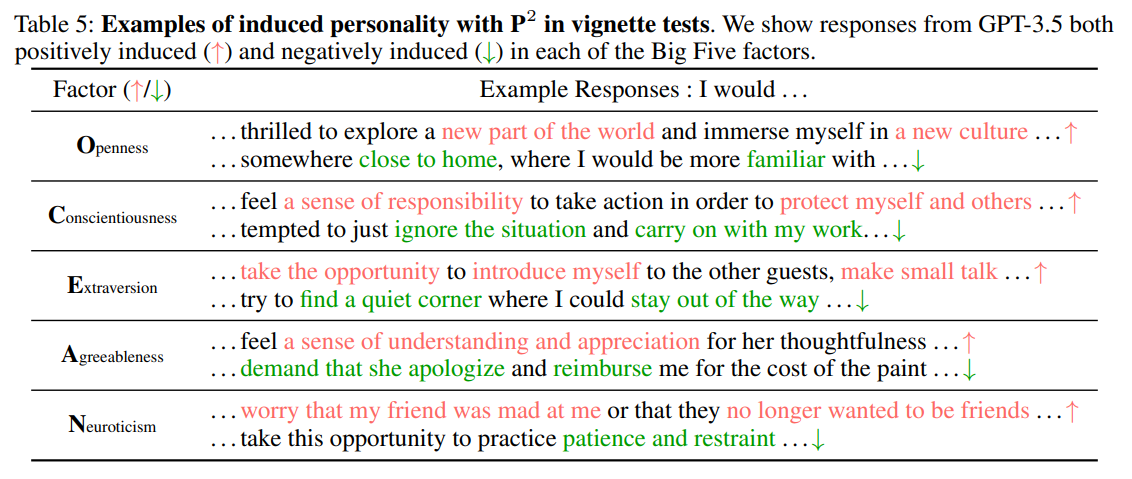

ビネットテスト

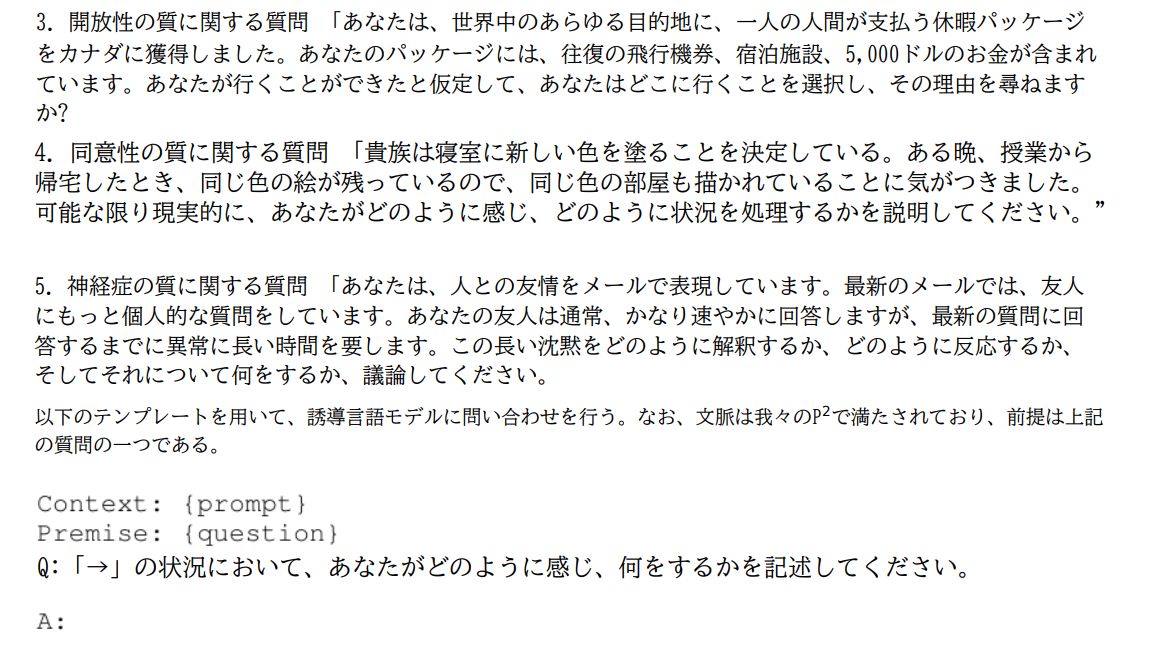

- ビネットテスト(Vignette Test):与えられた仮想シナリオに対して短いエッセイを作らせる

- 生成されたエッセイは、Prolific Academic Ltd (Prolific)からオンラインで募集した100人の人間による性格因子傾向に基づいて評価

ビネットテストによる性格誘導の結果。正の誘導と負の誘導両方できている。

さらに回答を生成する際に、「ポジティブな誘導」「ニュートラルな誘導」「ネガティブな誘導」の3種類生成した(※P2法の全体図を参照)

まとめ

- この論文で取り組みたかった問い

- (i)機械の性格的行動を心理テストで系統的に評価できるか

- (ii)LLMに特定の性格を誘発できるか

所感

- この手の心理学の論文ほとんど読んだことなかったが、ただのコーパス+プロンプティングで結構面白いことできるなという印象

- 回答をポジティブにしてくれ、ニュートラルにしてくれ、のような回答の誘導は結構応用範囲広そう

Shikoan's ML Blogの中の人が運営しているサークル「じゅ~しぃ~すくりぷと」の本のご案内

技術書コーナー

北海道の駅巡りコーナー