Wan: Open and Advanced Large-Scale Video Generative Models

- 論文タイトル:Wan: Open and Advanced Large-Scale Video Generative Models

- URL:https://arxiv.org/abs/2503.20314

- GitHub:https://github.com/Wan-Video/Wan2.1

目次

論文要約:Gemini 2.5 Pro

はい、承知いたしました。ご指定の論文「W A N : O PEN AND A DVANCED L ARGE -S CALE V IDEO G ENERATIVE M ODELS」について、60秒で読めるように一問一答形式で回答します。

- この論文において解決したい課題は何?

既存のオープンソース動画生成モデルに見られる、①性能が商用モデルに劣る、②機能が限定的(主にText-to-Videoのみ)、③計算効率が悪く実用的でない、という課題を解決することです。 -

先行研究だとどういう点が課題だった?

先行研究のオープンソースモデルは、最先端のクローズドソース(商用)モデルと比較して、生成される動画の品質や忠実度で劣っていました。また、多くが基本的なText-to-Videoタスクに限定され、多様な動画制作ニーズに応えられず、大規模モデルは計算コストが高いという課題がありました。 -

先行研究と比較したとき、提案手法の独自性や貢献は何?

Diffusion Transformerを基盤としつつ、独自の高効率な時空間VAE、大規模データ(数十億の画像・動画)での学習戦略、多タスク対応(画像からの動画生成、指示に基づく編集、個人化、中英両言語のテキスト描画など8種)を実現した点が独自性です。高性能な14Bモデルと軽量な1.3Bモデルを提供し、コードとモデルを全てオープンソース化した点も大きな貢献です。 -

提案手法の手法を初心者でもわかるように詳細に説明して

テキスト(文章)から動画を作るAIモデル「Wan」を開発しました。まず、動画を効率的にデータ圧縮・復元できる「時空間VAE」という技術を使います。次に、「Diffusion Transformer」という仕組みで、テキスト指示に従って、圧縮されたデータからノイズを取り除きながら、リアルな動画を生成します。大量の動画と画像データで学習させることで、動きの大きさや品質、指示への忠実度を高めました。特に、1.3Bモデルは少ないGPUメモリ(約8GB)でも動作するように工夫されています。 -

提案手法の有効性をどのように定量・定性評価した?

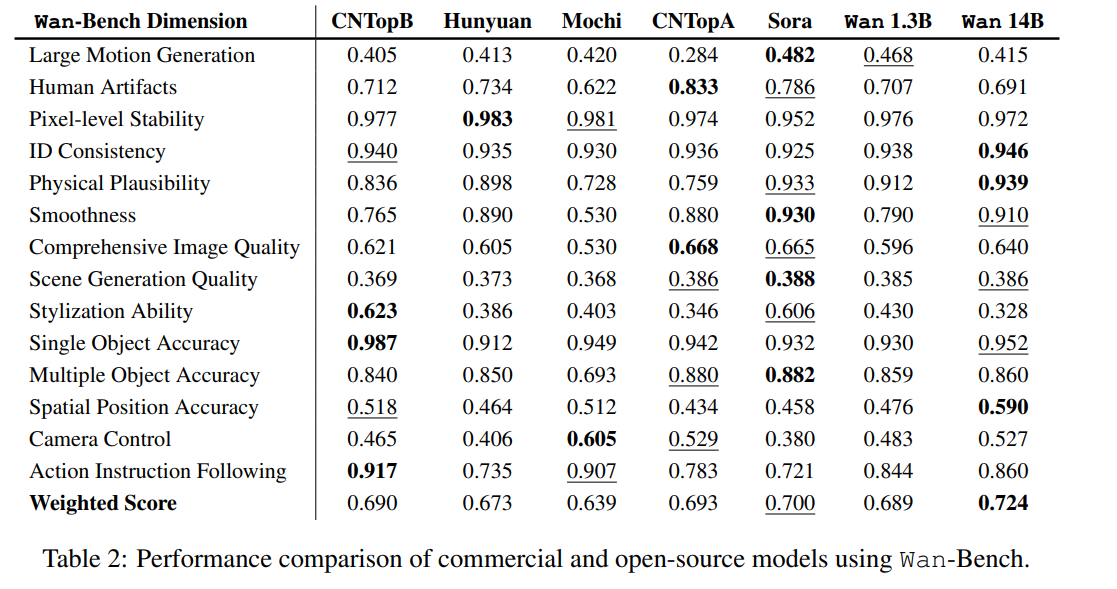

定量的評価: 独自開発したベンチマーク「Wan-Bench」や既存の「VBench」を用いて、他のオープンソースモデルやSoraなどの商用モデルと比較し、複数の評価指標で優位性を示しました。

定性的評価: 生成された動画サンプルを示し、動きの大きさ、忠実度、詳細表現、テキスト生成能力、多様なスタイルなどの品質を視覚的に評価しました。また、人間による評価でも高いスコアを獲得しました。 -

この論文における限界は?

大きな動きを含むシーンでの細かいディテールの保持が難しい点、大規模モデル(14B)の推論には依然として高い計算コストがかかる点、汎用モデルであるため特定の専門分野(例:医療、教育)における性能が十分でない可能性がある点が挙げられています。 -

次に読むべき論文は?

- 比較対象として挙げられているモデルの論文: Sora (OpenAI, 2024), Kling (Kuaishou, 2024.06), HunyuanVideo (Kong et al., 2024), Mochi (GenmoTeam, 2024), CogVideoX (Yang et al., 2025b) など。

- 基盤技術に関する論文: Diffusion Transformer (DiT) (Peebles & Xie, 2023), Flow Matching (Lipman et al., 2022), VAE (Kingma, 2013)。

- 関連する応用タスクの論文: 論文内で言及されているVACE (Jiang et al., 2025) など。

- 論文中にコードが提示されていれば、それをリンク付きで示してください

はい、提示されています。以下がリポジトリへのリンクです。

https://github.com/Wan-Video/Wan2.1

その他

学習データ

- 高品質な動画像データをめっちゃ頑張って収集

- 動画生成のアノテーションを作るために、Gemini 1.5 Proに相当する性能のキャプション生成モデルを訓練

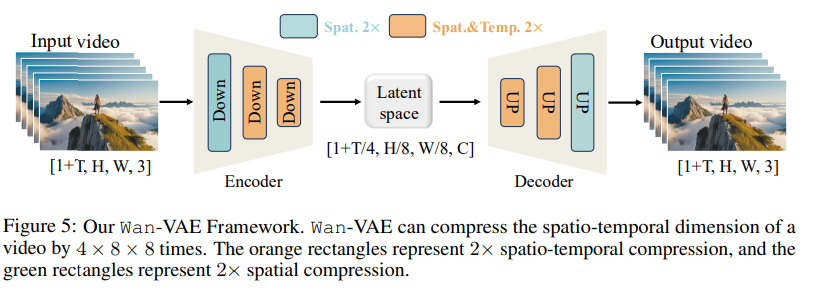

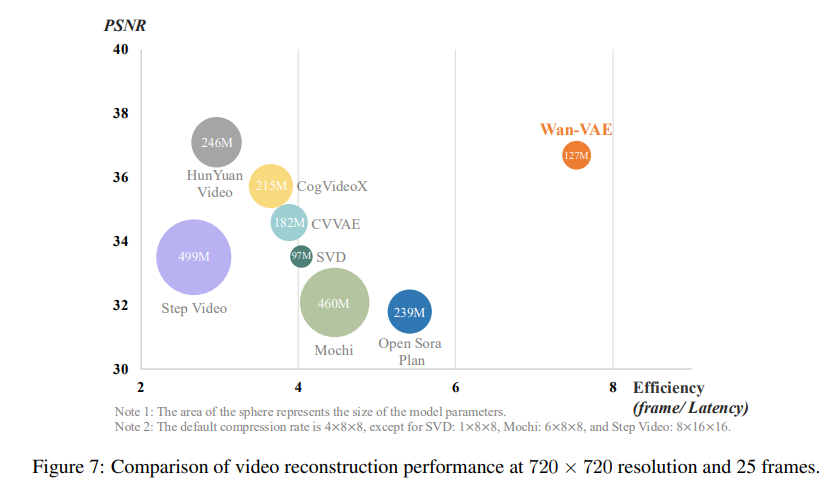

時空間VAE

これが新規提案手法。時空間の因果性を考慮する

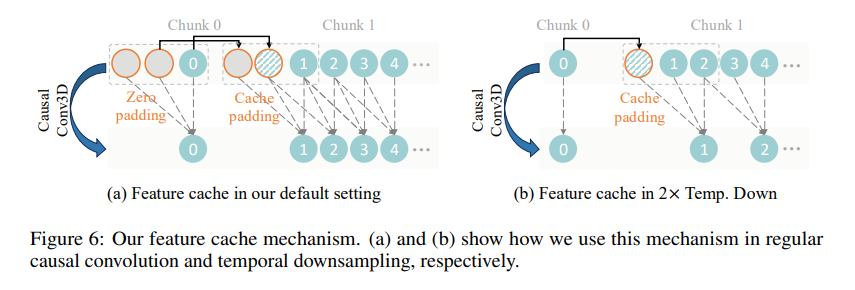

また時間方向の特徴量キャッシュをモジュール内に導入することで、推論パフォーマンスを効率化

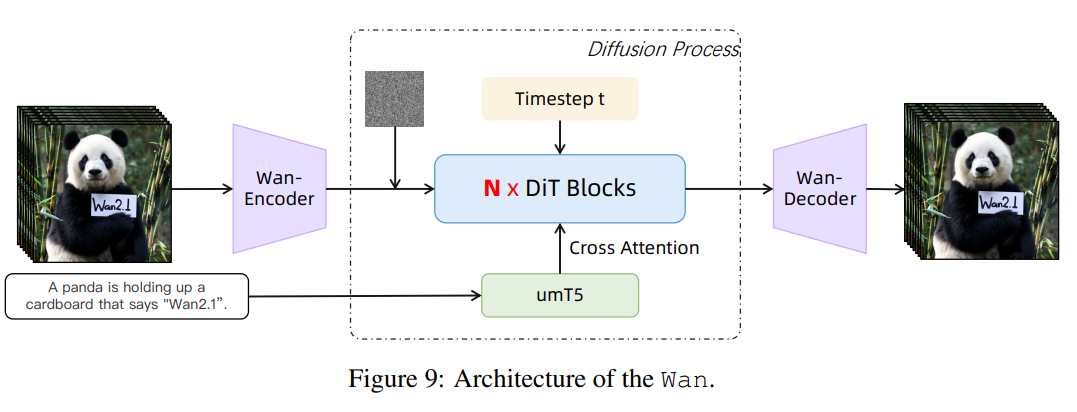

モデルのアーキテクチャー

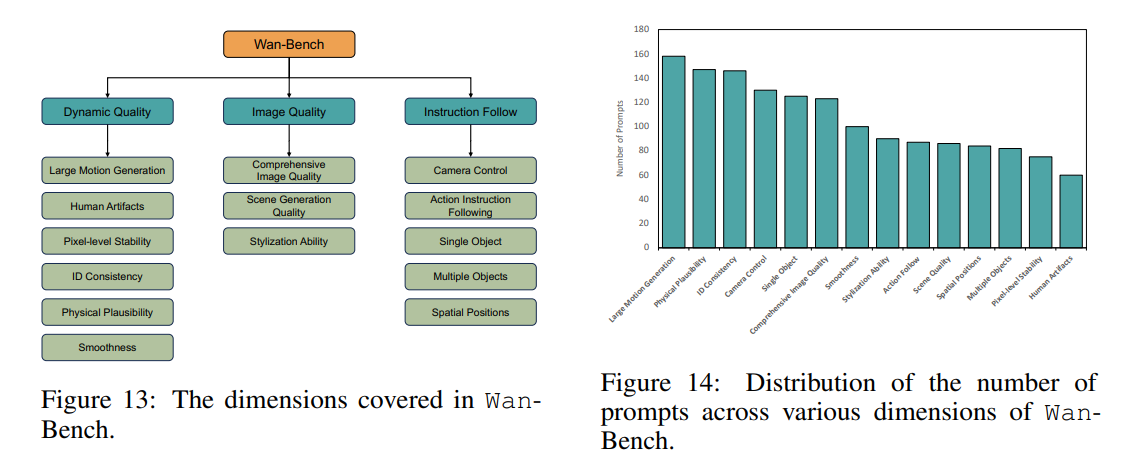

Wan Bench(評価データ)

- モーション:オプティカルフロー

- 人間の人工物:人間がアノテーションしたAI生成画像に対して、YOLOv3を学習して予測結果を分析

- 一貫性:DINOの特徴量を使う

- 物理的な妥当性:Qwen2VLの動画のVQAを通じて物理法則の違反を検出

評価結果

14BモデルはSoraに匹敵するか超えるぐらい

売り

1.3Bモデルは8.19GBのVRAMで良い

Shikoan's ML Blogの中の人が運営しているサークル「じゅ~しぃ~すくりぷと」の本のご案内

技術書コーナー

北海道の駅巡りコーナー