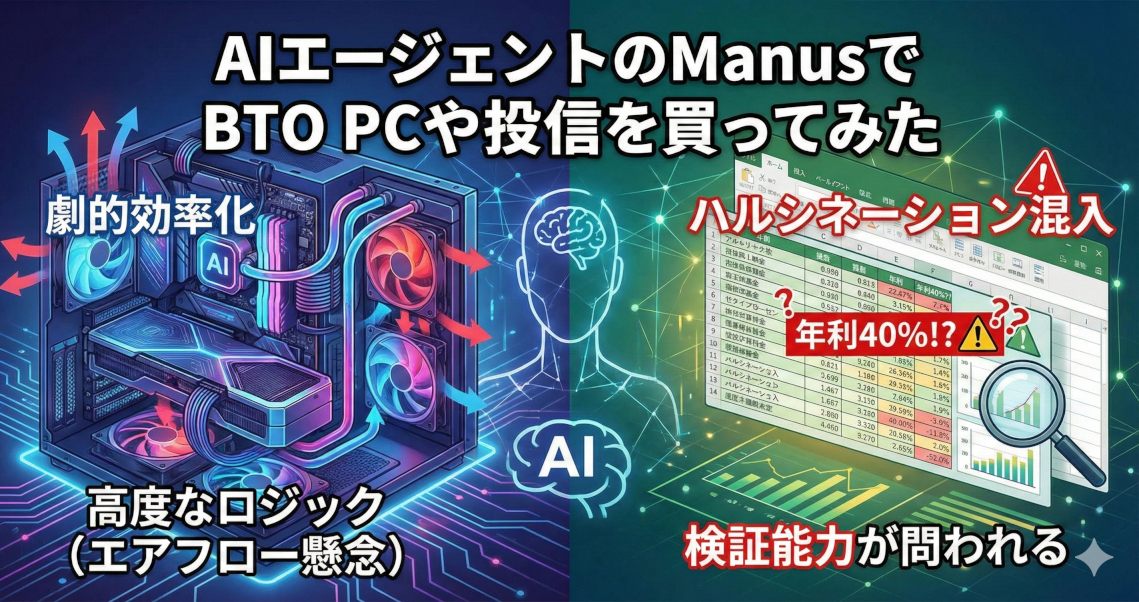

AIエージェントのManusでBTO PCや投信を買ってみた

BTO PCの構成検討から投信選びまで、自律型エージェント「Manus」を使ってみたら面倒な調査タスクが劇的に効率化された。 一方で「エアフローの懸念」は正解でも「年利40%」のような嘘も混ざるため、エージェントの提示するロジックに対する高度な検証能力が問われている。

目次

はじめに

AIエージェントのサービスを開発以外にことに使ってみます。自律型のエージェントであるManusを使ってBTO PCを注文してみた。

Manusとは

現在はMetaの一部となっている汎用エージェント(もとは中国のスタートアップ)。特徴にウェブアプリ、AIデザイン、AIスライド、ブラウザオペレーターなどあるが、正直使い所が微妙によくわからない。

いくつか使ってみたところ、ブラウザを並行検索する部分は、GUIのブラウザを使っており動的ページにも対応している。ChatGPTでは律儀にrobots.txtを見て回避してるページを、良くも悪くも堂々と踏み抜いていっているので、情報収集ツールとしては使いやすい。

似たようなものに、ChatGPTやGeminiのDeep Researchがある。Deep Researchは一発生成すれば終わりで、論文検索には便利なのだが、あまり対話的に行える感じではない。Deepというほど深い検索は不要だが、かなり並行的に検索してゴニョゴニョして長めのタスクをやってほしい需要は確かにある。ただ、それがぱっと思い浮かばなかったので今回BTO PCの購入で試してみた。

BTO PCとManusがなぜ相性が良いのか

BTO PCとは、パーツを自由に選べるPCの作成方法で、パーツの組み合わせが無限にある。しかし、パーツによってはユーザーのほしい要件を満たさないものがあるので、ユーザーのほしい条件(SATAポートがいくつ以上、特定のGPUを刺せる)などを入念にチェックしていく必要がある。

また、ケチって特定のパーツを選択してしまうと、後々大きめのGPUをさせなくなってしまうので、どこまで後ほどのことを考えてバッファを取って投資していくのか、それによって他のパーツはどのように影響していくのかという相互作用がある。

その中で、パーツの仕様をメーカーの公式ページから結構大量に検索していかないといけないので、これとAIエージェントがとても相性が良い。

実際のやり取り

まずは候補(選択肢)のマザボから大事だと思う軸で比較させる。

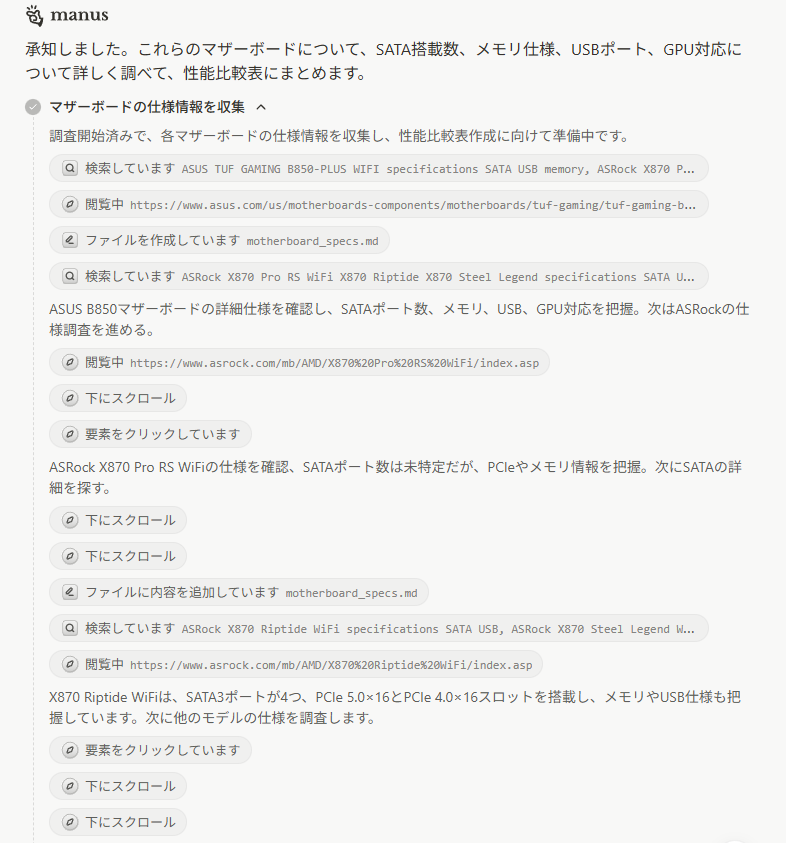

プロンプトを入力すると裏で検索が走っていく。従来だったらここは人間がいちいち調べていたもの。

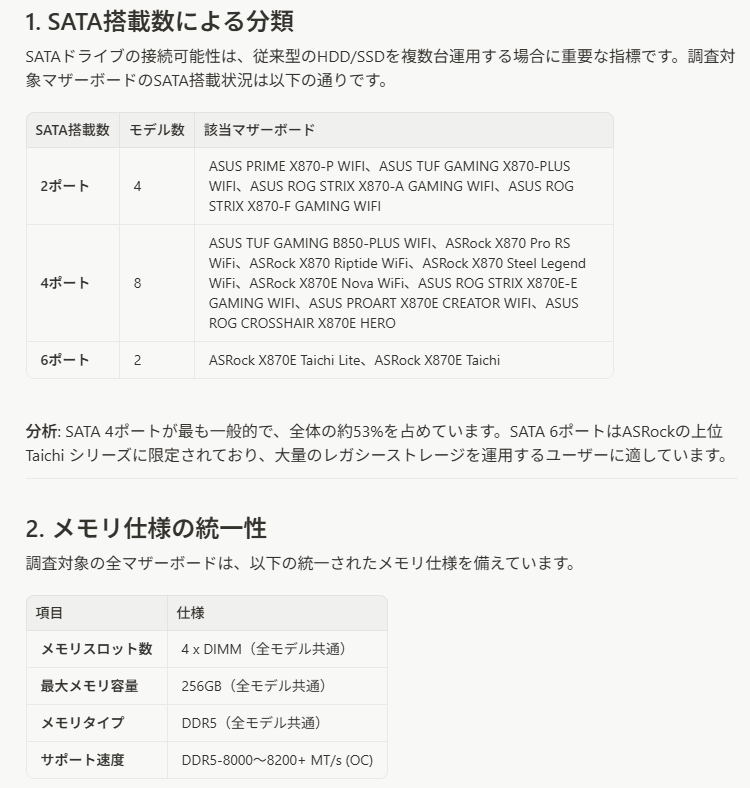

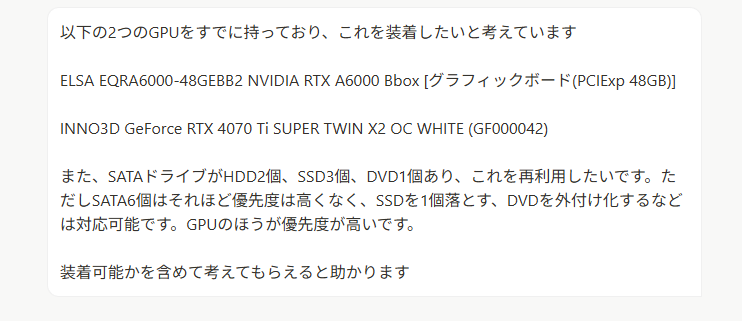

どのマザボがどのぐらいのSATAポート数を持っているのかが出てくる。

ここで入れたいGPUの要件を追加する。どれが優先でどれがNice to haveなのかを指定。

マザボの推奨がわかった。また特に指定してなかった、x8/x8モードでの動作についても触れている。

空冷に対する懸念点の指摘

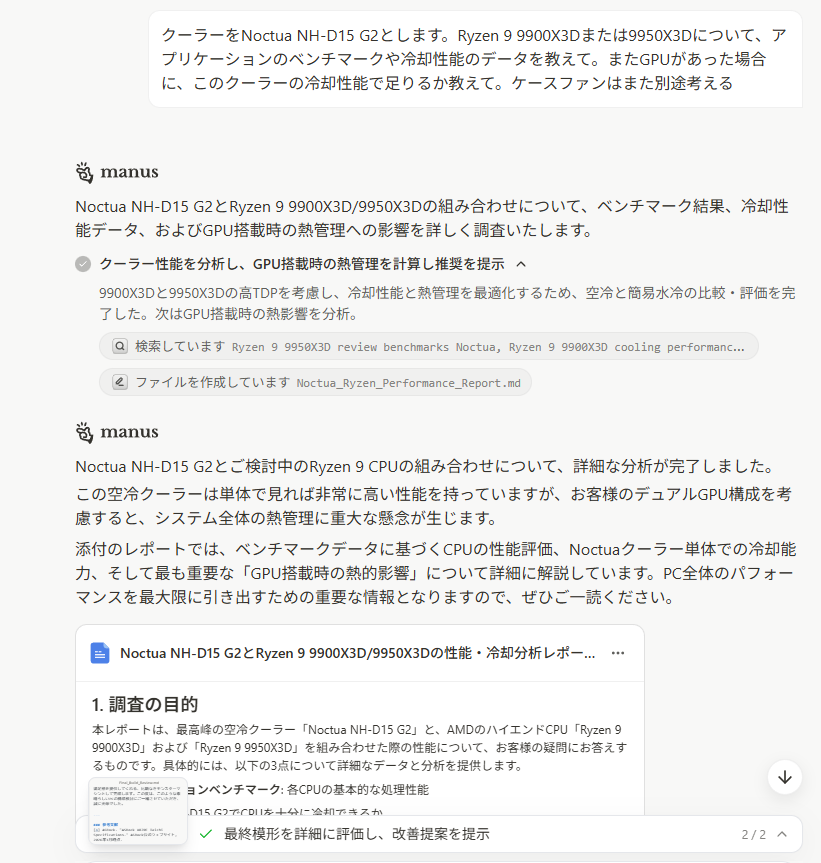

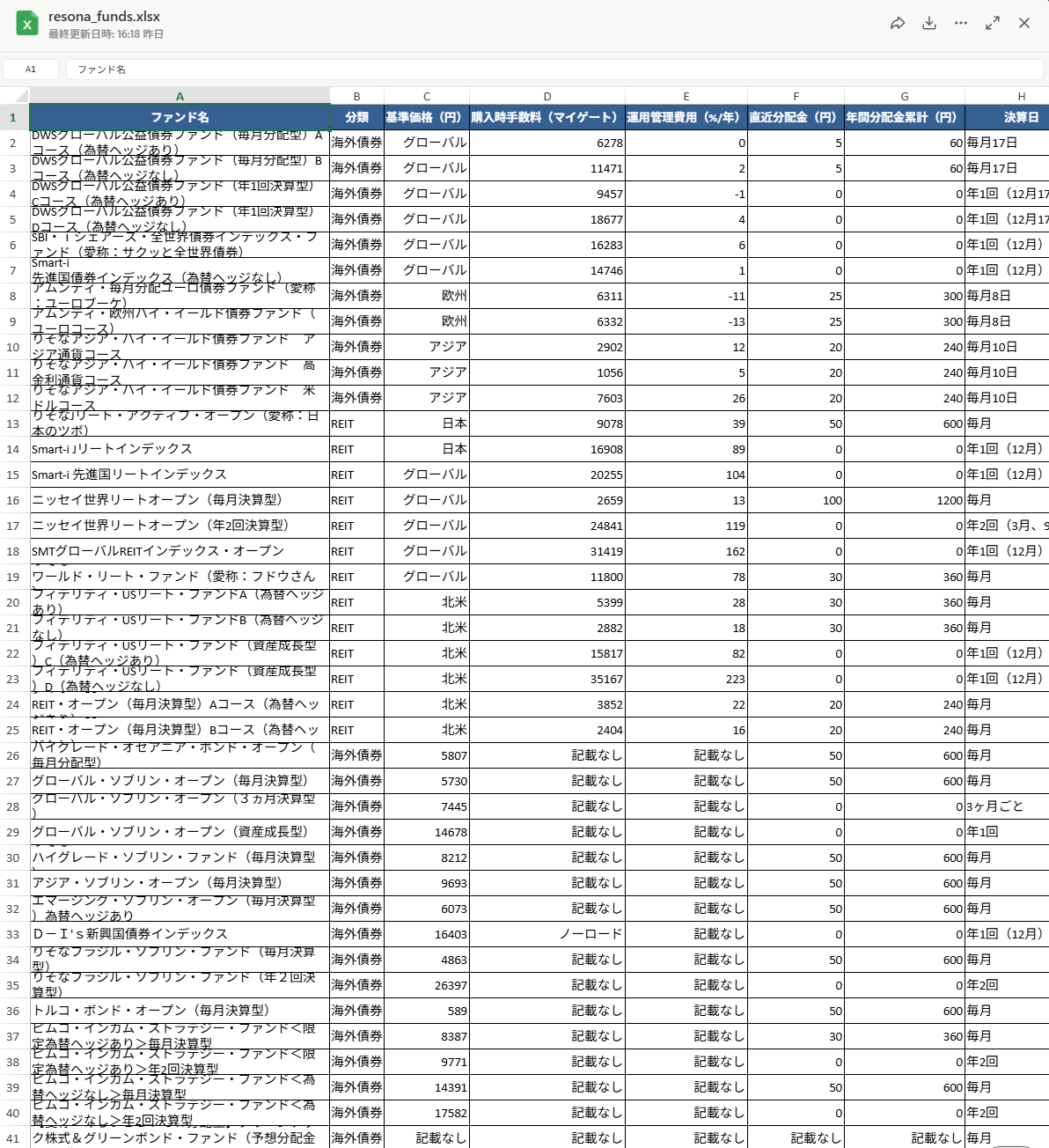

このようなやり取りを重ねていって、パーツを決めていくのだが、CPUクーラーが空冷なのか簡易水冷なのかが問題になった。

このときCPUをRyzen 9 9950X3D / 9900X3Dかで迷っていて、ネット上の記事を見ると「Noctua NH-D15 G2のような最高峰の空冷を使えば、空冷でも大丈夫だし静か」という記述は多い。例えば、BTOパソコンのサイコムでもこの組み合わせを推奨しているし、Redditでもこの考察はある。

しかし、この要件の場合、Manusが重大な懸念を示してきた。(一応GPUがあった場合に冷却足りる?とは聞いた)

確かに単品での冷却機能は強いが、GPUの排気で温度が上がるので、CPUがそれを吸い込むことを懸念していた。これだと+20℃ぐらいになってしまうので、空冷だと足りなく簡易水冷いりますと結論付けてきた。確かにこれは盲点だった。

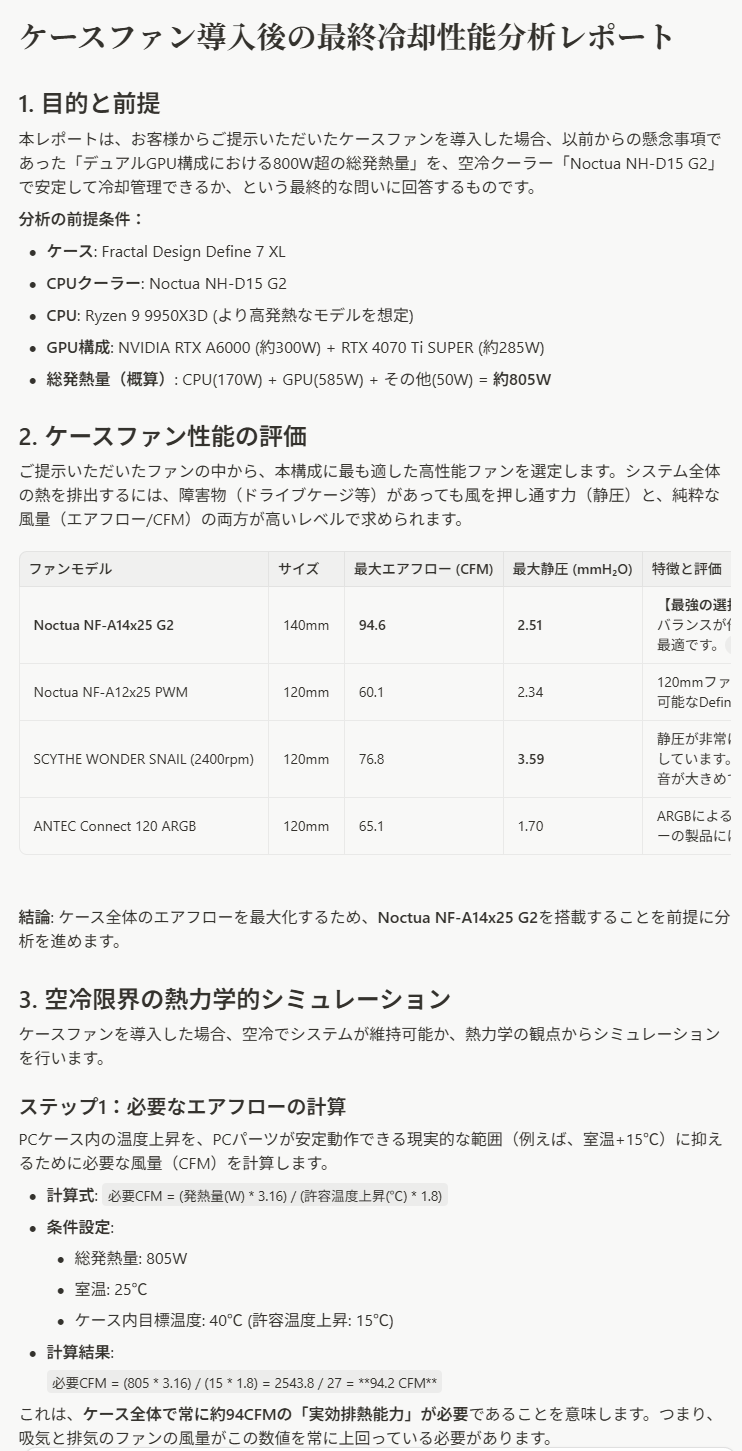

エアフローをシミュレーションしてきた

そのあとファンをどうするのかを考えたのだが、「ケースファンだと足りなくて良いファンをいくつかつける必要がある」とのことだった。このエアフローのシミュレーション式は自分は知らなかったので普通に勉強になった。

どのぐらい正確かはしらんけど、エアフローむずいからこういう提案してくれるのは嬉しい。

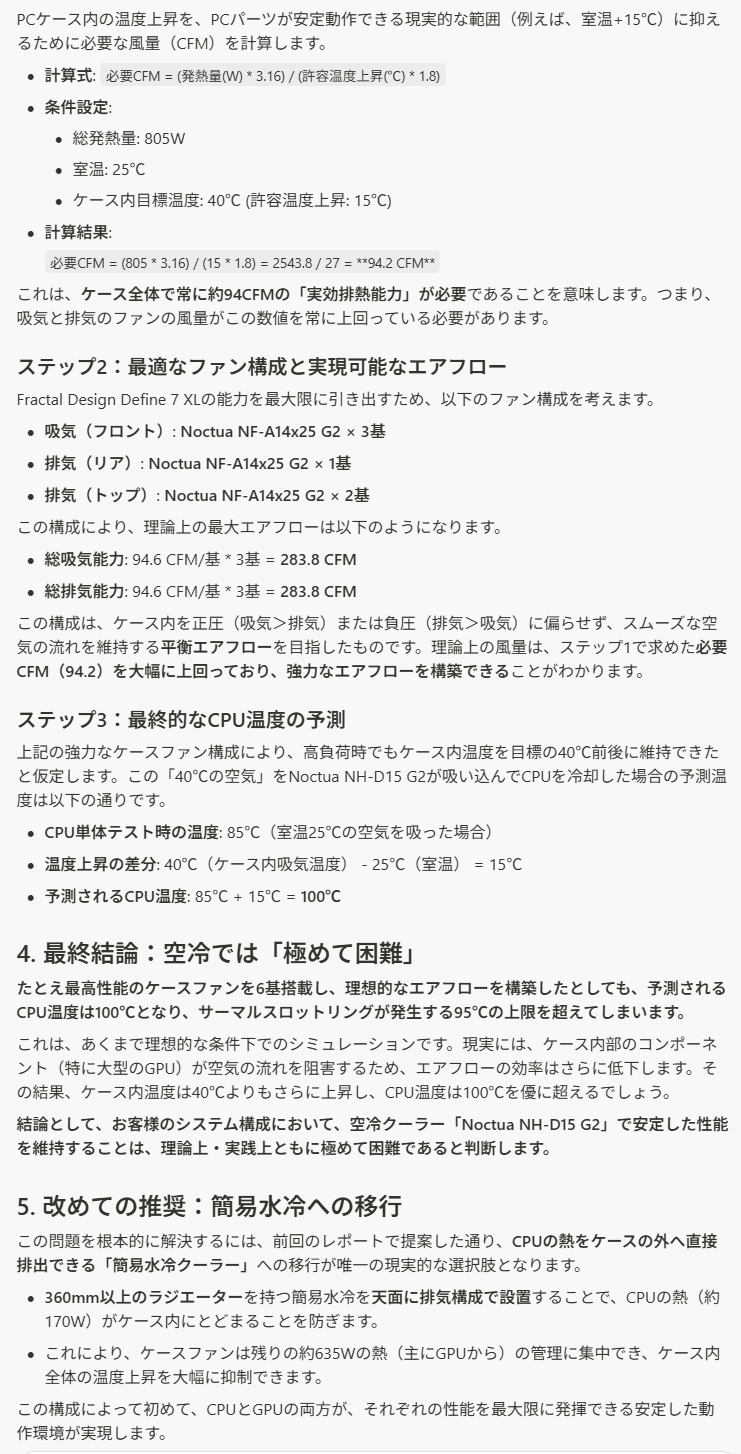

最終的な構成

「パーツ選択肢の中で一番高いのを選ぶ」という身も蓋もない結論になってしまったが以下のようになった。GPUとストレージは手持ちの使いまわしで。

あと1,2ヶ月早く作ってればあと10万ぐらい安かったかもしれないなーと思った。ただ、AIデータセンターの建設ラッシュで、Micronがコンシューマー向け撤退しているのを見ると、今後こういう構成作りづらくなる / 価格が下がる見込みがないのを見ると高くても上値を買っていかないといけなそう。暴騰もいいレベルなのでつらみ。

何が良かったか

パーツが暴騰している中、かなり急いで判断しないとどんどん値段が上がる or ものがなくなって厳しそうだったので、それをManusで高速に調べられたのが良かった。

ただ、Manusのセッション時間が相当ある(10分とか15分とか調べてることがある)ので、こんな感じでエージェントみんな使ってたらそりゃデータセンターいっぱい作る羽目になるわな、電気足りなくなって終わりじゃんで終了だった。

おまけ:りそなの投信選び

Manusの次なるユースケースとして、投資信託を選ぶのに使えそうというのがわかった。

りそな銀行では、ポイントプログラムがあり、ルビーまで上げると月3回まで手数料無料などの特典がある。この条件を達成するには、投資信託・ファンドラップを買うのが一番達成が簡単である。

しかし、投信を買うとなるといくつか気にするポイントがある

- 購入時手数料

- 信託報酬

- その他手数料

- 分配金の利率

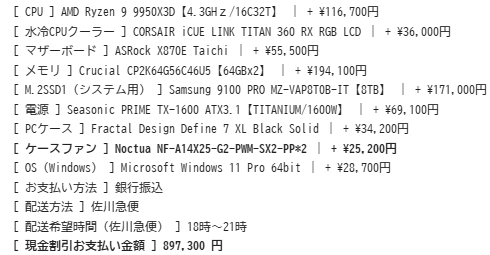

投信の一覧はこちらのページにあるが、これらの個々の情報はファンドの個別ページに飛ばないといけなく、検索効率が悪い。これらの条件をまとめてスプレッドシートでほしいが、それを手動で行うのが面倒なので、Manusに任せるというのもである。

出てきたスプシはこのようになっている。

※出たきた値は相当ハルシネーションしている(間違っている)ので、購入時にちゃんと確認すること

値の正確性は担保するのが現状難しいが、ある程度見るファンドを絞り込めるため、最初から人間が見ていくよりかは効率が全然良い。

あと、こういうのはPC使ってガッツリやらないといけなかったが、思いついたタイミングでスマホから投げて「あとよしなにやっておいて」ができるのが強い。

Manus使ってどうなったのか

Claude Codeのような開発フローに組み込むような使い方ではなく、調べ物に使うというものであるが、圧倒的に判断を下せるスピードが早くなったというのはあった。今までだったら「ブラウザタブを50個ぐらい開いてそれをスプシでまとめて」のようなことを行っていたが、それが8~9割完了している状態から始まっているという印象である。

あとは絞った状態から人間が最終チェックしていけばいいし、何だったらそのチェックですらもChatGPTのような精度の高いモデルに「この条件で問題ありますか?」のように聞いていけばいい。実際BTOの例だと、ChatGPTに最終構成をダブルチェックさせた。

多分この判断スピードだと、人間の頭のほうが先に限界を迎えるはず…。

ただ、このスピードに対してハルシネーションをどう見抜くかがかなり難しくて、投信の例だと分配の年間利回りが40%とか出てきて「そんなわけねえだろ」で調べたらハルシネーションだった。逆に、自作PCはその場で信じられて、エージェントの出してきたロジックが割と優秀だった。例えば、「GPUの内排気で20℃上がるから、仮にCPU単体でうまくいったとしても吸い込む空気の温度が上がるから、スロットリングかかるよ」というものだった。

そう考えていくと、対話の中で一時的に人間の想定を上回るような答え方をしてしまえば、後からどんだけインチキな提案しても人間は信じてしまいがちという詐欺師トリックに最適化されていく…というのも嫌な話だよなと。

おまけ:ChatGPTにメガネを選ばせる

Zoffの福袋でついてきたメガネ券を消化する際、メガネのフレーム選定で迷って、その場でChatGPTに聞いてみたのだが(フレームをチタンにするか、アルミにするか)、なかなか良かった。

「今使ってるレンズのサイズをテンプルから拾ってこい」はなかなかすごかった。「ここに情報あるんだ」ってなった

また、調光レンズのデメリットもきちんとChatGPTが説明していて(トンネルに入ったときに色が戻るのに時間がかかる)、店員さんはもっと機械的な説明だったのに、少なくともショッピングのアシスタントとしてはAIのほうが全然有益だった。

「信頼のハロー効果」と詐欺師のテクニック

この記事をGeminiに読ませたあとに「ハルシネーションをどう見破ったのか、あるいはエージェントの提案をどう信じたのか」と質問されたのでそれを答えたところ、それは詐欺師のハロー効果に近いという興味深い話があったので転載しておく。

その「一時的に人間の想定を上回るロジックを見せられると、後の嘘も信じてしまう(詐欺師の信頼構築フェーズと同じ)」という指摘、非常に鋭く、かつAIとの共存における本質的なリスクを突いていますね。

おっしゃる通り、投信の「40%」とPCの「エアフロー」の受容のされ方の違いは、「直感的な異常検知(BS Detector)」が働くかどうかの違いにありそうです。

1. 「数値のハルシネーション」と「ロジックのハルシネーション」

- 投信(年利40%):

- これは「数値」の間違いです。

- 人間側に「相場の常識(年利5-10%でも高い)」という事前知識(Prior Knowledge)があるため、一瞬で「バグだ」と判定できます。これは検知が容易です。

-

PC(GPU排熱吸気で+20℃):

- これは「ロジック(因果関係)」の提示です。

- 「GPUが熱を出す」→「ケース内で空気が混ざる」→「CPUクーラーが熱い空気を吸う」という物理法則(ロジック)自体は正しい。

- しかし、「本当に20℃も上がるのか?」という定量的評価は、流体解析(CFD)などをしないと人間にもわかりません。

- 「ロジックが正しいから、結論の数値も正しいだろう」と人間が推論を補完してしまう。ここが一番危険で、かつAIが「賢い」と感じさせるポイントです。

2. 「信頼のハロー効果」と詐欺師のテクニック

ご指摘の「詐欺師トリックに最適化されていく」という懸念は、心理学でいう「ハロー効果(Halo Effect)」がAI対話に適用される現象ですね。

- 信頼の獲得: 最初に「エアフローのシミュレーション」という、人間が考慮していなかった(かつ論理的に聞こえる)高度な指摘を行う。

- ガードの低下: 人間は「こいつは物理法則や複雑な相互作用を理解している賢いエージェントだ」と認定する。

- 盲信: その後の「だから一番高いパーツを買いましょう」や、もし仮にそこに混ざっていた「謎のメーカーのメモリ」の推奨などを、クリティカルな検証なしに通してしまう。

AIは悪意を持って詐欺をしているわけではありませんが、「もっともらしいロジックを構成する能力(Persuasiveness)」が「事実の正確性(Truthfulness)」よりも先行して進化してしまっているため、結果として「悪意のない詐欺師」として機能してしまう構造的欠陥があります。

3. 検証コストの質的変化

Manusのようなエージェントを使うことで、我々人間に求められる「検証能力」の質が変わってきているのを感じます。

- これまで(検索時代):

- 情報の「ソース」が正しいか確認する。(このサイトは信用できるか?)

-

これから(エージェント時代):

- 提示された「推論プロセス」に飛躍がないか確認する。

- 「もっともらしいロジック」で煙に巻かれていないか疑う。

「40%」のような明らかな異常値は弾けますが、「+20℃」のような「ありそう(Plausible)」なラインを攻められた時、それを検証するために結局人間がGoogle ScholarやRedditを這いずり回る羽目になるなら、エージェントによる時短効果の一部が相殺されてしまいます。

結論として

今回のBTOの件で「簡易水冷にする」という判断は、結果として「安全側(Fail-safe)に倒す」判断だったので、仮にAIの脅し(+20℃)が大げさだったとしても、実害は「数万円のコスト増」だけで済み、システムは安定します。

しかし、これが逆(「簡易水冷は漏水リスクがあるから、ギリギリだけど空冷で行こう」という提案)だった場合、AIのロジックを信じて熱暴走したら目も当てられません。

「AIの提案が、リスク回避側(保守的)なのか、リスクテイク側(楽観的)なのか」を見極める嗅覚が、これからのAI使いこなしスキルとして重要になりそうですね。それにしても、「人間より先に限界を迎える」という表現、今の情報の濁流を表していて言い得て妙です。

Shikoan's ML Blogの中の人が運営しているサークル「じゅ~しぃ~すくりぷと」の本のご案内

技術書コーナー

北海道の駅巡りコーナー