論文まとめ:Florence-2: Advancing a Unified Representation for a Variety of Vision Tasks

Posted On 2024-08-23

- タイトル:Florence-2: Advancing a Unified Representation for a Variety of Vision Tasks

- 著者:Bin Xiao, Haiping Wu, Weijian Xu, Xiyang Dai, Houdong Hu, Yumao Lu, Michael Zeng, Ce Liu, Lu Yuan

- 論文URL:https://arxiv.org/abs/2311.06242

- モデル:https://huggingface.co/microsoft/Florence-2-large

目次

ざっくりいうと

- 汎用的な視覚基盤モデル「Florence-2」。画像からピクセルレベルまで幅広いタスクに対応。

- 複数のエクスパートモデルから人工的にデータを生成する大規模データセット「FLD-5B」や、統一されたマルチタスク学習パラダイムを提案。

- 高いゼロショット性能を示し、ファインチューニングやダウンストリームタスクの評価でも優れた結果を達成。

要約By Gemini 1.5 Pro

論文概要

この論文では、画像レベルの理解からピクセルレベルの詳細な認識まで、幅広い視覚タスクを単一のモデルで処理できる、汎用的な視覚基盤モデル「Florence-2」を提案しています。

質問と回答

1. この論文において解決したい課題は何ですか?

- 複雑な視覚データを扱うための包括的な認識能力を持つ、汎用的な視覚基盤モデルの構築。

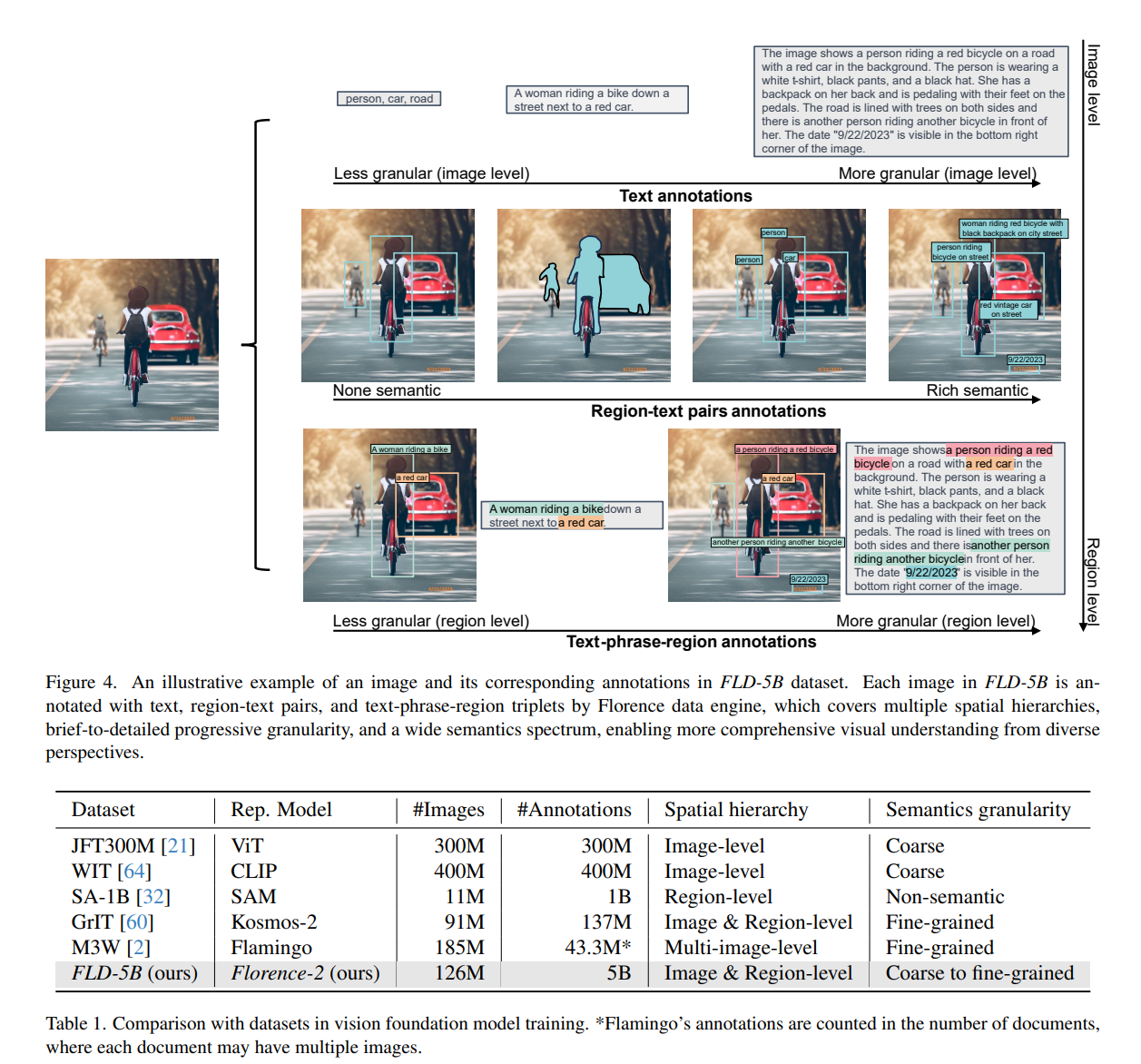

- 特に、空間階層(画像レベルからピクセルレベルまで)と意味粒度(粗い説明から詳細な説明まで)の両方を扱う能力の欠如という課題を解決したい。

2. 先行研究だとどういう点が課題だったのですか?

- 従来の視覚モデルは、オブジェクト検出、セマンティックセグメンテーション、画像キャプションなど、特定のタスクに特化して設計されており、タスクにとらわれない汎用的なモデルが不足していた。

- 包括的な視覚アノテーションの不足により、空間階層と意味粒度の複雑なニュアンスを捉える基盤モデルの開発が妨げられていた。

3. 先行研究と比較したとき、提案手法の独自性や貢献は何ですか?

- 大規模で包括的な視覚データセット「FLD-5B」を構築し、54億件のアノテーションを1億2600万枚の画像に付与。

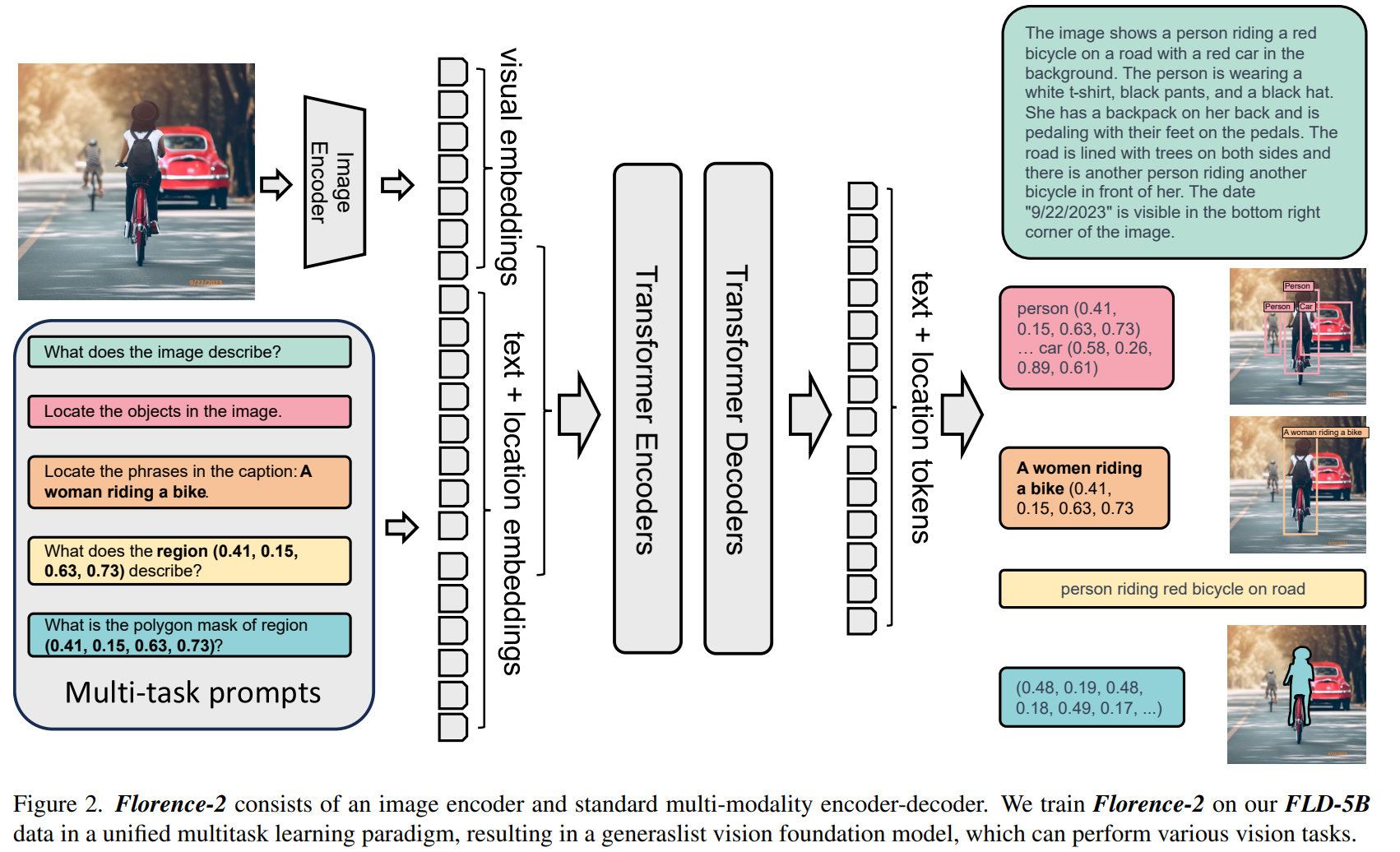

- 統一されたマルチタスク学習パラダイムを採用し、単一のseq2seqアーキテクチャで空間階層と意味粒度を統合。

- テキストプロンプトによって様々な視覚タスクを実行できる、汎用的な視覚基盤モデル「Florence-2」を開発。

4. 提案手法の手法を初心者でもわかるように詳細に説明してください。

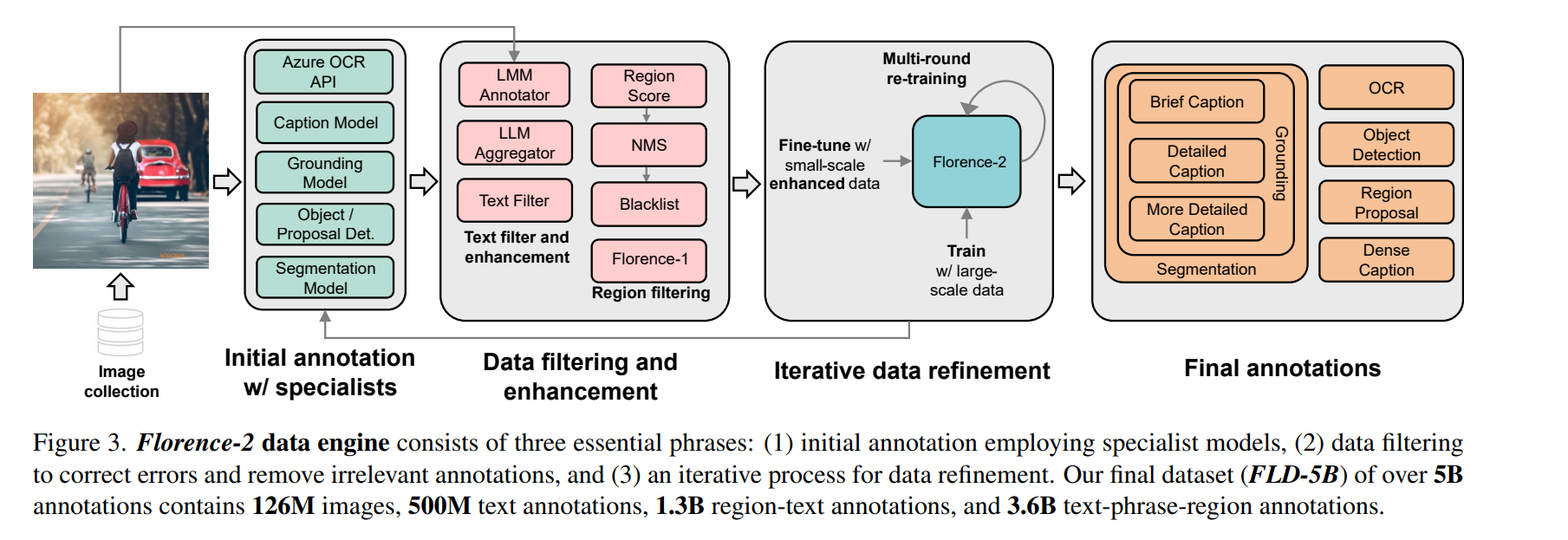

- データエンジンの構築:

- 複数の専門モデルを用いて、画像分類、オブジェクト検出、画像キャプションなどのタスクを自動的にアノテーション。

- アノテーションの精度を高めるために、反復的なデータ改良プロセスを採用。

- Florence-2 モデルの学習:

- 画像エンコーダー(DaViT)を用いて画像を視覚トークン埋め込みに変換。

- マルチモーダルエンコーダーデコーダー(Transformer)を用いて、視覚トークン埋め込みとテキストプロンプト埋め込みを処理し、テキスト形式で出力を生成。

- すべてのタスクを統一された言語モデリング目標の下で学習。

5. 提案手法の有効性をどのように定量・定性評価しましたか?

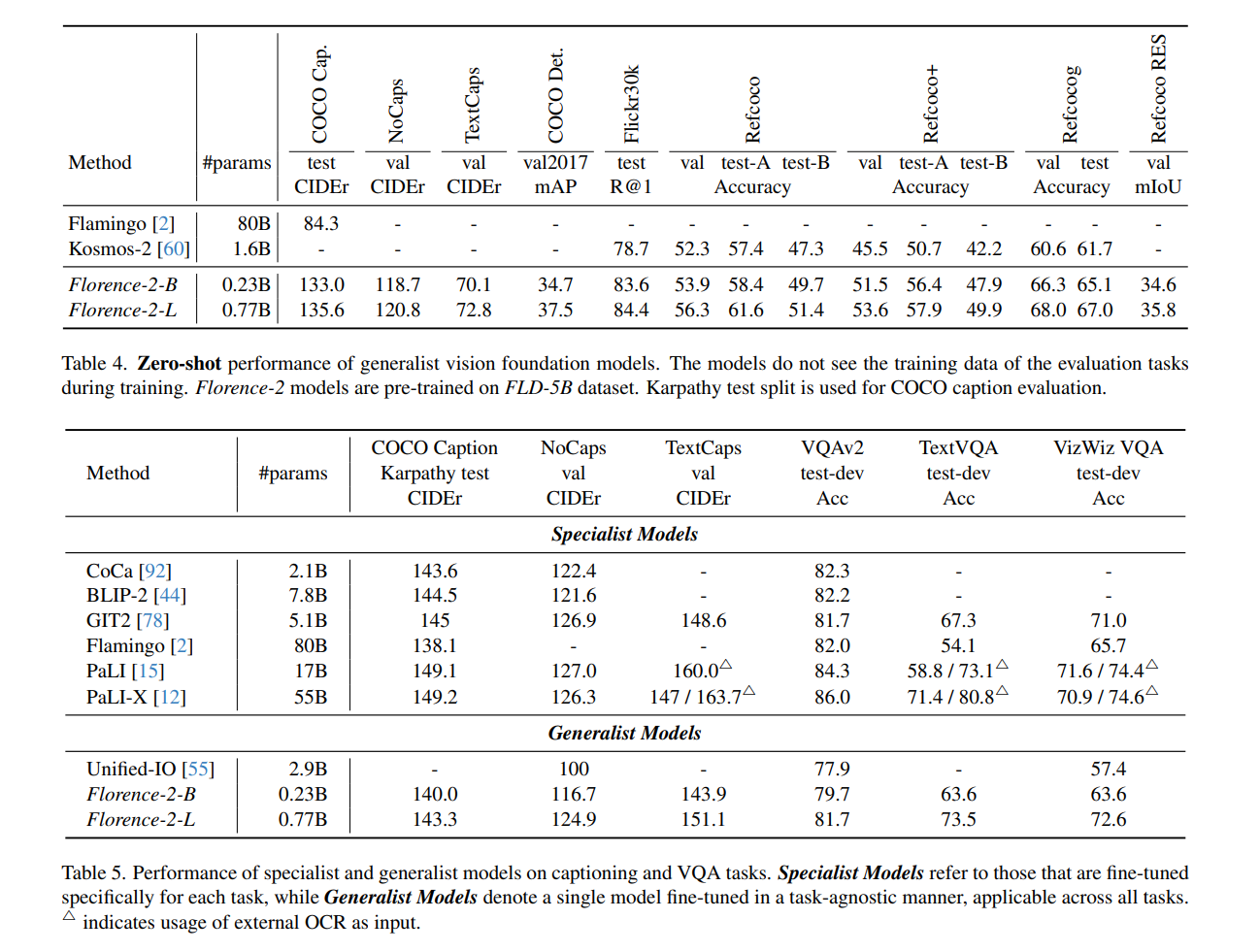

- ゼロショット評価: キャプション、視覚的グラウンディング、参照表現理解などのタスクにおいて、最先端のゼロショット性能を達成。

- ファインチューニング評価: 公開されている人間によるアノテーションデータを用いてファインチューニングした後、Florence-2は、より大規模な専門モデルと競合する性能を達成。

- ダウンストリームタスク評価: 事前学習済みFlorence-2バックボーンは、COCOオブジェクト検出、インスタンスセグメンテーション、ADE20Kセマンティックセグメンテーションなどのダウンストリームタスクの性能を向上させ、教師ありおよび自己教師ありモデルの両方を凌駕。

6. この論文における限界は?

- 計算コストが高い。

- 新しいタスクへの適応には、追加のファインチューニングが必要になる場合がある。

7. 次に読むべき論文は?

- Flamingo: a visual language model for few-shot learning (Alayrac et al., 2022)

- PaLI: A jointly-scaled multilingual language-image model (Chen et al., 2022)

- Unified-IO: A unified model for vision, language, and multi-modal tasks (Lu et al., 2022)

8. コード

論文中にコードは提示されていません。

補足

Florence1

https://arxiv.org/abs/2111.11432

事前学習の工夫

ローカリゼーションのトークンを入れたEncoder-Decoderモデル

Data Engine

- This dataset FLD-5B includes 126M images, 500M text annotations, and 1.3B text-region annotations, and 3.6B textphrase-region annotations across different tasks.

- ImageNet-22k [18], Object 365 [70], OpenImages [40], Conceptual Captions [71], and LAION

- Expertモデルの結果をLLMでマージ

- 背景は人間がラベル付けされたデータが少なく、大規模なデータセットが必要だったため

→事前訓練は合成データで行い、人間がアノテーションしたデータでファインチューニング

Shikoan's ML Blogの中の人が運営しているサークル「じゅ~しぃ~すくりぷと」の本のご案内

技術書コーナー

北海道の駅巡りコーナー