論文まとめ:StarVector: Generating Scalable Vector Graphics Code from Images and Text

- タイトル:StarVector: Generating Scalable Vector Graphics Code from Images and Text

- カンファ:CVPR 2025

- 論文URL:https://arxiv.org/abs/2312.11556

- GitHub: https://github.com/joanrod/star-vector

目次

論文まとめ By Gemini 2.5

はい、承知いたしました。以下に、論文「StarVector: Generating Scalable Vector Graphics Code from Images and Text」に関する質問への回答をまとめます。

・この論文において解決したい課題は何?

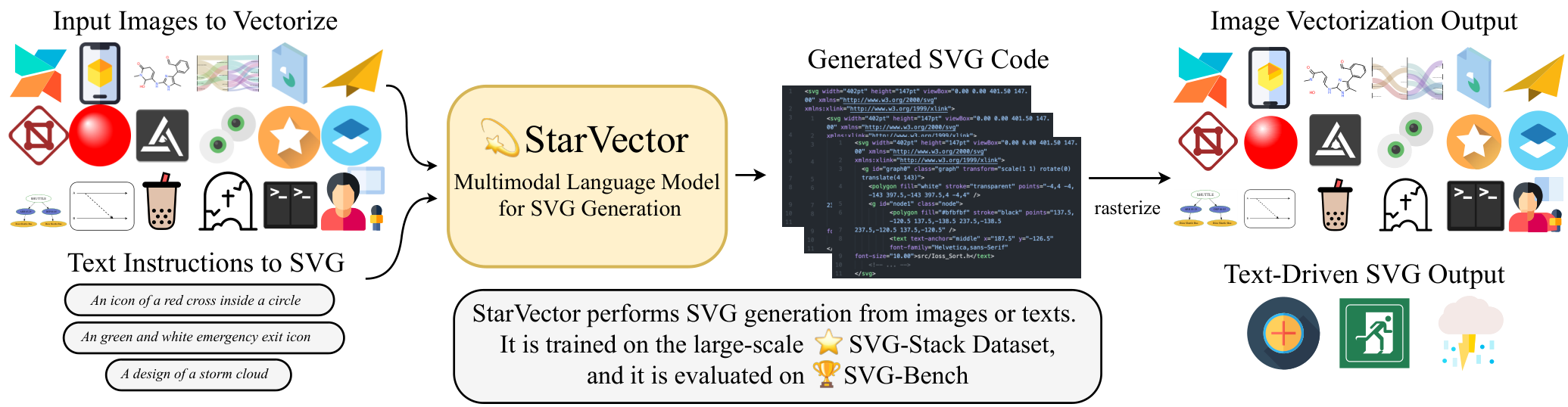

画像やテキストから高品質なSVGコードを生成すること。特に、従来のベクターグラフィックス生成手法が持つ、意味理解の欠如、不自然な生成物、基本的なパス以外のSVGプリミティブの利用不足といった課題を解決することを目指しています。

・先行研究だとどういう点が課題だった?

従来の画像処理ベースの手法は、ピクセルレベルの分析に頼るため、複雑な表現や不自然な生成物を生み出しやすく、意味的な理解に欠けていました。深層学習ベースの手法は、SVGプリミティブの利用が限られており、複雑なSVG(科学的な図など)への対応が難しいという課題がありました。

・先行研究と比較したとき、提案手法の独自性や貢献は何?

提案手法StarVectorは、マルチモーダル大規模言語モデル(MLLM)を活用し、画像の意味を理解し、SVGプリミティブを直接利用してコンパクトで正確なSVGを生成します。また、大規模なSVGデータセットSVG-Stackを構築し、SVGの評価における課題を指摘し、新しい評価指標SVG-Benchを提案しました。

・提案手法の手法を初心者でもわかるように詳細に説明して

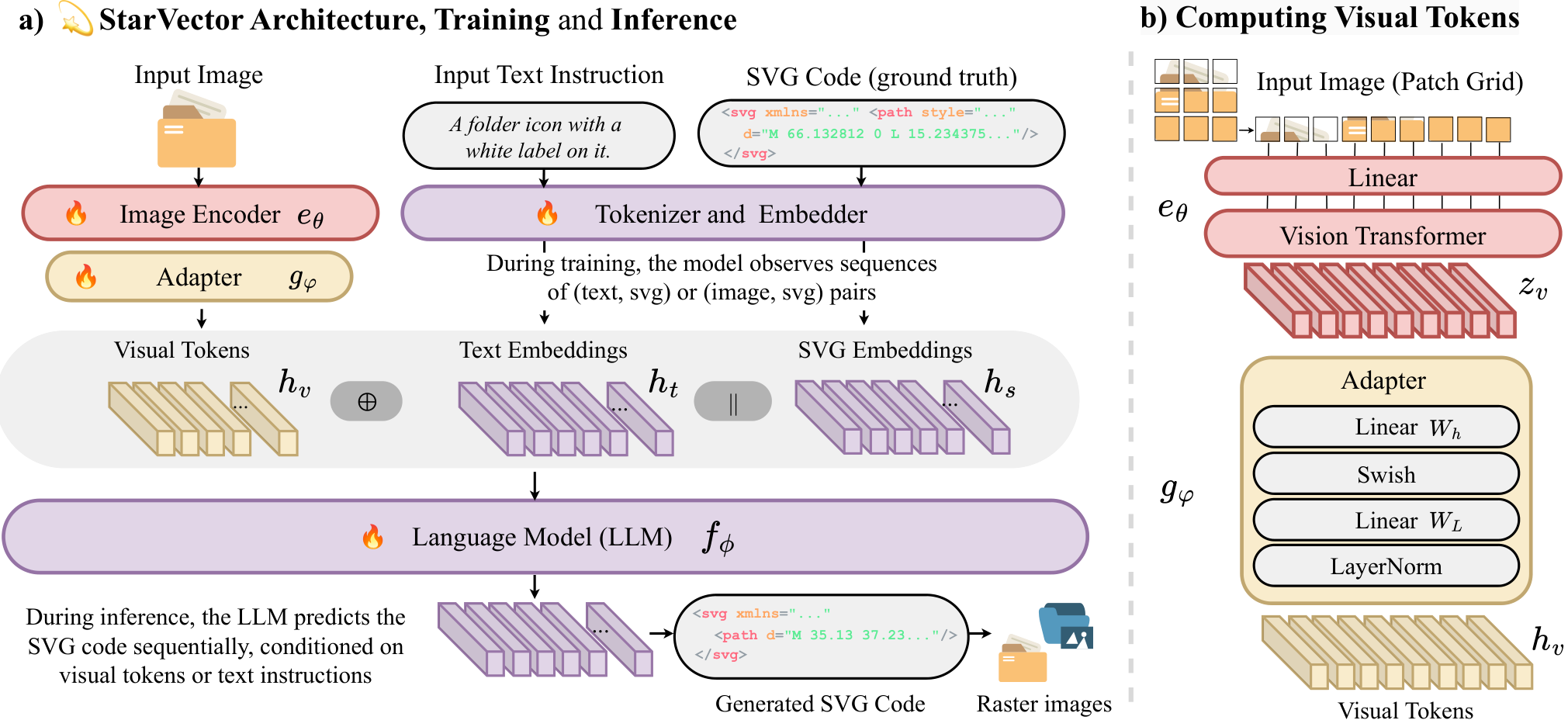

StarVectorは、画像またはテキストを入力として受け取り、それらをSVGコードに変換するモデルです。画像の場合、まず画像エンコーダが画像を「視覚的な単語」(visual tokens)に変換します。次に、大規模言語モデル(LLM)が、これらの視覚的な単語とテキストによる指示に基づいて、SVGコードを順番に生成します。このとき、LLMはSVGの基本的な要素(円、四角形、パスなど)を組み合わせて、最終的なSVG画像を作り上げます。

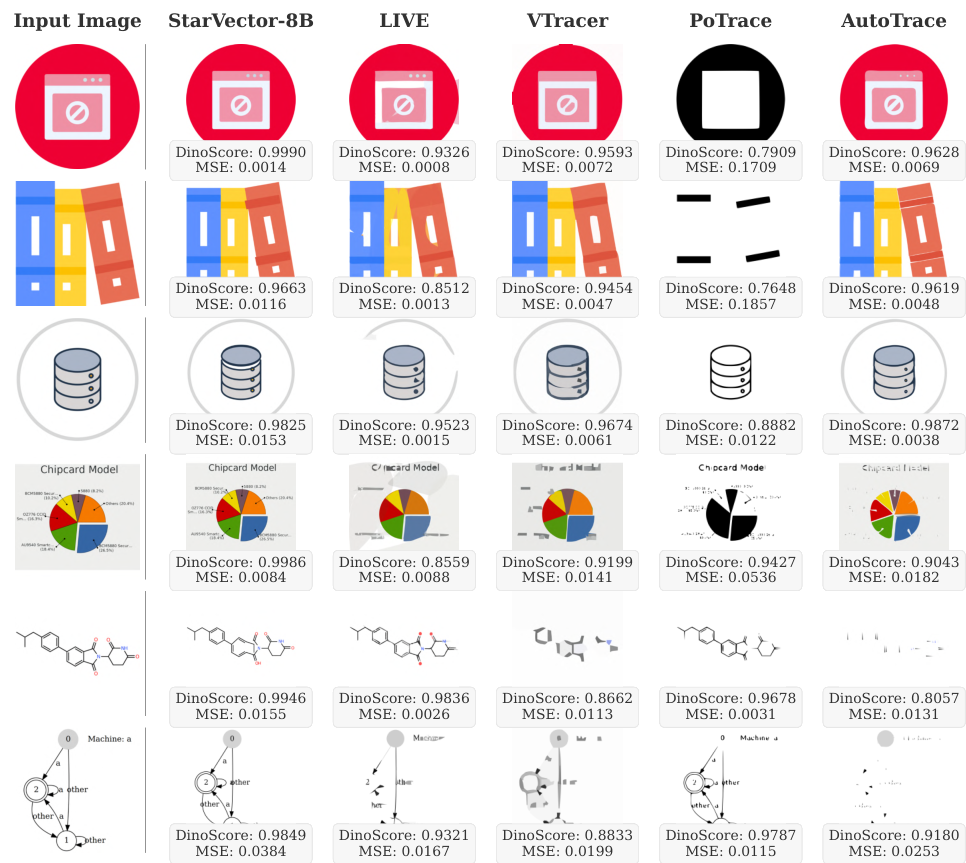

・提案手法の有効性をどのように定量・定性評価した?

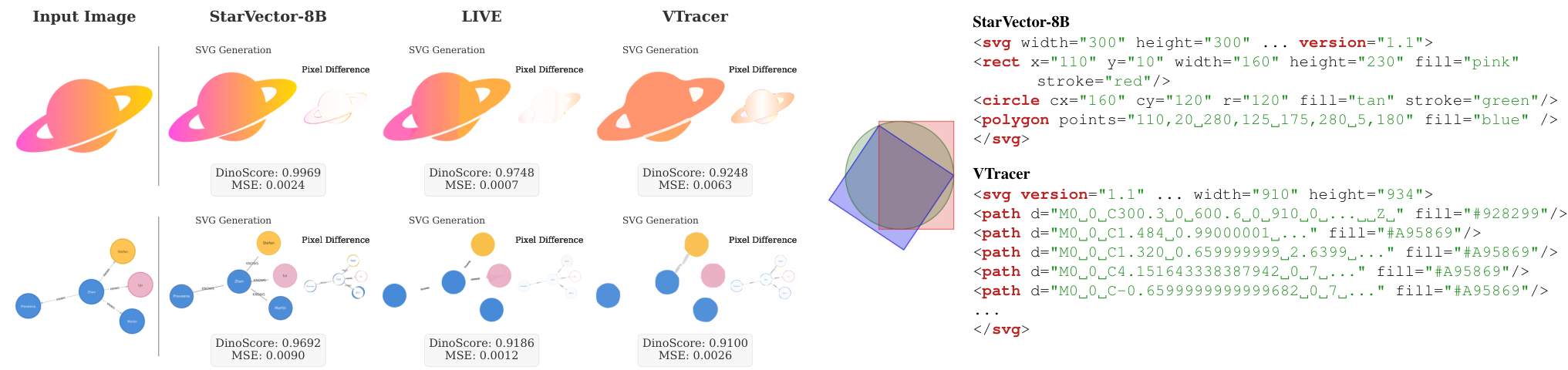

定量評価では、MSE、SSIM、LPIPSといった従来のピクセルベースの指標に加え、提案されたDinoScoreを用いて評価しました。定性評価では、生成されたSVG画像を人間が評価し、既存手法との比較を行いました。

・この論文における限界は?

StarVectorの限界として、16kトークンというコンテキスト長の制約があり、複雑なSVGに対応できない場合があります。また、生成速度がLLMに依存している点や、視覚的なフィードバックが少ない点も挙げられています。

・次に読むべき論文は?

論文中で引用されている以下の論文などが考えられます。

- StarCoderに関する論文: [42, 49]

- DINOに関する論文: [57]

- SVG編集に関する論文: [12]

・コード

論文中にStarVectorのコードは提示されていませんが、以下のリンクが提示されています。

- https://starvector.github.io/ (プロジェクトのウェブサイト)

上記ウェブサイトで、関連情報や今後のアップデートが公開される可能性があります。

補足(Notebook LM)

VLLMの画像トークン化と比べてSVG特有のトークン化はなにか工夫してる?

StarVectorにおけるトークン化について、画像入力とSVGコード生成のそれぞれでどのように行われているか、ソースに基づいてご説明します。

まず、StarVectorは入力として画像またはテキスト指示を受け付け、SVGコードを生成します。

- 画像入力の処理(ビジュアルトークン化):

- 画像を入力として受け取った場合、StarVectorはこれを「ビジュアルトークン」と呼ばれる形式に変換します。

- このプロセスにはImage EncoderとAdapterが使用されます。Image Encoder(例えばCLIP ViTやSigLip)は入力画像からフラット化されたグリッド特徴を計算し、Adapterがこれらのビジュアル特徴をLLM(大規模言語モデル)の隠れ空間の次元に投影します。

- これにより、画像はLLMが処理できる一連のビジュアルトークン表現となります。これはピクセルデータを意味のあるビジュアル特徴に変換するステップであり、SVGコード自体の構造を直接的に捉えるものではありません。

- SVGコードの処理(テキストトークン化):

- 一方、SVGコードはテキスト文字列です。StarVectorは、テキスト指示と同様に、このSVGコードをLLMの標準的な「トークナイザーとエンベッダー」を使用して処理します。

- これにより、SVGコードのテキスト文字列は、LLMの語彙における一連のトークン(例えば、

<svg>,<path>,d=,"M 0 0 ..."などのシンタックス要素や値に対応するトークン)に変換され、埋め込みベクトルとして表現されます。 - StarVectorは、このトークン化されたSVGコードシーケンスに対して、次のトークンを予測する言語モデリングの損失関数を用いて学習を行います。つまり、LLMは画像からのビジュアルトークンやテキスト指示のトークンを条件として、適切なSVGコードのテキストトークンシーケンスを生成することを学習します。

VLLMに代表されるような一般的な画像トークン化手法がピクセル情報から視覚的な特徴を捉えるビジュアルトークンを生成するのに対し、StarVectorにおけるSVGコードのトークン化は、SVGというマークアップ言語のテキストシンタックス自体をLLMの語彙トークンとして扱うという点に違いがあります。

SVG特有の「工夫」という観点では、StarVectorの革新性は、SVGコード自体のトークン化の方法(例えば、SVGの構造を考慮した特別なトークン分割)にあるというよりも、むしろ以下の点にあります。

- SVGコード空間での直接的な操作: MLLMが画像の意味論を理解し、ピクセルベースの近似ではなく、SVGのプリミティブ(

<rect>,<circle>,<polygon>,<text>など)を効果的に利用して、よりコンパクトでセマンティクスに忠実なSVGコードのテキストシーケンスを生成することを学習した点です。これは、LLMがテキストトークンとして表現されたSVGシンタックスを、単なる文字列ではなく、構造化されたグラフィック表現として理解・生成できるようになったことを意味します。 - 大規模SVGデータセットでの学習: StarVectorは、画像、テキスト、および多様なSVGコード(プリミティブを含む)からなる大規模データセットであるSVG-Stackで訓練されており、これによりモデルは様々なタイプのSVG構造を学習し、汎化能力を高めています。

- 長いコンテキスト長の処理: SVGコードは複雑になると非常に長くなるため、StarVectorはStarCoder2のような長いコンテキスト長(最大16kトークン)を扱えるLLMを基盤として採用しています。これは、SVGコードのテキストトークンシーケンスが長くなることへの対応です。

したがって、StarVectorにおける「SVG特有のトークン化の工夫」は、SVGコードをテキストとしてトークン化した上で、それをLLMが理解し、画像の視覚情報やテキスト指示と関連付けて、構造化されたSVGコード(プリミティブを適切に使用したコード)として生成できるように学習した点に主要な貢献があると言えます。SVGコードのテキストとしてのトークン化プロセス自体に、一般的なテキストトークン化手法と根本的に異なる特別な手法が用いられているという具体的な記述はソースには見られません。

SVG-Benchとはどういうもの?

SVG-Benchは、Scalable Vector Graphics(SVG)の生成手法を評価するために導入された、統一されたベンチマークスイートです。StarVectorの研究チームによって、従来のSVGデータセットや評価手法の限界に対応するために開発されました。

SVG-Benchは以下の点に特徴があります。

- 評価対象タスクの網羅性: SVG-Benchは、SVG生成における主要な3つのタスクを評価対象としています。

- Image-to-SVG: ピクセルベースのラスター画像をSVGに変換するタスクです。難易度の異なるSVG-Fonts、SVG-Emoji、SVG-Icons、SVG-Stackなどのデータセットを含みます。

- Text-to-SVG: テキスト指示に基づいてSVGを生成するタスクです。SVG-StackテストセットやSVG-FIGRデータセットを使用します。

- Diagram Generation: ダイアグラム、グラフ、ワークフローなど、テキスト、矩形、矢印などのプリミティブを含む特定の種類のSVG生成に焦点を当てたタスクです。SVG-Diagramsテストセットが含まれます。

- 多様なデータセット: SVG-Benchには、画像、テキスト、SVGコードの多様な組み合わせからなる、大規模なSVG-Stackデータセットを含む複数のデータセットが含まれています。これらのデータセットは、フォント、アイコン、絵文字といったシンプルなものから、複雑なダイアグラムまで、幅広い種類のSVGを網羅しており、モデルの汎化能力を評価するのに役立ちます。過去にアクセスが難しかったデータセットも含まれており、再現性を向上させています。StarVectorが基盤としているStarCoder2のコンテキスト長(最大16kトークン)を考慮し、8192トークンまでのサンプルが主に含まれていますが、より長いコンテキスト長を評価するためのデータセットバージョンも提供されています。また、一部のベースライン(DeepSVGなど)との互換性のために、パスのみを含む簡易化されたバージョンのデータセットも用意されています。

-

改善された評価指標: 従来のImage-to-SVG評価で広く用いられてきたMSE(Mean Squared Error)やSSIM(Structural Similarity Index)といったピクセルベースの指標は、SVGのユニークな特性(例えば線定義、プリミティブ使用、構造)を適切に評価できないという限界が指摘されています。これらの指標はピクセルレベルの正確さを重視するため、過度に複雑でセマンティクスに忠実でないSVG(多数のパスで構成されるもの)を高く評価する傾向があります。図2でも、StarVectorが色グラデーションやテキストをより良く維持しているにも関わらず、MSEスコアでは劣る例が示されています。SVG-Benchではこの問題に対処するため、DinoScoreという新しい評価指標を提案しています。DinoScoreは、DinoV2特徴間のL2距離を計算する知覚的類似性指標であり、人間の視覚的認識やSVGのセマンティックな忠実性(プリミティブの適切な使用など)をよりよく捉えることが示されています。StarVectorは、MSEでは他の手法に劣る場合があるものの、DinoScoreでは優れたパフォーマンスを示しており、人間による評価でもStarVectorの出力が明確に好まれることが確認されています。SVGコードのサイズ(コンパクトさ)を評価するために、StarCoderトークナイザーを使用したToken Lengthも指標として含まれます。Text-to-SVGタスクでは、FID、FID-CLIP、CLIP Scoreといった画像-テキストアライメント指標も使用されます。

-

包括的なベースライン評価: SVG-Benchでは、従来の画像処理手法(Potrace, VTracer, Autotraceなど)や、Deep Learningベースの手法(DeepSVG, Im2Vec, LIVE, DiffVGなど)、さらに他のMLLMやLLM(GPT-4V, CodeLlama, GPT-4など)といった幅広いベースラインモデルを、SVG-Benchのデータセットと評価指標を用いて統一的に評価しています。これにより、StarVectorの性能を様々な既存手法と比較することができます。

要約すると、SVG-Benchは、SVG生成モデルの包括的かつより適切な評価を可能にするために開発された、多様なデータセットとタスク、そしてSVGの特性に適した評価指標(特にDinoScore)を含むベンチマークです。これにより、特にStarVectorのようなSVGプリミティブを活用できるモデルの強みが正当に評価されるようになります。

これの訓練に必要なGPUは記載あった? 必要なデータ数はどれぐらい?

ご質問ありがとうございます。StarVectorの訓練に必要な計算リソース(特にGPU)と、学習に使われたデータセットの規模について、ソースに基づいてご説明します。

訓練に必要なGPUについて

StarVectorの論文には、モデルの2つの主要なバリアント、StarVector-1BとStarVector-8Bの訓練に使用された具体的なGPU構成が記載されています。

- StarVector-1B: 8台のA100 80GB GPU を1つのノードで使用し、7日間訓練されました。

- 別の箇所では、StarVector-1BのImage-to-SVGタスクの訓練において、4台のA100 80GB GPUを使用したデータ並列設定が言及されています。

- StarVector-8B: 8台のH100 80GB GPUを8ノードで使用し(合計64台のH100 GPU)、10日間訓練されました。StarVector-8Bは、より高い画像解像度と拡張されたコンテキスト長(16kトークン)を持つため、より大きな計算リソースが必要とされています。

これらの記述から、StarVectorのような大規模なMLLM(マルチモーダル大規模言語モデル)を訓練するには、高性能かつ多数のGPUが必要であることがわかります。

訓練に必要なデータ数について

StarVectorは、主にStarVectorの研究チームによって開発された大規模なSVG-Stackデータセットで訓練されています。

- SVG-Stackデータセットの規模:

- 訓練用: 210万サンプル

- 検証用: 10万8千サンプル

- テスト用: 5千7百サンプル

- データの内容: SVG-Stackの各サンプルは、対応するラスター画像とテキスト記述、そしてSVGコードのペアとなっています。このマルチモーダルなデータ構造が、StarVectorが画像とテキストの両方からSVGを生成する能力を学習することを可能にしています。SVG-Stackは、ウェブ上で実際に使用されている多様なSVGコードから収集されており、様々なシンタックス構造やSVGプリミティブ(

<circle>,<rect>,<text>など)を含んでいます。 -

Text-to-SVGのためのデータ拡張: Text-to-SVG生成タスクのために、研究チームはSVG-Stackの画像に対して、BLIP2やLlavaといった既存の画像キャプションモデルを使用して、合成的にテキストキャプションを生成しました。これにより、合計で400万件のテキストキャプションとSVGのペアを持つデータセットが構築されています。

したがって、StarVectorの訓練には、数百万規模のSVGコード、画像、テキストのペアからなる大規模なデータセットが必要であり、それを処理するためには数十台の高スペックGPUが必要であると言えます。特に、SVGの多様な構造や長いコンテキスト長を学習するために、大規模なデータセットと計算リソースが不可欠であることが示されています。

Shikoan's ML Blogの中の人が運営しているサークル「じゅ~しぃ~すくりぷと」の本のご案内

技術書コーナー

北海道の駅巡りコーナー