論文まとめ:Video-LLaVA: Learning United Visual Representation by Alignment Before Projection

- 論文URL:Video-LLaVA: Learning United Visual Representation by Alignment Before Projection

- 著者:Bin Lin, Yang Ye, Bin Zhu, Jiaxi Cui, Munan Ning, Peng Jin, Li Yuan

- 論文URL:https://arxiv.org/abs/2311.10122

- コード:github.com/PKU-YuanGroup/Video-LLaVA

- Demo:https://huggingface.co/spaces/LanguageBind/Video-LLaVA

目次

ざっくりいうと

- 動画静止画両方に対応しているVision & Language Modelの研究

- 動画と静止画のアラインメントを精度向上につなげているのが特徴で、CLIPの言語空間を媒介にして動画と静止画のアラインメントをとる

- 動画と静止画を共同で訓練することでさらに精度を上げ、2023年11月時点で既存研究ではSoTA

導入

- VideoChatとVideoLLaMAは動画とテキストで共通のVisual Encoderを使用

- 画像や動画のメディアタイプには固有の差があるため、統一的な表現の学習は困難。その性能は動画専門のVideo-ChatGPTに大きく劣る

- XLLMとMacaw-LLMは、モダリティごとに固有のエンコーダーを割り当ててLLMが複数の投射層を通じて画像・動画を理解するようにする

- これでもVideo-ChatGPTのような専用の動画モデルに劣る

- この理由は、投射前のアラインメントがないことが原因であると考えられる

- 画像特徴量と映像特徴量はそれぞれ独立した空間に存在するため、LLMが貧弱な投射層からその相互作用を学習することは困難

- 融合前のアラインメントはALBEFやViLTなどのモデルでも議論されている

- ImageBind-LLMは、間接アラインメントアプローチ。動画をキャッシュデータベースに入れて、画像の空間にアラインメントさせる

- 実際はビデオデータに対する知識がなく、性能低下を招く可能性がある

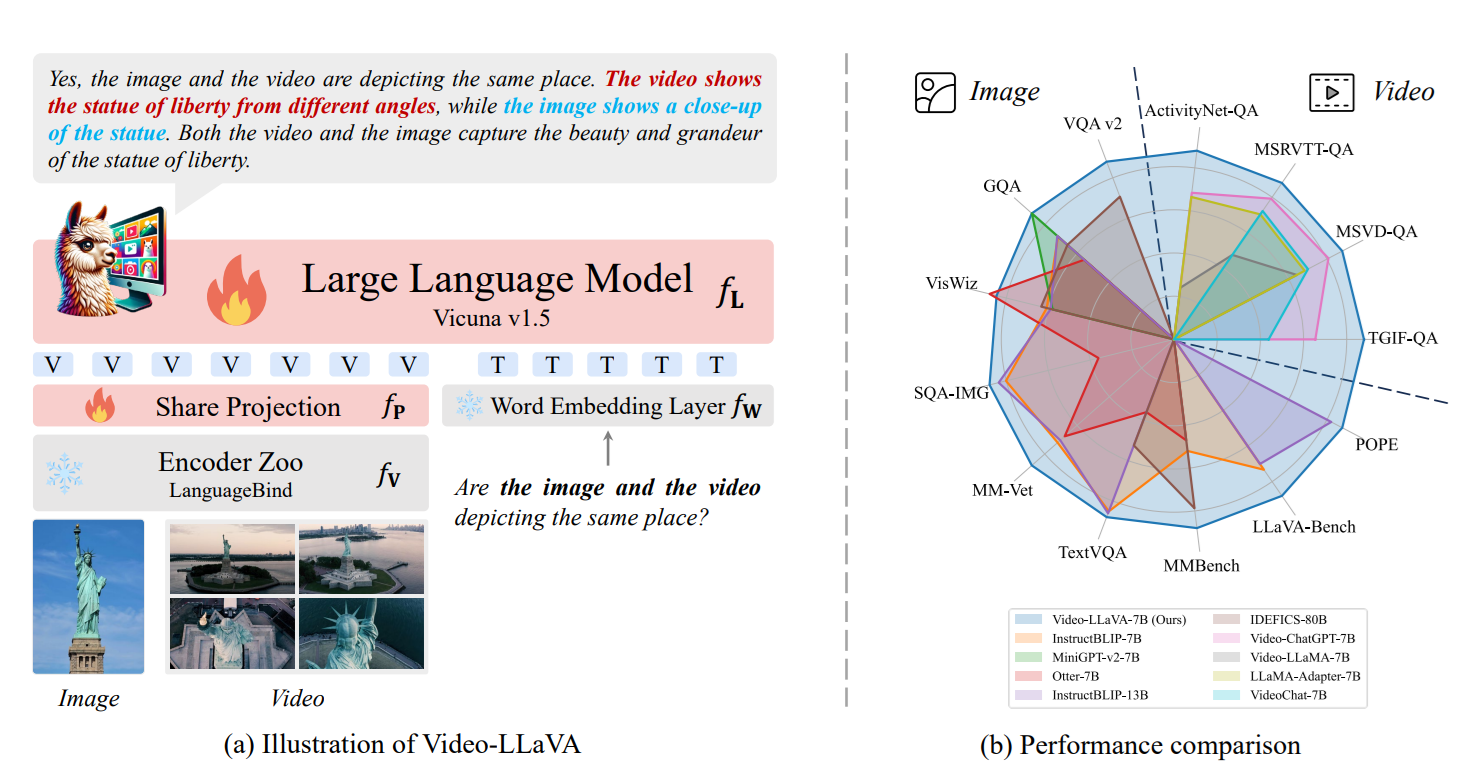

- 本手法では、画像と動画を事前にアラインメントさせて、共通の投射レイヤーに入れる

- これにより、画像と動画の精度を両方向上させる

手法

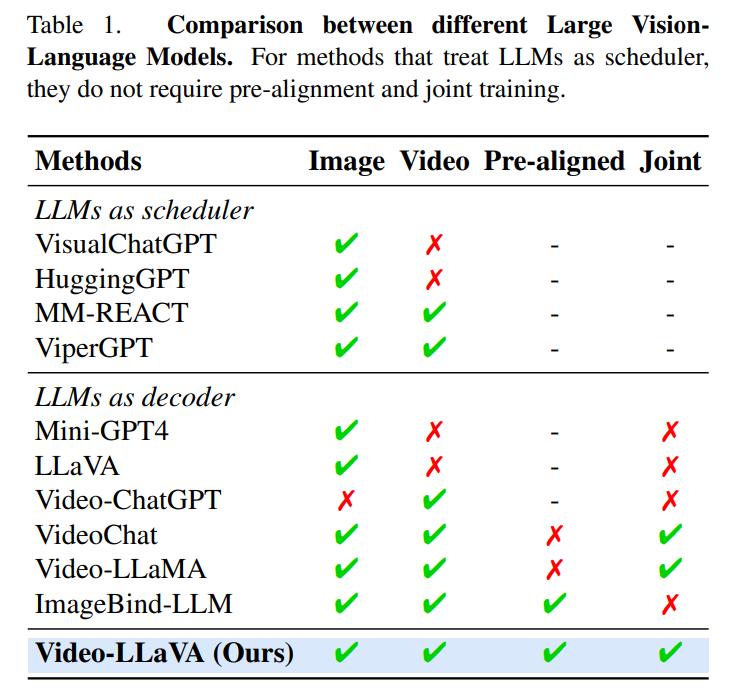

VLMの類型化

- LLM as scheduler

- 画像や動画をキャプション生成させて、LLM(ChatGPT)などに通す→例:VisualChatGPT

- End-to-Endの学習が不要なので、事前学習や共同訓練が不要

- LLM as Decoder

- Vision Encoderなどで中間表現に落とし込んで、LLMに文章生成させる

- MiniGPT-4などが例。アラインメントが弱い

- mPLUG-Owlは2段階の学習アプローチを採用。1段階目は自己回帰的な事前学習を使って言語とアラインメントをとり、2段階目ではInstruction Tuningを行う

- InstructBLIPやLLaVAではより大規模なInstruction Tuningのデータセットを使用し、より大きなVLMを学習

- Vidoeo-ChatGPTはInstruction Tuningを動画に拡張

動画への拡張(LLM as Decoder)

- VideoChatとVideoLLaMAはLLMが、画像と動画を同時に扱えるようにした

- LLMA-AdapterやImageBind-LLMはImageBindのモダリティエンコーダーによって、他のモダリティを画像空間にバインド

- Video-LLaVAは先行研究と異なり、動画と画像の共同学習を行い、統一的な表現からマルチモーダル推論を行う

投射前のアラインメント

- 画像や動画をテキスト特徴空間に整合させるために、先行研究の「LanguageBind」のモダリティエンコーダーを選択

- LanguageBindはOpenCLIPで初期化し、共通空間に空間において画像と言語を自然にアラインメント

- その後、VIDAL-10Mの300万組のビデオテキストを用いて、ビデオ空間と言語空間にアラインメントさせる

- これを「画像と映像の創発的アラインメント」と呼んでいる

→結局やっているのは、画像も動画もCLIPのテキスト空間をベースにアラインメントさせているだけ?

実験

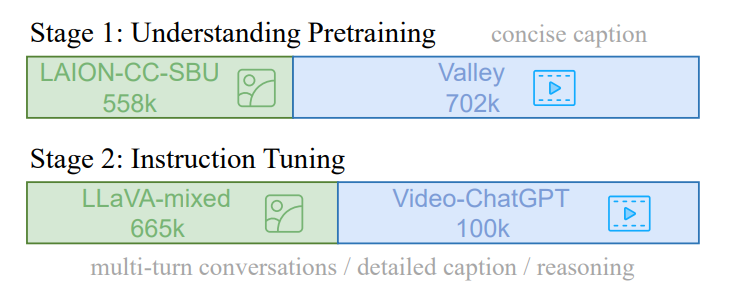

データ

- 事前訓練

- CC3Mから入手し、先行研究によってフィルタリングされたBLIPキャプション付きの558K LAION-CCSBUのサブセットを使用

- ビデオとテキストは、WebVidによって生成された703kのペアのうち、702kにアクセス可能

- Instruction Tuning

- LLaVA v1.5の665k画像-テキストのInstruction Tuningのデータセット

- Video-ChatGPTの100kビデオ-テキストデータセットを収集

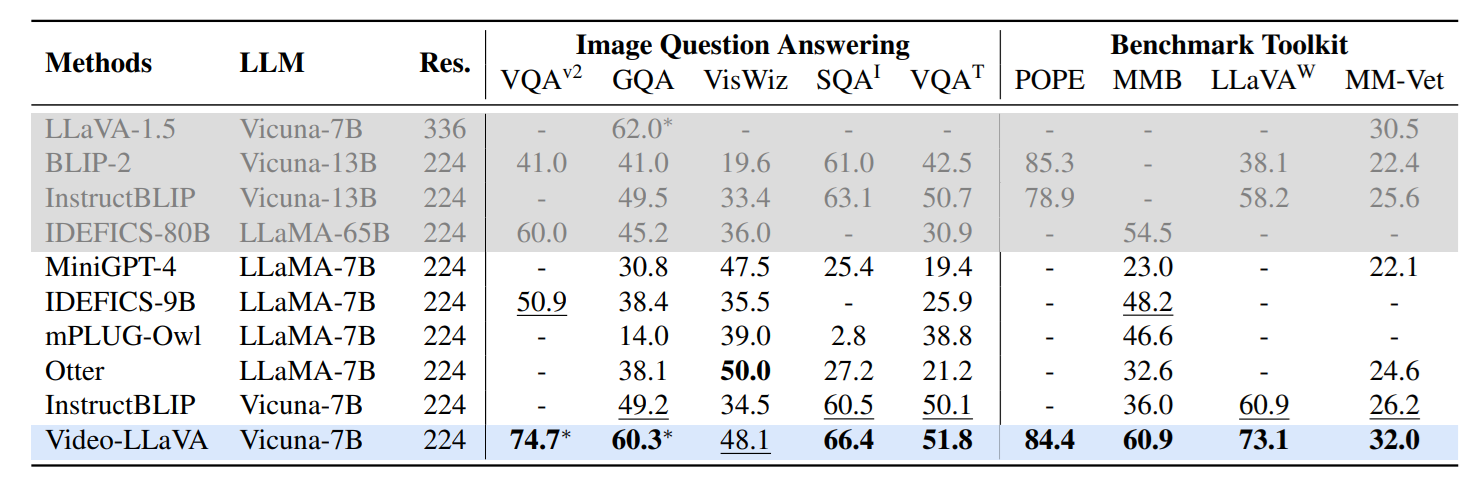

定量評価

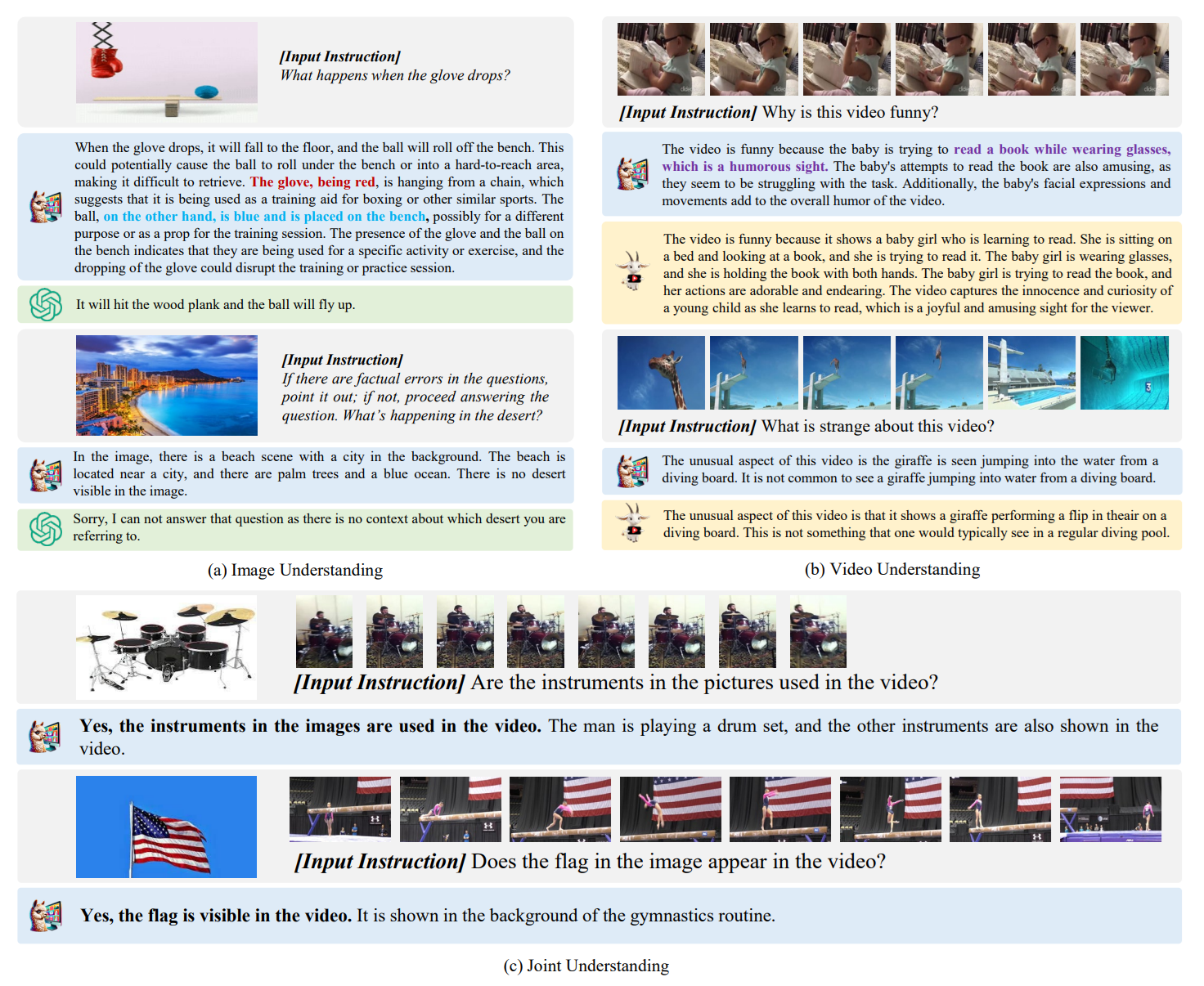

定性評価

アラインメントや共同学習の効果

- アラインメントの効果。Unitedはアラインメントあり、Separatedは分離された視覚表現

- 動画と画像を同時に訓練することで、静止画、動画のいずのモダリティにおいても精度が向上することがわかった

試してみる

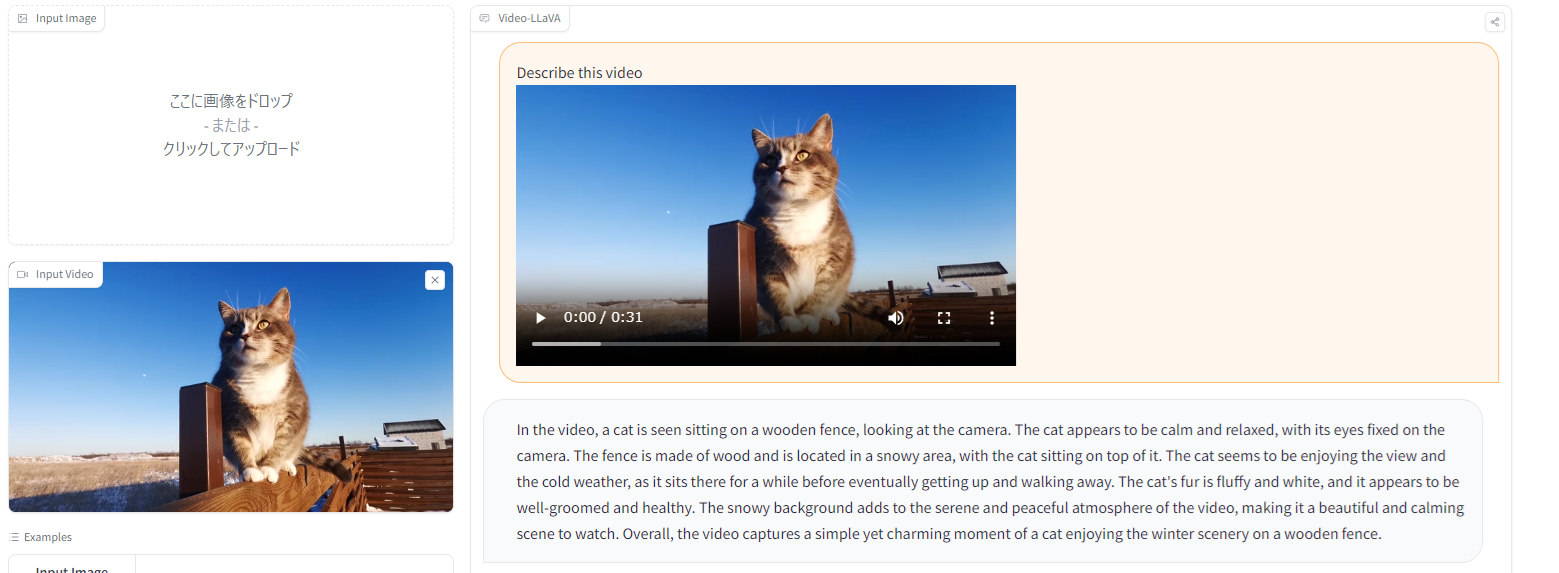

静止画

→普通にできる

動画

サンプル1

https://www.pexels.com/video/the-cat-scratched-the-wood-3693815/

プロンプト:「Describe this video」

→この例はいける

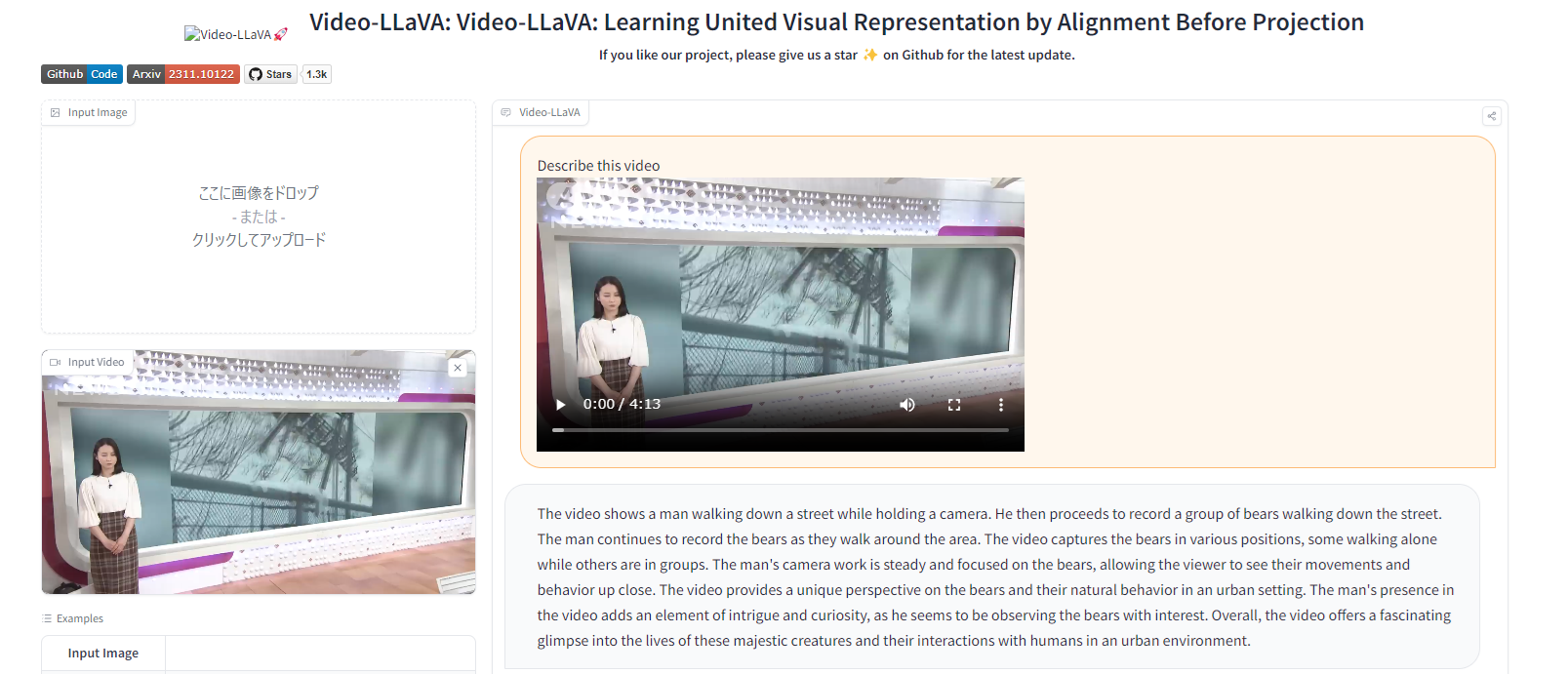

サンプル2

相次ぐクマ被害で希望者急増“新人ハンター”の葛藤(2023年11月17日)

https://www.youtube.com/watch?v=H5RHuImlVTQ

プロンプト:「Describe this video」

The video shows a man walking down a street while holding a camera. He then proceeds to record a group of bears walking down the street. The man continues to record the bears as they walk around the area. The video captures the bears in various positions, some walking alone while others are in groups. The man’s camera work is steady and focused on the bears, allowing the viewer to see their movements and behavior up close. The video provides a unique perspective on the bears and their natural behavior in an urban setting. The man’s presence in the video adds an element of intrigue and curiosity, as he seems to be observing the bears with interest. Overall, the video offers a fascinating glimpse into the lives of these majestic creatures and their interactions with humans in an urban environment.

そのビデオには、カメラを構えながら通りを歩く男の姿が映っている。そして、通りを歩くクマの群れを記録していく。男はクマが辺りを歩く様子を記録し続ける。映像はクマたちをさまざまな姿勢で捉えており、単独で歩くクマもいれば、集団で歩くクマもいる。男性のカメラワークは安定しており、クマに焦点を合わせているため、視聴者はクマの動きや行動を間近で見ることができる。このビデオは、都市環境におけるクマとその自然な行動について、ユニークな視点を提供している。ビデオに登場する男性は、クマに興味を持って観察しているようで、好奇心をそそる。全体として、このビデオは、この雄大な生き物の生活と、都市環境における人間との相互作用を垣間見ることができる魅力的なものである。

→ 音声を見ていないため、ニュースの内容は把握していない

※ただ、4分ぐらいの動画でも10秒ぐらいで答えがかえってくるのがすごい!

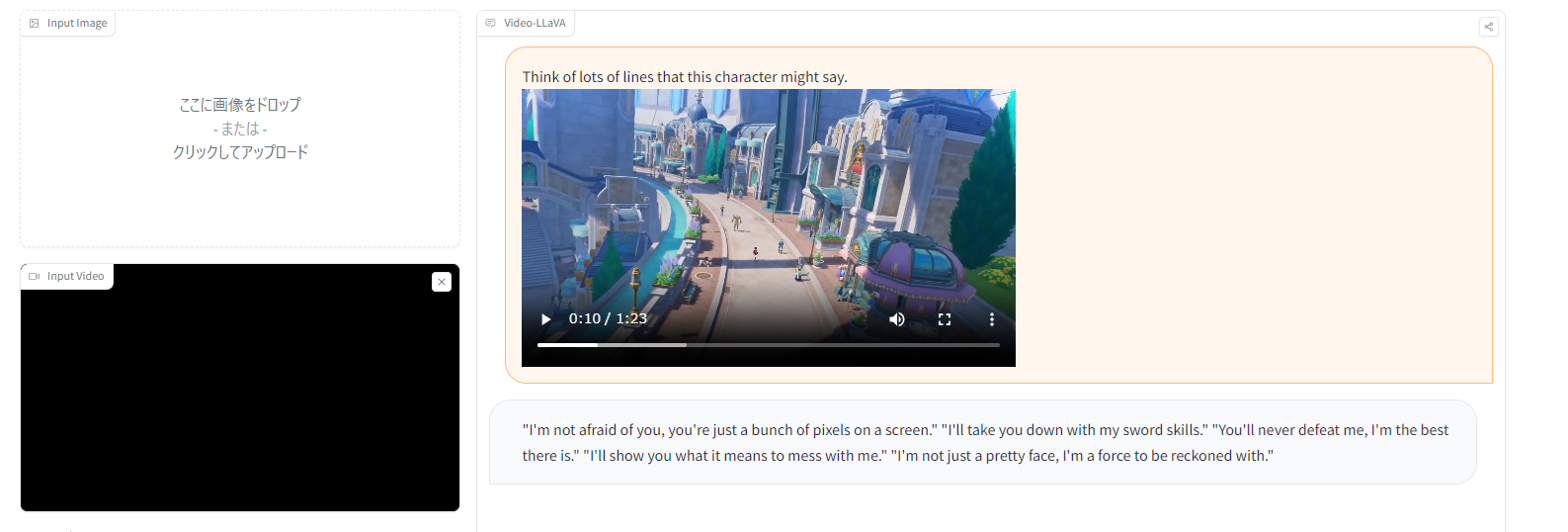

サンプル3

【原神】キャラクター実戦紹介 シャルロット(CV:和氣あず未)「特ダネよ!」

https://www.youtube.com/watch?v=wMtRwzt36qM

プロンプト:「Think of lots of lines that this character might say.」

“I’m not afraid of you, you’re just a bunch of pixels on a screen.” “I’ll take you down with my sword skills.” “You’ll never defeat me, I’m the best there is.” “I’ll show you what it means to mess with me.” “I’m not just a pretty face, I’m a force to be reckoned with.”

“お前なんか怖くない、お前は画面の中のただのピクセルの集まりだ” ” 私の剣の腕でお前を倒す ” “お前に私は倒せない、私が最強だ” “私にちょっかいを出す意味を教えてやる” “私はただの美人じゃない 力がある”

感性がだいぶ違いそう

所感

- 「アラインメントが大事」というのはNLPで少し前に言われていたことなので、これがマルチモーダルの世界にきたのが時代が進んできた感

- VLMの進化が丁寧に書かれてたのがよかった!

- 長めの動画に対して推論が速いのが◎だが、ここまでくると複数動画やりたくなる

- タイトルがすごくALBEF(Align before fuse)を思い出す。ただ、ALBEFからその先もLLMなしで結構進化したので、もっと進化しそう

- LLaVA(LLaMA)のライセンスが唯一の問題

- Projectionだけでなく、LLMも訓練しているので相当重そうだが、GPUがどの程度必要なのか書かれていなかったのがよくない

Shikoan's ML Blogの中の人が運営しているサークル「じゅ~しぃ~すくりぷと」の本のご案内

技術書コーナー

北海道の駅巡りコーナー